Генерация и отбор признаков

В реальных задачах вы столкнетесь с широким спектром трудностей, и одним из первых этапов будет подготовка данных. Уже на этом этапе есть ряд возможных проблем, например:

Нехватка данных — у вас может быть мало данных. Более того, понять, какой объем данных необходим — тоже отдельная задача. Другая вариация похожей проблемы — это большой объем данных, но без разметки.

Некачественная разметка — даже в широко известных MNIST, CIFAR-10 и ImageNet есть ошибки в разметке 🎮[demo]. В вашем датасете они тоже будут. Важно понимать, что разметка может не являться бесспорным эталоном.

Шум в данных — полезно подумать о потенциальной зашумленности данных. Например, когда люди заполняют таблицы, они могут допускать ошибки. Хорошо понимать, какого рода ошибки могут содержаться в ваших данных.

Несбалансированность датасета — какие-то классы могут быть плохо представлены (минорные классы). Например, если в вашем датасете будет всего 10 фотографий одного класса и 10 000 другого, то модели будет очень заманчиво вообще не пытаться определять минорный класс (всего 0.1% ошибок).

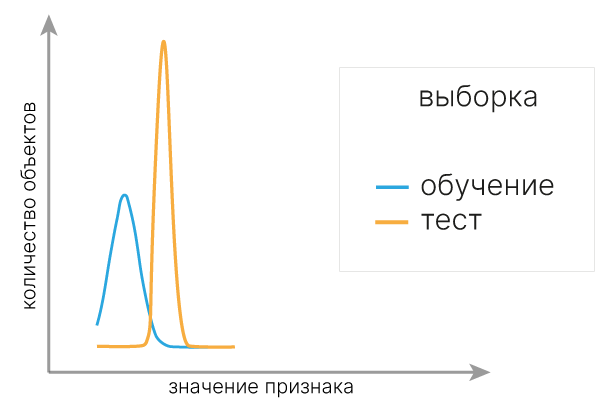

Ковариантный сдвиг — явление, когда признаки тренировочной и тестовой выборок распределены по-разному. Из-за этого мы можем получать плохие предсказания на тестовой выборке, когда модель просто не знает, что признаки могут находиться в другом распределении.

Практический совет: для быстрого обнаружения ковариантного сдвига можно обучить модель, которая будет предсказывать, относится ли объект к train или test выборке. Если модель легко делит данные по такому принципу, то имеет смысл визуализировать значения признаков, по которым она это делает.

Малое число источников данных — проблема, родственная предыдущей. В вашем датасете могут быть данные только от одного прибора или одной модели прибора. Могут быть данные, снятые только одним специалистом, или в одной больнице, или только у взрослых. Это также может влиять на способность вашего алгоритма обобщать полученное решение и требует пристального внимания.

Грязные данные — в данных могут быть полные/неполные дубликаты, пропуски, ошибки форматов, перемешанные столбцы и многое другое. Такие проблемы могут быть как естественной характеристикой (нет данных о каких-то объектах, отсюда пропуски), так и ошибкой при агрегации данных из разных источников. Важно подумать о проверках и тестах, чтобы быть уверенным в качестве.

Все это приводит к целому спектру сложностей, из которых самой типичной будет переобучение модели — какую бы простую модель вы не взяли, она все равно будет выучивать искажения вашего датасета.

Прежде всего надо убедиться, что датасет сбалансирован:

import torch

import matplotlib.pyplot as plt

from sklearn.datasets import load_wine

def show_class_balance(y, classes):

_, counts = torch.unique(torch.tensor(y), return_counts=True)

plt.bar(classes, counts)

plt.ylabel("n_samples")

plt.ylim([0, 75])

plt.show()

wine = load_wine()

classes = wine.target_names

show_class_balance(wine.target, classes)

Разница в 10–20% будет незначительна, поэтому для наглядности мы искусственно разбалансируем наш датасет при помощи метода make_imbalance 🛠️[doc] из библиотеки imbalanced-learn 🛠️[doc].

from imblearn.datasets import make_imbalance

x, y = make_imbalance(

wine.data, wine.target, sampling_strategy={0: 10, 1: 70, 2: 40}, random_state=42

)

show_class_balance(y, classes)

Если в данных нехватка именно конкретного класса, то можно бороться с этим при помощи разных способов сэмплирования.

Важно понимать, что в большинстве случаев данные, полученные таким способом, должны использоваться в качестве обучающего набора, но ни в коем случае не в качестве валидации или теста.

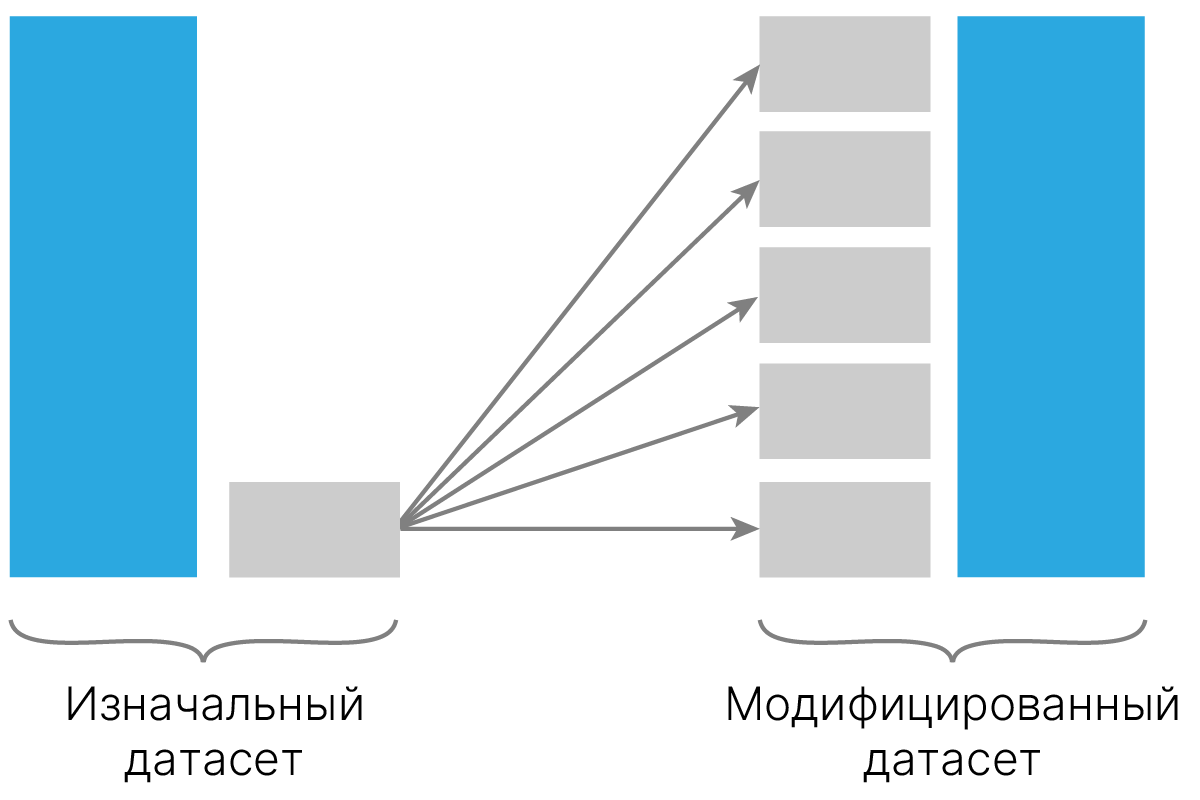

Мы можем увеличить число объектов меньшего класса за счет дублирования.

Такой oversampling может быть выполнен с помощью класса RandomOverSampler 🛠️[doc] из imbalanced-learn, как показано ниже:

from imblearn.over_sampling import RandomOverSampler

ros = RandomOverSampler(random_state=0)

x_ros, y_ros = ros.fit_resample(x, y)

show_class_balance(y_ros, classes)

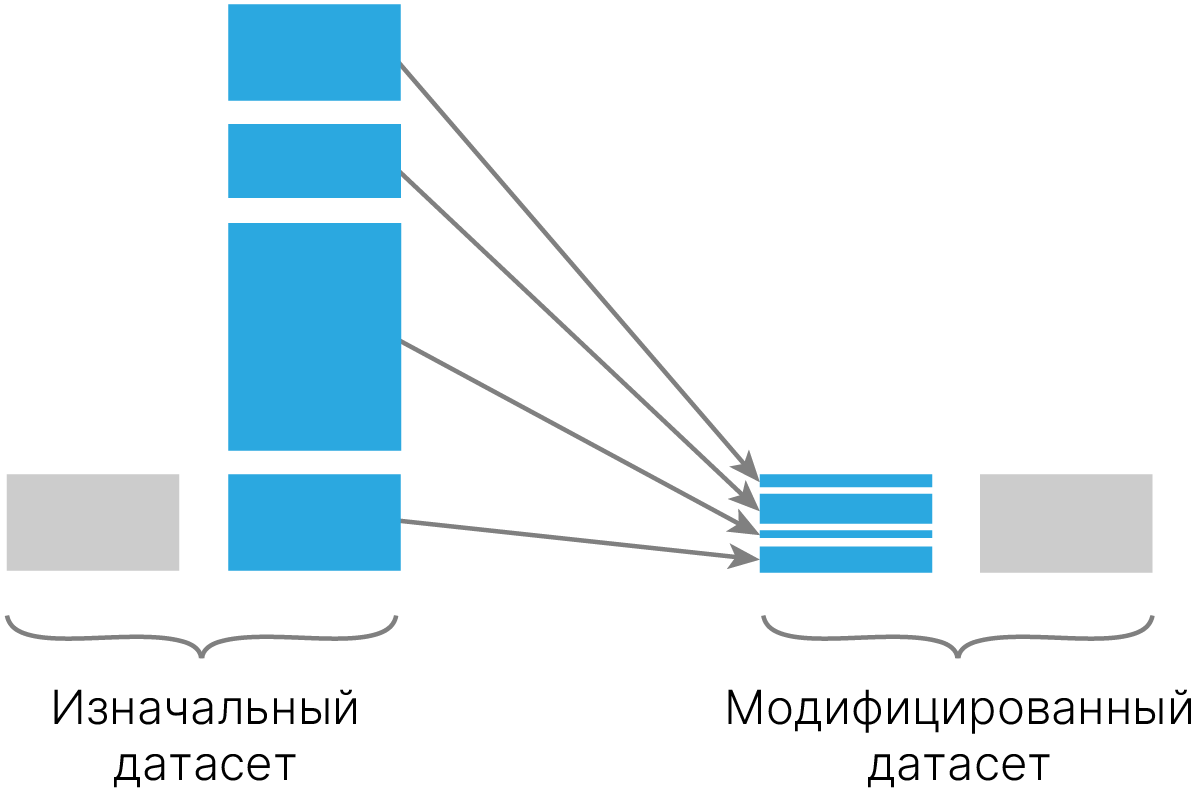

Аналогично, можно взять для обучения не всех представителей большего класса.

from imblearn.under_sampling import RandomUnderSampler

rus = RandomUnderSampler(random_state=42)

x_res, y_res = rus.fit_resample(x, y)

show_class_balance(y_res, classes)

Минус подхода: мы можем выбросить важных представителей большего класса, ответственных за существенное улучшение генерализации, и из-за этого качество модели существенно ухудшится.

Выбрасывать объекты большего класса можно разными способами. Например, кластеризовать объекты большего класса и брать по заданному количеству объектов из каждого класса.

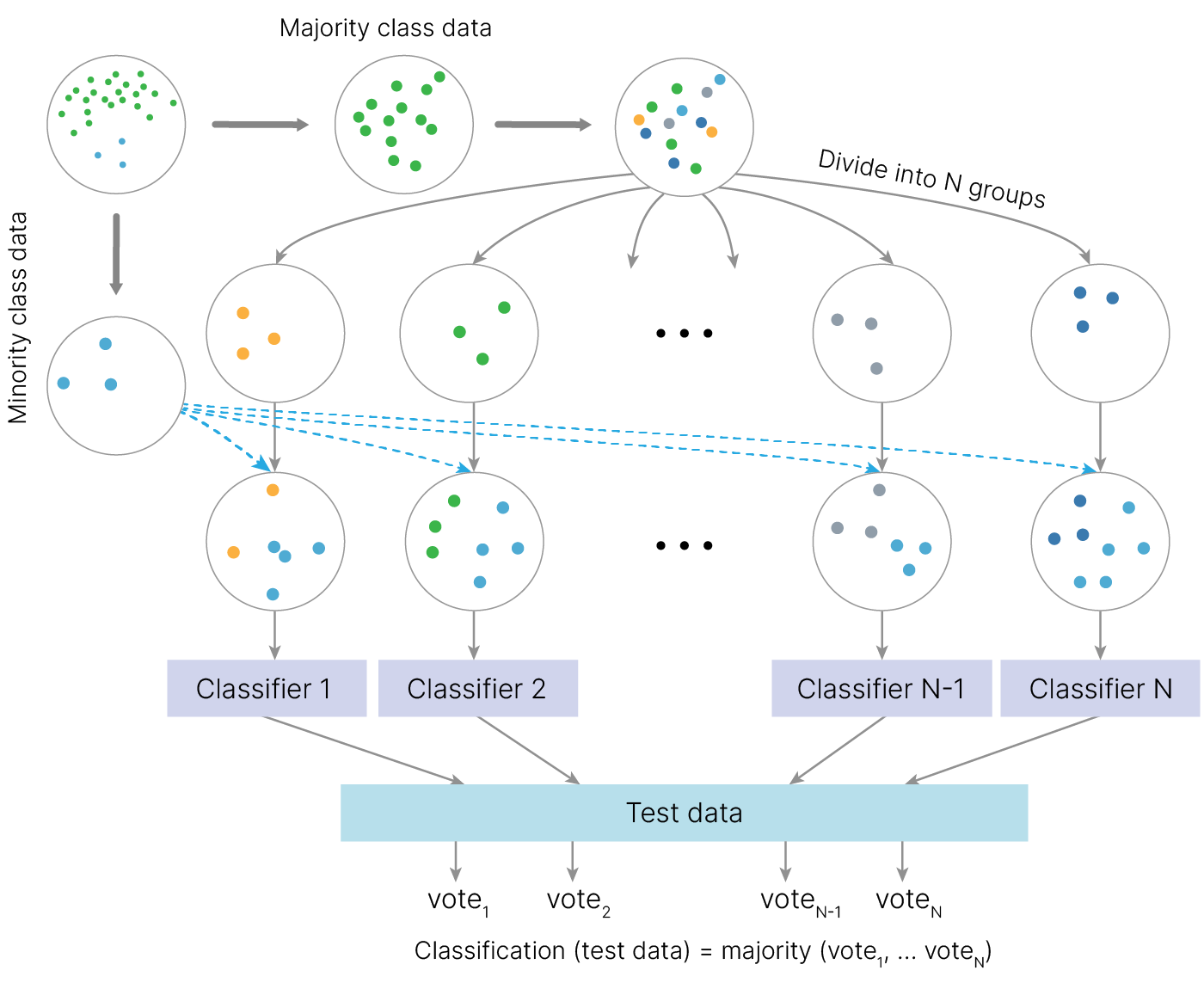

Можно использовать ансамбли вместе с undersampling. В этом случае мы можем, к примеру, делать сэмплирование только большего класса, а объекты минорного класса оставлять как есть.

Или просто сэмплировать объекты и того, и другого класса в равном количестве.

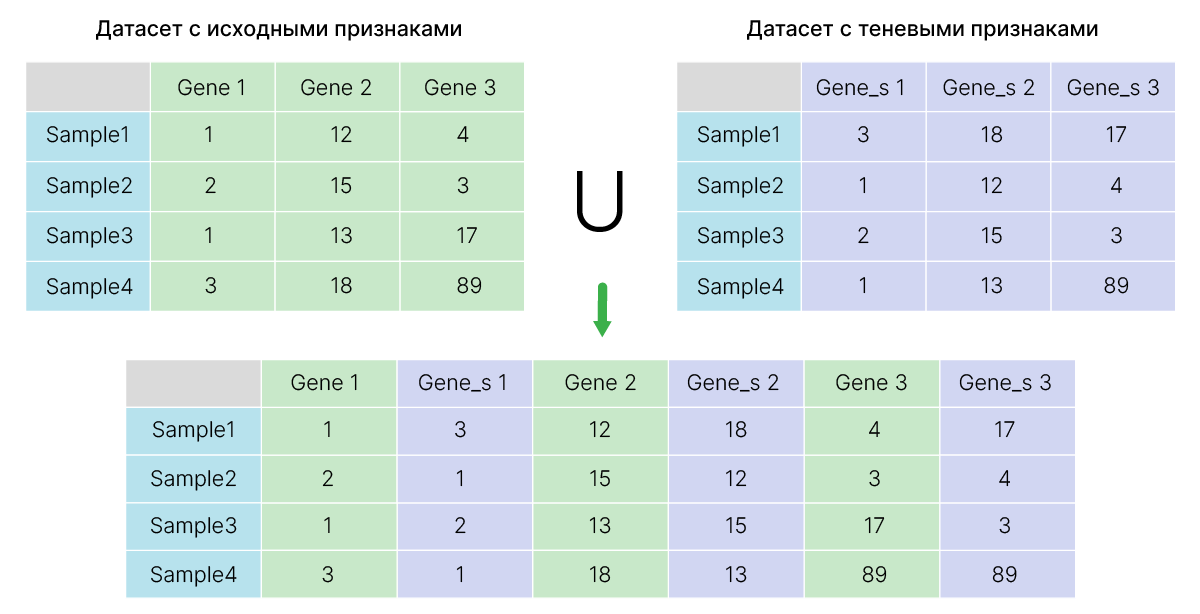

Другой подход к решению этой проблемы — создание синтетических данных.

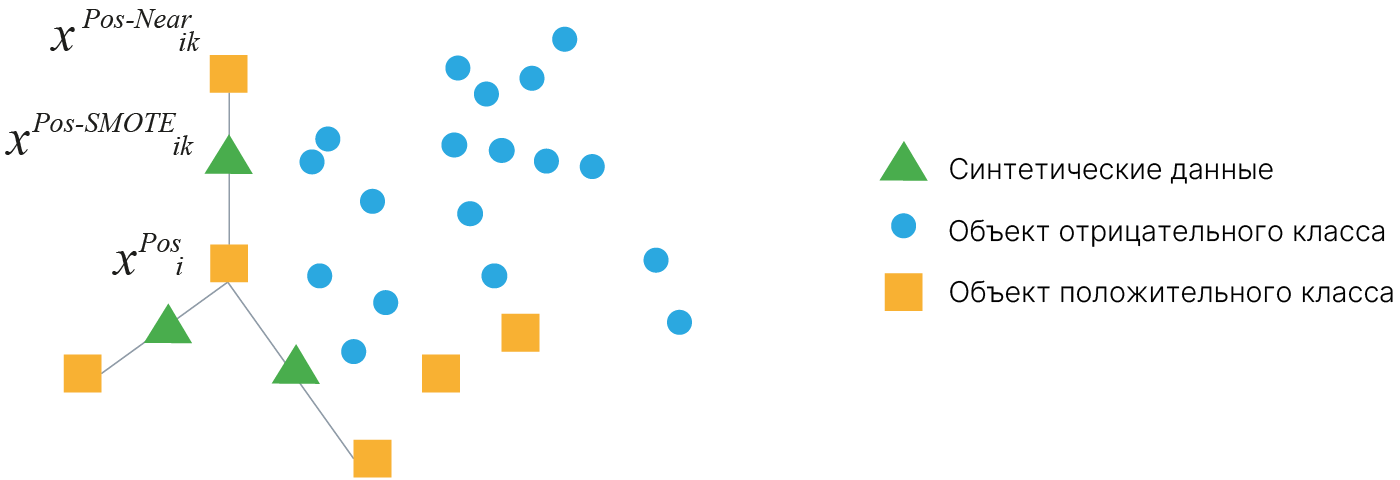

Synthetic Minority Over-sampling Technique (SMOTE) позволяет генерировать синтетические данные за счет реальных объектов из минорного класса.

Алгоритм работает следующим образом:

Число соседей, как и число раз, которое мы запускаем описанную выше процедуру, можно регулировать.

from imblearn.over_sampling import SMOTE

oversample = SMOTE()

x_smote, y_smote = oversample.fit_resample(x, y)

show_class_balance(y_smote, classes)

Количество объектов каждого класса, которое должно получиться после генерации, можно задать явно:

over = SMOTE(sampling_strategy={0: 20, 1: 70, 2: 70})

x_smote, y_smote = over.fit_resample(x, y)

show_class_balance(y_smote, classes)

[blog] ✏️ SMOTE for Imbalanced Classification with Python — подробнее про использование пакета.

Обращайте внимание на то, какие метрики вы используете. При решении задачи классификации часто используется accuracy (точность), равная доле правильно классифицированных объектов. Эта метрика позволяет адекватно оценить результат классификации в случае сбалансированных классов. В случае дисбаланса классов данная метрика может выдать обманчиво хороший результат.

Пример: датасет, в котором 95% объектов относятся к классу 0 и 5% к классу 1.

from sklearn.datasets import make_classification

from collections import Counter

import numpy as np

import matplotlib.pyplot as plt

x, y = make_classification(

n_samples=1000,

n_features=2,

n_redundant=0,

n_clusters_per_class=1,

weights=[0.95],

flip_y=0,

random_state=42,

)

counter = Counter(y)

print("Class distribution ", Counter(y))

for label, _ in counter.items():

row_ix = np.where(y == label)[0]

plt.scatter(x[row_ix, 0], x[row_ix, 1], label=str(label))

plt.legend()

plt.show()

Class distribution Counter({0: 950, 1: 50})

И модель, которая для всех данных выдает класс 0:

class DummyModel:

def predict(self, x):

return np.zeros(x.shape[0]) # always predict class 0

Такая модель будет иметь $\text{accuracy} = 0.95$, хотя не выдает никакой полезной информации:

from sklearn.metrics import accuracy_score

dummy_model = DummyModel()

y_pred = dummy_model.predict(x)

accuracy = accuracy_score(y, y_pred)

print("Accuracy", accuracy)

Accuracy 0.95

Для несбалансированных данных лучше выбирать F1 Score 🛠️[doc], MCC 🛠️[doc] (Matthews correlation coefficient, коэффициент корреляции Мэтьюса) или balanced accuracy 🛠️[doc] (среднее между recall разных классов).

from sklearn.metrics import f1_score, matthews_corrcoef, balanced_accuracy_score

print("F1", f1_score(y, y_pred))

print("MCC", matthews_corrcoef(y, y_pred))

print("Balanced accuracy", balanced_accuracy_score(y, y_pred))

F1 0.0 MCC 0.0 Balanced accuracy 0.5

Эти метрики более адекватно оценивают качество модели при наличии дисбаланса классов, и в данном случае отражают отсутствие связи предсказаний с данными на входе модели.

В случае сильно несбалансированных наборов данных стоит задуматься, могут ли такие примеры рассматриваться как аномалия (выброс) или нет. Если такое событие и впрямь может считаться аномальным, мы можем использовать такие модели, как OneClassSVM, методы кластеризации или методы обнаружения гауссовских аномалий.

Эти методы требуют изменения взгляда на задачу: мы будем рассматривать аномалии как отдельный класс выбросов. Это может помочь нам найти новые способы разделения и классификации.

Пусть мы хотим отличать фрукты по каким-то признакам, скажем, по форме и цвету, и мы имеем выборку, где много яблок и груш. Задача обнаружения аномалий возникает, если мы предполагаем, что среди яблок и груш может вдруг возникнуть клубника и нам нужно отнести ее не к одному из известных классов, а выделить в отдельный, отличающийся класс.

Проблемой при работе с аномалиями является то, что аномальных значений может быть очень мало или вообще не быть. В таком случае алгоритм учит паттерны нормального поведения и реагирует на отличия от паттернов.

Разберем примеры обнаружения аномалий с помощью трех алгоритмов из библиотеки Scikit-Learn (там можно найти еще много различных алгоритмов).

Создадим датасет из двух кластеров и случайных значений.

import numpy as np

rng = np.random.RandomState(42)

# Train

x = 0.3 * rng.randn(100, 2) # 100 2D points

x_train = np.r_[x + 2, x - 2] # split into two clusters

# Test norlmal

x = 0.3 * rng.randn(20, 2) # 20 2D points

x_test_normal = np.r_[x + 2, x - 2] # split into two clusters

# Test outliers

x_test_outliers = rng.uniform(low=-4, high=4, size=(20, 2))

Напишем функцию визуализации, которая будет изображать созданный датасет на рисунке слева, а результат поиска аномалий — на рисунке справа.

def plot_outliers(x_train, x_test_normal, x_test_outliers, model=None):

fig, (plt_data, plt_model) = plt.subplots(1, 2, figsize=(12, 6))

plt_data.set_title("Created Dataset (real labels)")

plot_train = plt_data.scatter(

x_train[:, 0], x_train[:, 1], c="white", s=40, edgecolor="k"

)

plot_test_normal = plt_data.scatter(

x_test_normal[:, 0], x_test_normal[:, 1], c="green", s=40, edgecolor="k"

)

plot_test_outliers = plt_data.scatter(

x_test_outliers[:, 0], x_test_outliers[:, 1], c="red", s=40, edgecolor="k"

)

plt_data.set_xlim((-5, 5))

plt_data.set_ylim((-5, 5))

plt_data.legend(

[plot_train, plot_test_normal, plot_test_outliers],

["train", "test normal", "test outliers"],

loc="lower right",

)

if model:

plt_model.set_title("Model Results")

# plot decision function

xx, yy = np.meshgrid(np.linspace(-5, 5, 50), np.linspace(-5, 5, 50))

Z = model.decision_function(np.c_[xx.ravel(), yy.ravel()])

Z = Z.reshape(xx.shape)

plt_model.contourf(xx, yy, Z, cmap=plt.cm.Blues_r)

# plot prediction

full_data = np.concatenate((x_train, x_test_normal, x_test_outliers), axis=0)

predicted = model.predict(full_data)

anom_index = np.where(predicted == -1)

anom_values = full_data[anom_index]

plot_all_data = plt_model.scatter(

full_data[:, 0], full_data[:, 1], c="white", s=40, edgecolor="k"

)

plot_anom_data = plt_model.scatter(

anom_values[:, 0], anom_values[:, 1], c="red", s=40, marker="x"

)

plt_model.legend(

[plot_all_data, plot_anom_data],

["normal", "outliers"],

loc="lower right",

)

plt.show()

Посмотрим, как работает на этих данных алгоритм OneClassSVM 🛠️[doc].

Идея алгоритма состоит в поиске функции, которая положительна для областей с высокой плотностью и отрицательна для областей с малой плотностью.

Подробнее об алгоритме:

from sklearn.svm import OneClassSVM

gamma = 2.0 # Kernel coefficient

contamination = 0.05 # threshold

model = OneClassSVM(gamma=gamma, kernel="rbf", nu=contamination)

model.fit(x_train)

plot_outliers(x_train, x_test_normal, x_test_outliers, model)

Посмотрим, как на этих же данных работает алгоритм Isolation Forest 🛠️[doc].

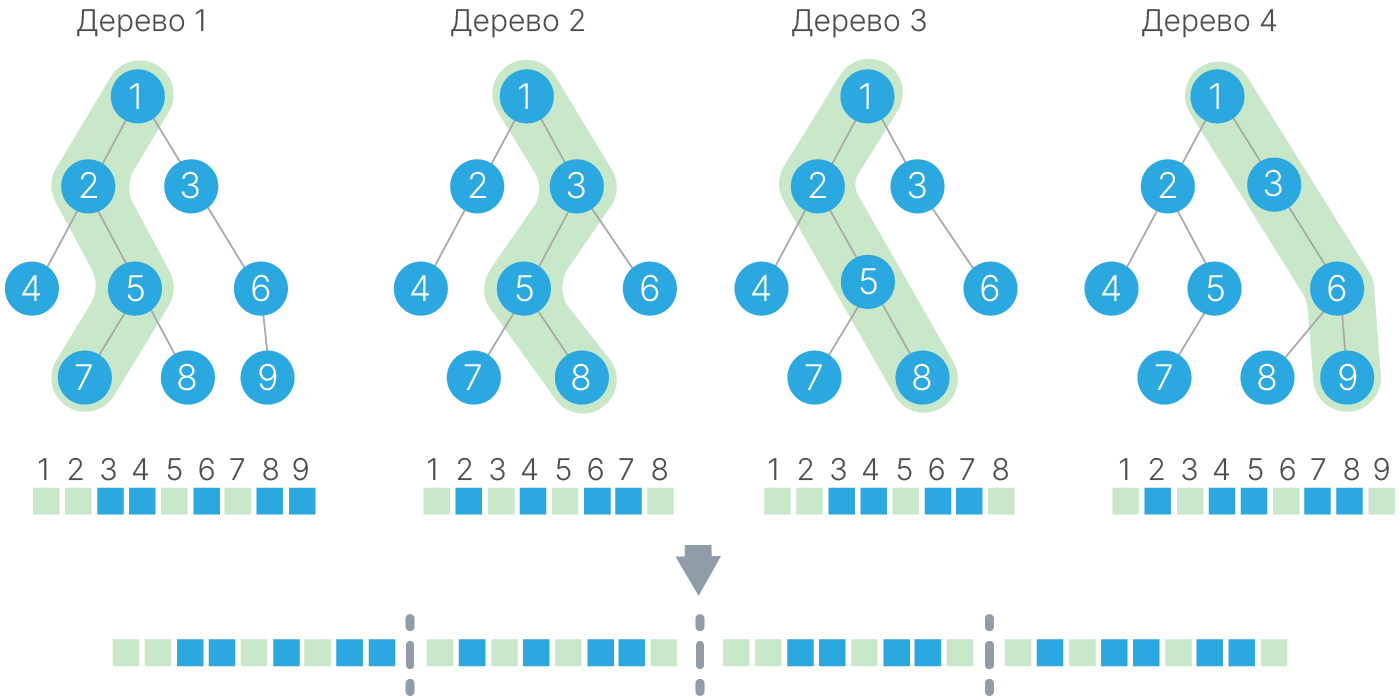

Isolation Forest состоит из деревьев, которые «изолируют» (пытаются отделить от остальной выборки) наблюдения, случайным образом выбирая признак и случайное значение порога для этого признака (между max и min значениями признака). Такой алгоритм чаще и проще отделяет значения аномалий. Если построить по такому принципу множество деревьев, то значения, которые чаще других отделяются раньше, будут аномалиями.

На практике часто используют более продвинутую версию Extended Isolation Forest 🐾[git].

from sklearn.ensemble import IsolationForest

n_estimators = 200

contamination = 0.05 # threshold

model = IsolationForest(

n_estimators=n_estimators, contamination=contamination, random_state=rng

)

model.fit(x_train)

plot_outliers(x_train, x_test_normal, x_test_outliers, model)

Последним алгоритмом, на который мы посмотрим, будет Local Outlier Factor 🛠️[doc].

В нем используется метод k-NN. Расстояние до ближайших соседей используется для оценки расположения точек. Если соседи далеко, то точка с большой вероятностью является аномалией.

from sklearn.neighbors import LocalOutlierFactor

n_neighbors = 10

contamination = 0.05 # threshold

model = LocalOutlierFactor(

n_neighbors=n_neighbors, novelty=True, contamination=contamination

)

model.fit(x_train)

plot_outliers(x_train, x_test_normal, x_test_outliers, model)

Отдельное время стоит посвятить подбору порога для алгоритма.

Порог является граничным значением, выше которого данные считаются аномальными. Выбор порога — это компромиссное решение: слишком низкий порог может привести к ложным срабатываниям, тогда как слишком высокий порог может пропустить аномалии. Поэтому выбор порога напрямую связан с задачей и требованиям к детекции.

Построим матрицы ошибок (Confusion matrix) для разных порогов:

full_data = np.concatenate((x_train, x_test_normal, x_test_outliers), axis=0)

predicted = model.predict(full_data)

# change threshold to 0.005

model_2 = LocalOutlierFactor(n_neighbors=10, novelty=True, contamination=0.005)

model_2.fit(x_train)

predicted_2 = model_2.predict(full_data)

y_true = np.ones(full_data.shape[0]) # create true labels

y_true[-x_test_outliers.shape[0] :] = -1 # last 20 is anomaly

from sklearn.metrics import ConfusionMatrixDisplay

fig = plt.figure(figsize=(10, 6))

ax1 = fig.add_subplot(121)

ax2 = fig.add_subplot(122)

ConfusionMatrixDisplay.from_predictions(y_true, predicted, ax=ax1, colorbar=False)

ConfusionMatrixDisplay.from_predictions(y_true, predicted_2, ax=ax2, colorbar=False)

ax1.set_title("threshold = 0.05")

ax2.set_title("threshold = 0.005")

plt.subplots_adjust(wspace=0.3)

plt.show()

Еще одна идея улучшения качества детекции аномалий — это агрегация результатов разных алгоритмов, т. е. создание ансамбля.

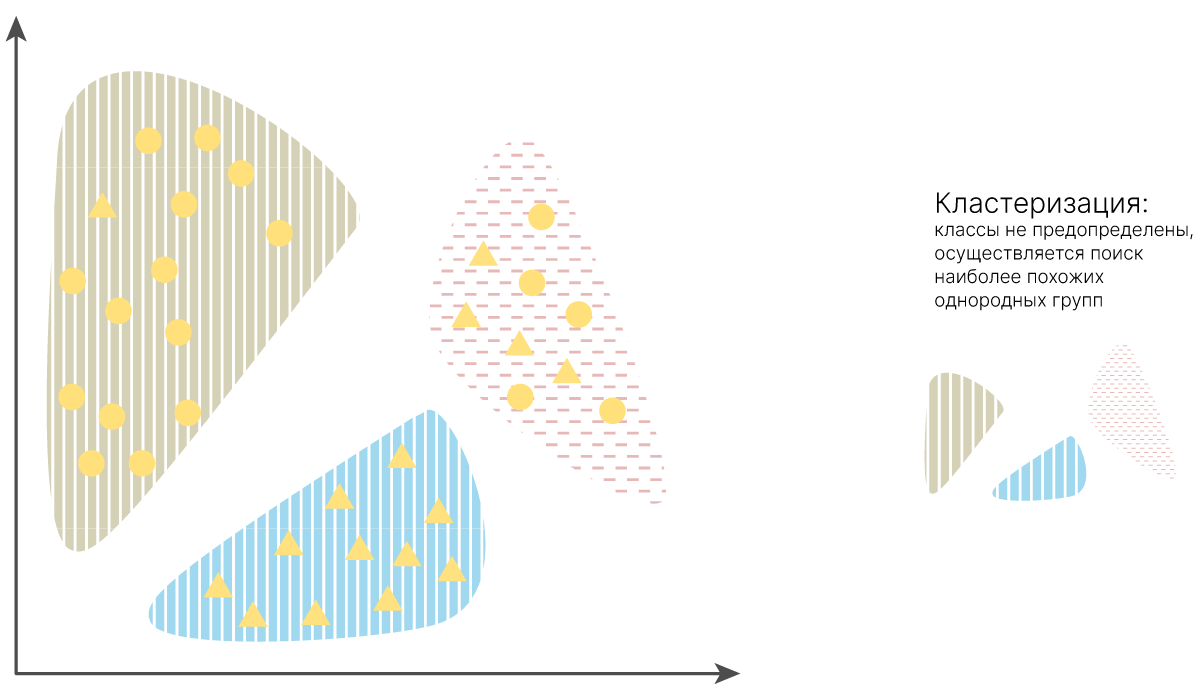

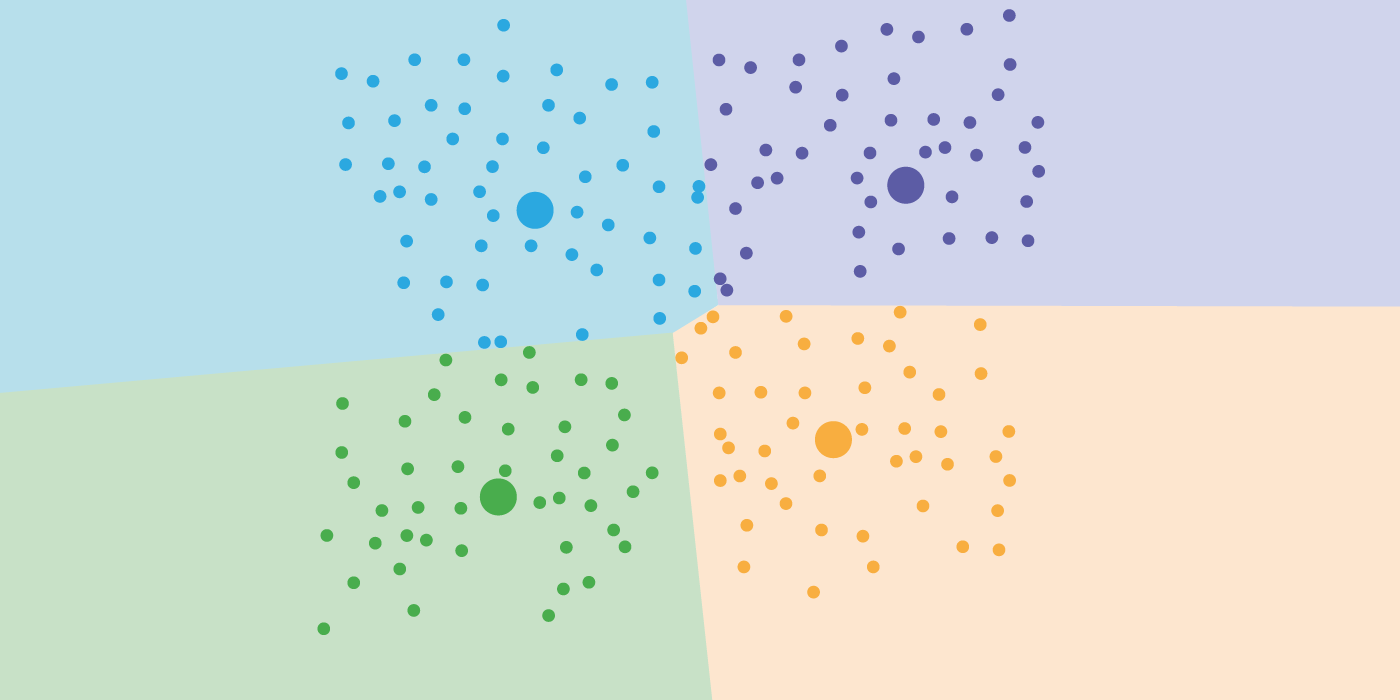

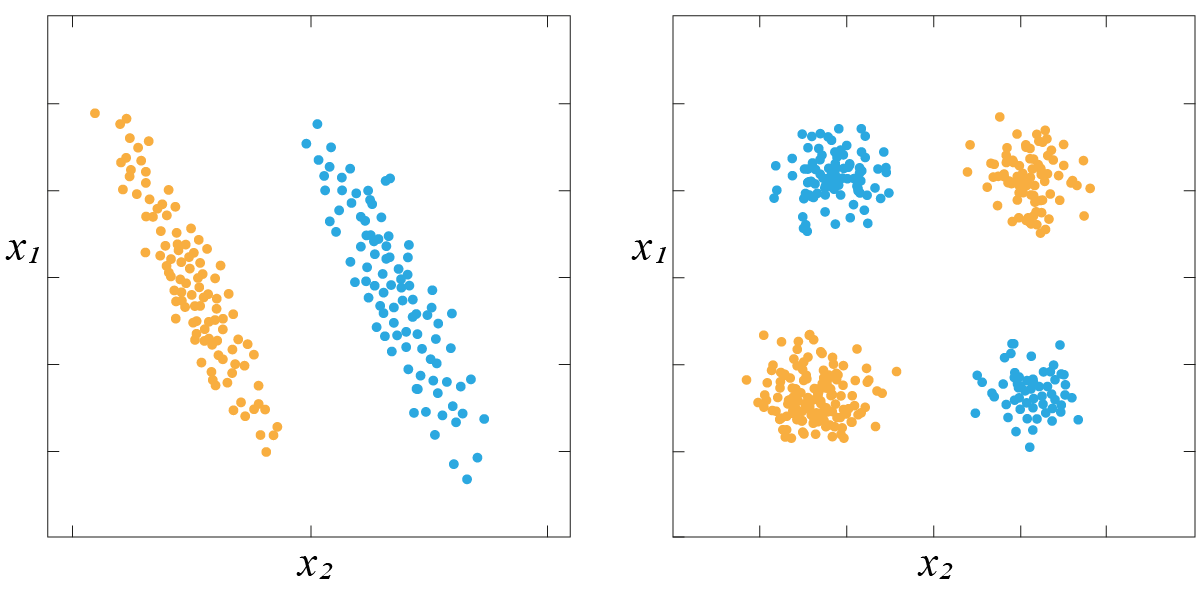

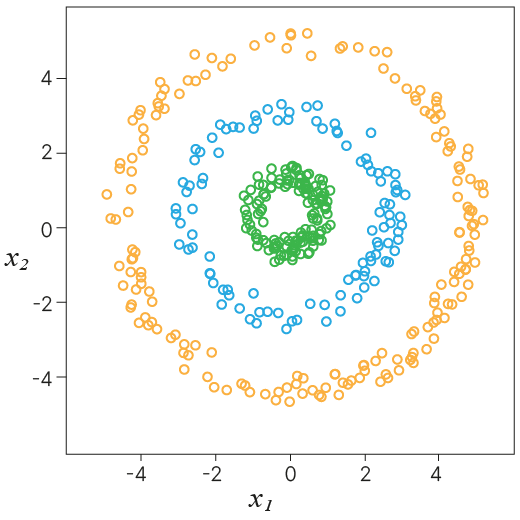

Когда говорят про задачу кластеризации, подразумевают примерно следующее:

У нас есть неразмеченные данные, и мы хотим поделить эти данные по каким-то группам, где в каждой группе будут объекты, похожие друг на друга. Под похожестью как правило понимается выбранная метрика расстояния.

Основные цели кластеризации:

Исследование данных. Мы хотим понять, какие кластеры являются ярко выраженными, и сделать дополнительные выводы о наших данных.

Нахождение аномалий/выбросов. Мы можем искать объекты, которые сильно отличаются от всех остальных и не принадлежат никакому кластеру.

Создание дополнительных признаков. Кластер для объекта уже является дополнительным категориальным признаком.

Непосредственно классификация. Например, можем считать получившиеся кластеры классами и классифицировать объекты таким образом.

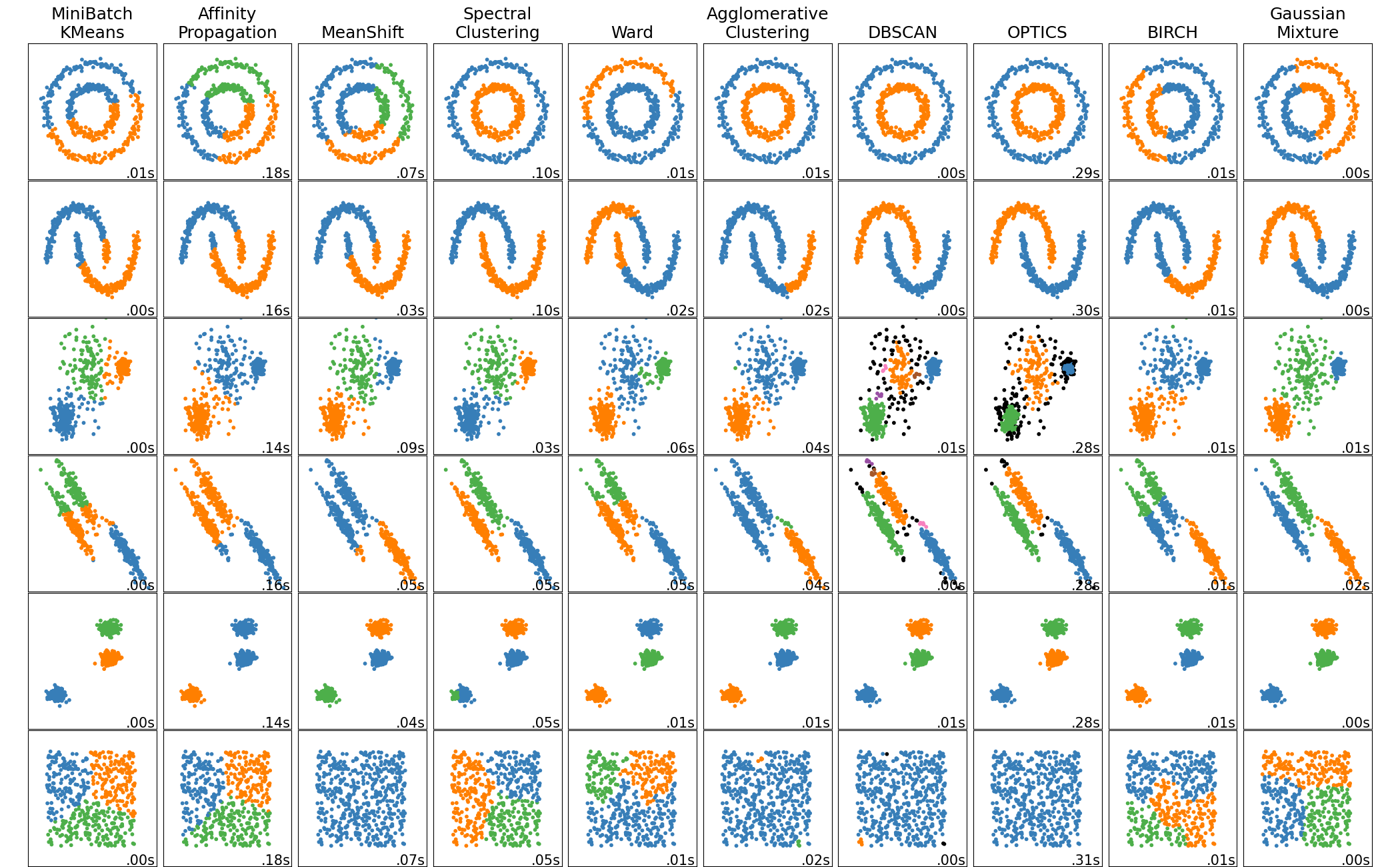

Алгоритмов кластеризации существует большое количество, и все работают по-разному, имеют разные параметры для настройки. Мы рассмотрим два наиболее популярных: K-Means 🛠️[doc] и DBSCAN 🛠️[doc].

Особенности K-Means:

import matplotlib.pyplot as plt

import seaborn as sns

from sklearn.cluster import KMeans

from sklearn.datasets import make_blobs, make_moons

x_blobs, _ = make_blobs(n_samples=600, n_features=2, centers=3, random_state=42)

x_moons, _ = make_moons(n_samples=600, noise=0.05, random_state=42)

def plot_kmeans_clustering(ax, data, n_clusters, title):

kmeans = KMeans(n_clusters=n_clusters, n_init=10)

kmeans.fit(data)

kmeans_labels = kmeans.predict(data)

sns.scatterplot(

x=data[:, 0], y=data[:, 1], hue=kmeans_labels, palette="Set2", ax=ax

)

ax.scatter(

kmeans.cluster_centers_[:, 0],

kmeans.cluster_centers_[:, 1],

s=100,

c="red",

marker="o",

)

ax.set_title(title)

ax.set_xlabel("Feature 1")

ax.set_ylabel("Feature 2")

fig, axes = plt.subplots(1, 2, figsize=(12, 6))

plot_kmeans_clustering(

axes[0], x_blobs, n_clusters=3, title="KMeans Clustering - Blobs"

)

plot_kmeans_clustering(

axes[1], x_moons, n_clusters=2, title="KMeans Clustering - Moons"

)

plt.tight_layout()

plt.show()

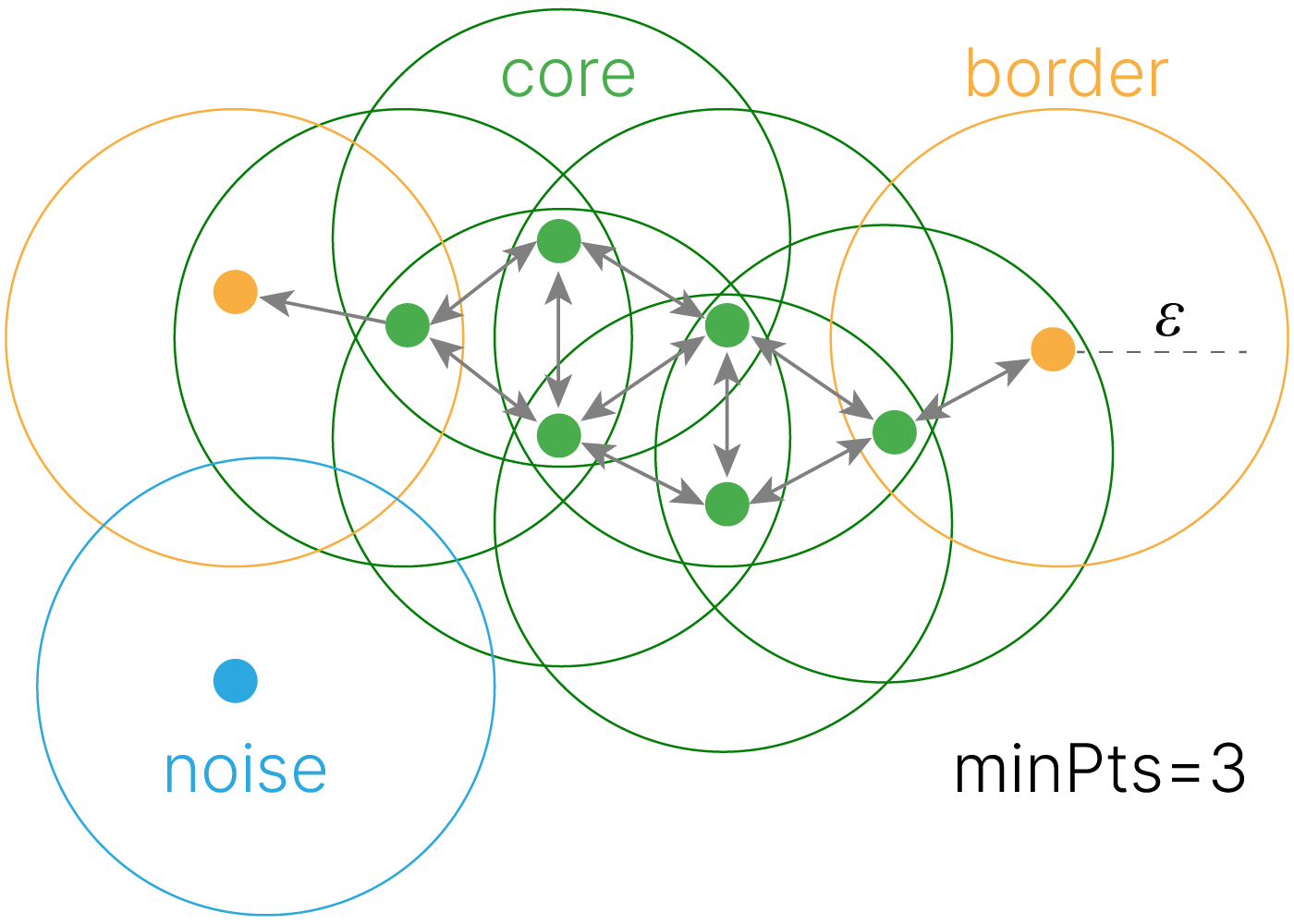

DBSCAN (Density-based spatial clustering of applications with noise, плотностный алгоритм пространственной кластеризации с присутствием шума), как следует из названия, оперирует плотностью данных. На вход требуется матрица близости и два параметра:

eps — радиус $\varepsilon$-окрестности, в которой мы ищем похожие объекты (радиус кружков на картинке).min_samples — количество соседей, которое должен иметь объект, чтобы не быть одиночкой. У нас min_samples=3.Алгоритм выглядит следующим образом:

Иначе:

from sklearn.cluster import DBSCAN

def plot_dbscan_clustering(ax, data, eps, min_samples, title):

dbscan = DBSCAN(eps=eps, min_samples=min_samples)

dbscan_labels = dbscan.fit_predict(data)

sns.scatterplot(

x=data[:, 0], y=data[:, 1], hue=dbscan_labels, palette="Set2", ax=ax

)

ax.set_title(title)

ax.set_xlabel("Feature 1")

ax.set_ylabel("Feature 2")

fig, axes = plt.subplots(1, 2, figsize=(12, 6))

plot_dbscan_clustering(

axes[0], x_blobs, eps=0.5, min_samples=5, title="DBSCAN Clustering - Blobs"

)

plot_dbscan_clustering(

axes[1], x_moons, eps=0.15, min_samples=5, title="DBSCAN Clustering - Moons"

)

plt.tight_layout()

plt.show()

Кодирование признаков — процесс описания данных в численном представлении.

Изначально объекты в нашем датасете могут быть представлены в виде описаний, которые не являются численными или требуют некоторой предобработки. Например:

Большая часть моделей не способна работать с такими представлениями в сыром виде и просто не запустится или будет выдавать неадекватные результаты.

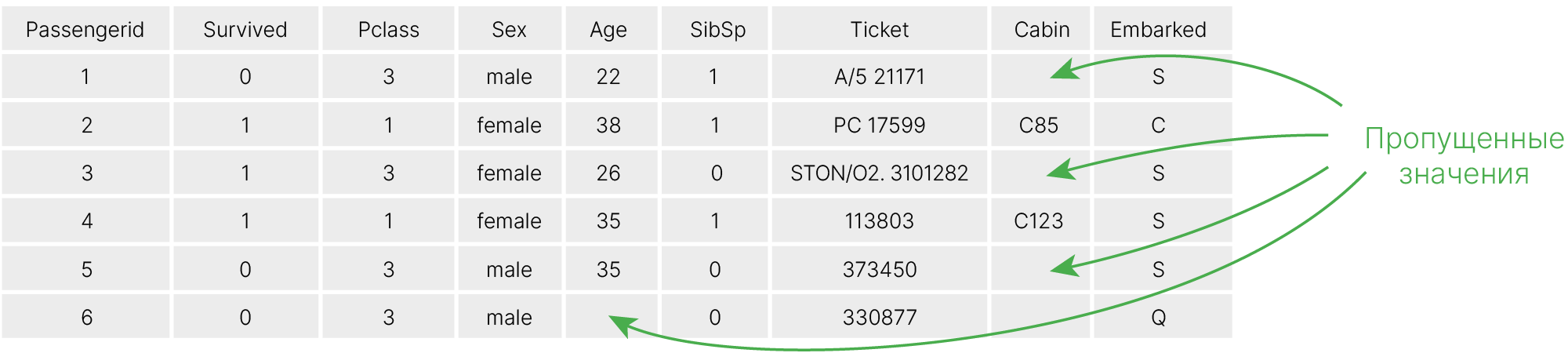

Пример на Titanic

Для иллюстрации будут использованы примеры из книги "Real-World Machine Learning 📚[book]" из открытого репозитория 🐾[git] и датасет Titanic 🛠️[doc].

Данный датасет представляет собой список пассажиров судна. В отличие от датасетов, с которыми мы работали раньше, данные в нем не предобработаны и в сыром виде не могут быть использованы для обучения модели.

import pandas as pd

# Download the data and save it in a variable called data

dataset = pd.read_csv(

"https://edunet.kea.su/repo/EduNet-web_dependencies/datasets/titanic.csv"

) # Load the data using pandas

dataset[:5] # Show the first 5 lines

| PassengerId | Survived | Pclass | Name | Sex | Age | SibSp | Parch | Ticket | Fare | Cabin | Embarked | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 1 | 0 | 3 | Braund, Mr. Owen Harris | male | 22.0 | 1 | 0 | A/5 21171 | 7.2500 | NaN | S |

| 1 | 2 | 1 | 1 | Cumings, Mrs. John Bradley (Florence Briggs Th... | female | 38.0 | 1 | 0 | PC 17599 | 71.2833 | C85 | C |

| 2 | 3 | 1 | 3 | Heikkinen, Miss. Laina | female | 26.0 | 0 | 0 | STON/O2. 3101282 | 7.9250 | NaN | S |

| 3 | 4 | 1 | 1 | Futrelle, Mrs. Jacques Heath (Lily May Peel) | female | 35.0 | 1 | 0 | 113803 | 53.1000 | C123 | S |

| 4 | 5 | 0 | 3 | Allen, Mr. William Henry | male | 35.0 | 0 | 0 | 373450 | 8.0500 | NaN | S |

Если мы попытаемся обучить модель на таких данных, то у нас ничего не выйдет.

from sklearn.ensemble import RandomForestClassifier

x = dataset.drop("Survived", axis=1) # drop target

y = dataset["Survived"] # target

rf = RandomForestClassifier(random_state=42)

try:

rf.fit(x, y)

except ValueError as e:

print(e)

could not convert string to float: 'Braund, Mr. Owen Harris'

Посмотрим на информацию о признаках:

dataset.info()

<class 'pandas.core.frame.DataFrame'> RangeIndex: 891 entries, 0 to 890 Data columns (total 12 columns): # Column Non-Null Count Dtype --- ------ -------------- ----- 0 PassengerId 891 non-null int64 1 Survived 891 non-null int64 2 Pclass 891 non-null int64 3 Name 891 non-null object 4 Sex 891 non-null object 5 Age 714 non-null float64 6 SibSp 891 non-null int64 7 Parch 891 non-null int64 8 Ticket 891 non-null object 9 Fare 891 non-null float64 10 Cabin 204 non-null object 11 Embarked 889 non-null object dtypes: float64(2), int64(5), object(5) memory usage: 83.7+ KB

Традиционно признаки делятся на вещественные и категориальные.

Вещественные признаки бывают:

В датасете Титаник таким параметром будет SibSp — количество братьев/сестер/супругов на борту.

print(dataset["SibSp"].unique())

[1 0 3 4 2 5 8]

Или Parch — количество родителей/детей на борту.

print(dataset["Parch"].unique())

[0 1 2 5 3 4 6]

Разделение условное. Тот же возраст можно посчитать и дискретной переменной (пользователь всегда нам сообщает свои полные года), и непрерывной (возраст можно считать с любой точностью)

Иногда вещественные признаки делят на относительные (считаются относительно чего-то, уже нормированные и т.д.) и интервальные.

dataset[["Age", "Fare"]].head()

| Age | Fare | |

|---|---|---|

| 0 | 22.0 | 7.2500 |

| 1 | 38.0 | 71.2833 |

| 2 | 26.0 | 7.9250 |

| 3 | 35.0 | 53.1000 |

| 4 | 35.0 | 8.0500 |

Попробуем обучить модель на вещественных признаках. PassengerId удалим, т.к. этот признак может приводить к утечке в данных.

from sklearn.model_selection import train_test_split

x = dataset.drop(columns=["Survived", "PassengerId"]) # drop target and id

y = dataset["Survived"] # target

x_train, x_test, y_train, y_test = train_test_split(

x, y, test_size=0.2, random_state=42

)

# drop categorical

x_train_working = x_train.drop(

columns=["Pclass", "Name", "Sex", "Ticket", "Cabin", "Embarked"]

)

x_test_working = x_test.drop(

columns=["Pclass", "Name", "Sex", "Ticket", "Cabin", "Embarked"]

)

rf = RandomForestClassifier(random_state=42)

try:

rf.fit(x_train_working, y_train)

except ValueError as e:

print(e)

x_train_working.head()

Input X contains NaN. RandomForestClassifier does not accept missing values encoded as NaN natively. For supervised learning, you might want to consider sklearn.ensemble.HistGradientBoostingClassifier and Regressor which accept missing values encoded as NaNs natively. Alternatively, it is possible to preprocess the data, for instance by using an imputer transformer in a pipeline or drop samples with missing values. See https://scikit-learn.org/stable/modules/impute.html You can find a list of all estimators that handle NaN values at the following page: https://scikit-learn.org/stable/modules/impute.html#estimators-that-handle-nan-values

| Age | SibSp | Parch | Fare | |

|---|---|---|---|---|

| 331 | 45.5 | 0 | 0 | 28.5000 |

| 733 | 23.0 | 0 | 0 | 13.0000 |

| 382 | 32.0 | 0 | 0 | 7.9250 |

| 704 | 26.0 | 1 | 0 | 7.8542 |

| 813 | 6.0 | 4 | 2 | 31.2750 |

Проблема в том, что Age указан только для 714 пассажиров из 891. Его мы пока тоже удалим.

from sklearn.metrics import accuracy_score

x_train_working = x_train_working.drop(columns=["Age"])

x_test_working = x_test_working.drop(columns=["Age"])

rf = RandomForestClassifier(random_state=42)

rf.fit(x_train_working, y_train)

y_pred = rf.predict(x_test_working)

print(accuracy_score(y_test, y_pred))

0.6759776536312849

Точность предсказания 67.6%. Для улучшения качества попробуем добавить другие признаки.

Значение — принадлежность к какой-то из категорий. Традиционно делятся на сильно отличающиеся по свойствам:

В датасете Титаник таким признаком будет класс. Мы можем сказать, что первый класс лучше третьего, но не можем сказать, что сумма первого и второго даст третий.

print(dataset["Pclass"].unique())

[3 1 2]

Важно понимать, что могут быть ситуации, когда один и тот же признак может быть упорядоченным или неупорядоченным, в зависимости от задачи и наших знаний о ней. Например, цвет в спектре определяется длиной волны, и в физической задаче цвета можно упорядочить.

В датасете Титаник таким признаком является Embarked (порт посадки).

print(dataset["Embarked"].unique())

# C = Cherbourg; Q = Queenstown; S = Southampton

['S' 'C' 'Q' nan]

Часто мы сталкиваемся с бинарными категориальными признаками, для которых известны только две возможные категории (например, биологический пол человека).

print(dataset["Sex"].unique())

['male' 'female']

Существует много подходов к кодированию признакового пространства. Каждый подход имеет свои особенности. Способ кодирования зависит от используемой модели.

В Label encoding каждой категории признака однозначно сопоставляется число. Данный подход хорошо работает для упорядоченных (ординальных) признаков.

Если признак неупорядоченный (номинальный), то могут возникнуть проблемы. Например, если мы обозначим: $$Уж = 1$$ $$Ёж = 2$$ $$Белка = 3$$ То в некоторых моделях (линейных), может возникнуть ложная зависимость:

$$Уж+Ёж = Белка$$что не является свойством данных.

Кроме того, мы не можем сказать, что уж “больше” ежа и сравнить его с белкой, но обучаемая модель про это не знает и будет пытаться их сравнить. Это может привести к низкому качеству модели и выучиванию неправильной информации.

Например, дерево решений для выделения одной категории должно будет проделать несколько сравнений.

Некоторые модели (например, LightGBM 🛠️[doc]) могут автоматически подбирать кодировку для категориальных признаков, если предоставить им информацию о том, что признак категориальный, для других моделей это нужно делать вручную.

У нас есть упорядоченный категориальный признак — класс, которым ехал пассажир. Добавим его к данным.

x_train_working["Pclass"] = x_train["Pclass"]

x_test_working["Pclass"] = x_test["Pclass"]

x_train_working[:5]

| SibSp | Parch | Fare | Pclass | |

|---|---|---|---|---|

| 331 | 0 | 0 | 28.5000 | 1 |

| 733 | 0 | 0 | 13.0000 | 2 |

| 382 | 0 | 0 | 7.9250 | 3 |

| 704 | 1 | 0 | 7.8542 | 3 |

| 813 | 4 | 2 | 31.2750 | 3 |

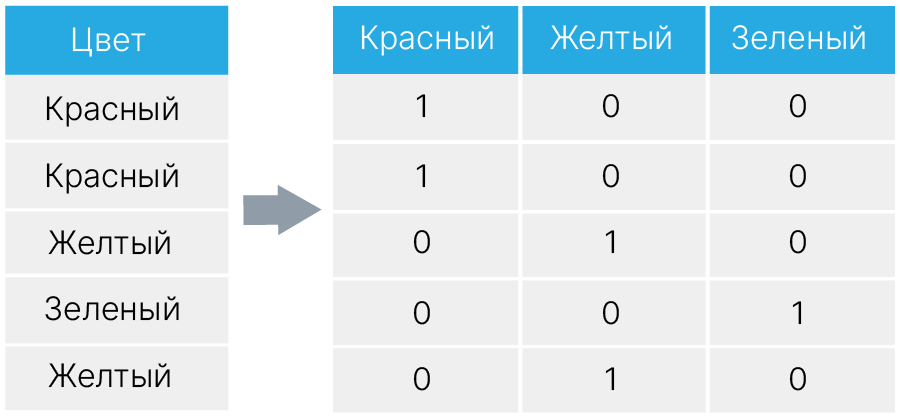

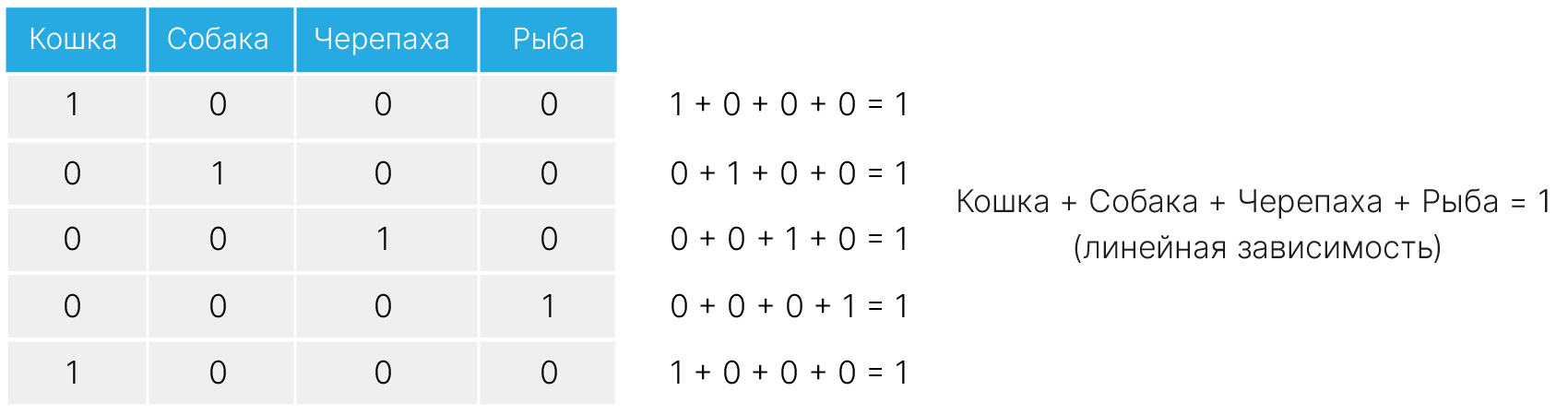

На практике часто используется one-hot encoding. Вместо одного категориального признака $X$ создается набор бинарных категориальных признаков, которые отвечают на вопрос $X == C$, где $C$ перебирает все возможные значения категориального признака.

Теперь, чтобы выбрать конкретное значение категориального признака, дереву решений достаточно задать один вопрос.

У такой схемы есть ряд недостатков:

Подробнее:

[blog] ✏️ Think twice before dropping that first one-hot encoded column.

Поэтому одну из категорий могут исключить при кодировании. Например, в примере выше можно исключить Рыбу, ведь если все три других признака-категории равны 0, то точно верно, что категория — Рыба.

У нас есть два признака с ограниченным количеством значений: Sex и Embarked.

Пол закодируем male = 1 female = 0.

x_train_working["Sex"] = x_train["Sex"].map({"male": 1, "female": 0})

x_test_working["Sex"] = x_test["Sex"].map({"male": 1, "female": 0})

x_train_working[:5]

| SibSp | Parch | Fare | Pclass | Sex | |

|---|---|---|---|---|---|

| 331 | 0 | 0 | 28.5000 | 1 | 1 |

| 733 | 0 | 0 | 13.0000 | 2 | 1 |

| 382 | 0 | 0 | 7.9250 | 3 | 1 |

| 704 | 1 | 0 | 7.8542 | 3 | 1 |

| 813 | 4 | 2 | 31.2750 | 3 | 0 |

Еще один способ, который показал свою эффективность — это кодирование категориальной переменной по количеству встречаемости в данных.

| category | new_feature |

|---|---|

| food | 3 |

| equipment | 2 |

| food | 3 |

| food | 3 |

| equipment | 2 |

| clothes | 1 |

Его просто и быстро реализовать. Здесь также присутствует логика порядка, который возникает естественным образом. Чем больше число, тем чаще встречается категория. Также здесь отсутствует ложная линейная зависимость: в нашем случае equipment + clothes = food, и для нас это действительно так, потому что наше кодирование отражает связь между категориями через их частоту.

Дополнительно стоит добавить шум к данным, чтобы избежать ситуации, когда разные категории кодируются одинаковым числом.

| category | new_feature |

|---|---|

| food | 2.3 |

| equipment | 2.04 |

| food | 2.3 |

| clothes | 2.6 |

| equipment | 2.04 |

| clothes | 2.6 |

Можем кодировать категориальный признак по какой-то статистике вещественного. Например, при прогнозировании покупок в интернет магазине может оказаться разумным кодировать категории товаров их средней ценой.

| category | product | price | new_feature |

|---|---|---|---|

| food | pizza | 30 | 17 |

| equipment | hammer | 140 | 170 |

| food | cucumber | 4 | 17 |

| clothes | boots | 100 | 60 |

| equipment | helmet | 200 | 170 |

| clothes | gloves | 20 | 60 |

В Target encoding каждая категория кодируется численным параметром, характеризующим то, что мы предсказываем. Например, можно каждую категорию категориального признака заменять на среднее целевого значения (mean target).

При этом может возникнуть проблема переобучения: для редких классов модель может научиться копировать значение mean target категориального признака в ответ, игнорируя другие признаки.

Как с этим бороться:

[git] 🐾 Курс "Прикладные задачи анализа данных", Генерация признаков.

Так как у нас в качестве модели используется случайный лес, для Embarked будем использовать Label encoding. Мы не будем считать среднее. Используем Target, чтобы упорядочить метки. Посмотрим, какой процент выживших для каждого порта. Смотреть будем только на train выборке. Информация из test выборки не должна попасть в модель!

import seaborn as sns

from matplotlib import pyplot as plt

plt.figure(figsize=(8, 4))

train_df = x_train.copy()

train_df["Survived"] = y_train

sns.barplot(x="Embarked", y="Survived", data=train_df)

plt.show()

Получили количество выживших $S<Q<C$. Упорядочим метки соответственно.

import numpy as np

emb = {np.nan: 0, "S": 0, "Q": 1, "C": 2}

x_train_working["Embarked"] = x_train["Embarked"].map(emb)

x_test_working["Embarked"] = x_test["Embarked"].map(emb)

x_train_working[5:10]

| SibSp | Parch | Fare | Pclass | Sex | Embarked | |

|---|---|---|---|---|---|---|

| 118 | 0 | 1 | 247.5208 | 1 | 1 | 2 |

| 536 | 0 | 0 | 26.5500 | 1 | 1 | 0 |

| 361 | 1 | 0 | 27.7208 | 2 | 1 | 2 |

| 29 | 0 | 0 | 7.8958 | 3 | 1 | 0 |

| 55 | 0 | 0 | 35.5000 | 1 | 1 | 0 |

У нас осталось еще 4 признака, с которыми непонятно, что делать: Name, Ticket, Cabin, Age.

Рассмотрим поле Name. Это поле может нести информацию о поле, социальном статусе, происхождении, национальности, возрасте и т.д. Можно построить модели, которые будут это оценивать и отражать. Мы будем работать с числовыми представлениями текста в нашем курсе. Но пока мы можем использовать метод "пристального вглядывания" в данные.

x_train.Name[:5]

331 Partner, Mr. Austen 733 Berriman, Mr. William John 382 Tikkanen, Mr. Juho 704 Hansen, Mr. Henrik Juul 813 Andersson, Miss. Ebba Iris Alfrida Name: Name, dtype: object

В именах есть информация о социальном статусе:

и т.д.

Первые 4 встречаются чаще.

Извлечем все возможные титулы, они начинаются с пробела и заканчиваются точкой.

titles = dataset.Name.str.extract(" ([A-Za-z]+)\.", expand=False).unique()

print(titles)

['Mr' 'Mrs' 'Miss' 'Master' 'Don' 'Rev' 'Dr' 'Mme' 'Ms' 'Major' 'Lady' 'Sir' 'Mlle' 'Col' 'Capt' 'Countess' 'Jonkheer']

Сгруппируем некоторые с похожими значениями. Редкие запишем в нулевой класс.

title_mapping = {"Mr": 4, "Miss": 3, "Mrs": 2, "Master": 1}

# get title from name and encode by title_mapping, another titles fill zero

x_train_working["Title"] = (

x_train.Name.str.extract(" ([A-Za-z]+)\.", expand=False)

.map(title_mapping)

.fillna(0)

)

x_test_working["Title"] = (

x_test.Name.str.extract(" ([A-Za-z]+)\.", expand=False).map(title_mapping).fillna(0)

)

x_train_working[:5]

| SibSp | Parch | Fare | Pclass | Sex | Embarked | Title | |

|---|---|---|---|---|---|---|---|

| 331 | 0 | 0 | 28.5000 | 1 | 1 | 0 | 4.0 |

| 733 | 0 | 0 | 13.0000 | 2 | 1 | 0 | 4.0 |

| 382 | 0 | 0 | 7.9250 | 3 | 1 | 0 | 4.0 |

| 704 | 1 | 0 | 7.8542 | 3 | 1 | 0 | 4.0 |

| 813 | 4 | 2 | 31.2750 | 3 | 0 | 0 | 3.0 |

При работе с датой и временем мы можем представить дату и время в виде числа. Один из способов такого представления Unix Timestamp 🛠️[doc] (количество секунд, прошедших с 1 января 1970-го года). Для ряда задач важна цикличность времени. Например, загруженность линии метро будет зависеть от времени дня (цикл 24 часа), дня недели (цикл 7 дней) и нерабочих праздничных дней (цикл год). Для прогнозирования количества электроэнергии, выработанной солнечной батареей, важно будет время дня (цикл 24 часа) и время года (цикл год).

В случае с такими признаками, как день недели или время суток, мы сталкиваемся с проблемой того, что нам нужно предложить кодирование, которое будет учитывать, что понедельник близок к воскресенью так же, как и ко вторнику, и т.д.

Давайте нанесем наши категории, например, дни недели, на окружность. Как это сделать? Пусть понедельнику соответствует 1, а воскресенью — 7. Далее посчитаем два таких вспомогательных признака по следующим формулам

weekdays = np.arange(1, 8) # create an array of weekdays

print(weekdays)

sina = np.sin(weekdays * np.pi * 2 / np.max(weekdays)) # feature 1

cosa = np.cos(weekdays * np.pi * 2 / np.max(weekdays)) # feature 2

[1 2 3 4 5 6 7]

plt.figure(figsize=(6, 6)) # Decide figure size

plt.scatter(sina, cosa) # Plot scatter of feature 1 vs feature 2

for i, z in enumerate(

("Mon", "Tue", "Wed", "Thu", "Fri", "Sat", "Sun")

): # for each day in a week

plt.text(sina[i], cosa[i], s=z) # add text labels to plot

Теперь расстояния между понедельником и вторником и воскресеньем и понедельником одинаковые:

dist_mon_tue = (sina[1] - sina[0]) ** 2 + (

cosa[1] - cosa[0]

) ** 2 # distance between Monday and Tuesday

dist_sun_mon = (sina[6] - sina[0]) ** 2 + (

cosa[6] - cosa[0]

) ** 2 # distance between Sunday and Monday

print("Distance between Mon-Tue = %.2f" % dist_mon_tue)

print("Distance between Sun-Mon = %.2f" % dist_sun_mon)

Distance between Mon-Tue = 0.75 Distance between Sun-Mon = 0.75

То же самое верно и для любых отстоящих друг от друга на одинаковое число дней

dist_mon_wed = (sina[2] - sina[0]) ** 2 + (

cosa[2] - cosa[0]

) ** 2 # distance between Monday and Wednesday

dist_fri_sun = (sina[4] - sina[6]) ** 2 + (

cosa[4] - cosa[6]

) ** 2 # distance between Friday and Sunday

print("Distance between Mon-Wed = %.2f" % dist_mon_wed)

print("Distance between Fri-Sun = %.2f" % dist_fri_sun)

Distance between Mon-Wed = 2.45 Distance between Fri-Sun = 2.45

Таким образом, циклические признаки можно кодировать парой признаков (sin и cos), полученных по схеме, описанной выше.

Проблемы подхода:

Такое кодирование может создать сложности для деревьев решений, т.к. они работают с одним признаком за раз.

Надо понимать, что важность исходной категориальной фичи неочевидным образом делится между двумя полученными из нее таким образом фичами.

В некоторых задачах one-hot работает лучше.

Для ряда задач может быть неважно конкретное значение признака. Важнее может оказаться факт превышения порога или наличия значения.

Например, уровень сахара крови выше $11.1$ ммоль/л может говорить о наличии у пациента сахарного диабета, что повлияет на результат лечения. А наличие высшего образования больше влияет на платежеспособность, чем средний балл диплома.

Для таких признаков можно попробовать использовать бинаризацию: превращение вещественного признака в бинарный по принципу “есть ли значение” или “больше ли значение определенного порога”.

Бинаризируем уровень сахара в крови.

from sklearn.preprocessing import Binarizer

# fmt: off

x = np.array([[1, 12],

[2, 7.6],

[3, 8.4],

[4, 13.5],

[5, 6.3]])

# fmt: on

transformer = Binarizer(threshold=11.1)

binarized = transformer.transform(np.expand_dims(x[:, 1], axis=1))

x_binarized = np.concatenate((x, binarized), axis=1)

print(x_binarized)

[[ 1. 12. 1. ] [ 2. 7.6 0. ] [ 3. 8.4 0. ] [ 4. 13.5 1. ] [ 5. 6.3 0. ]]

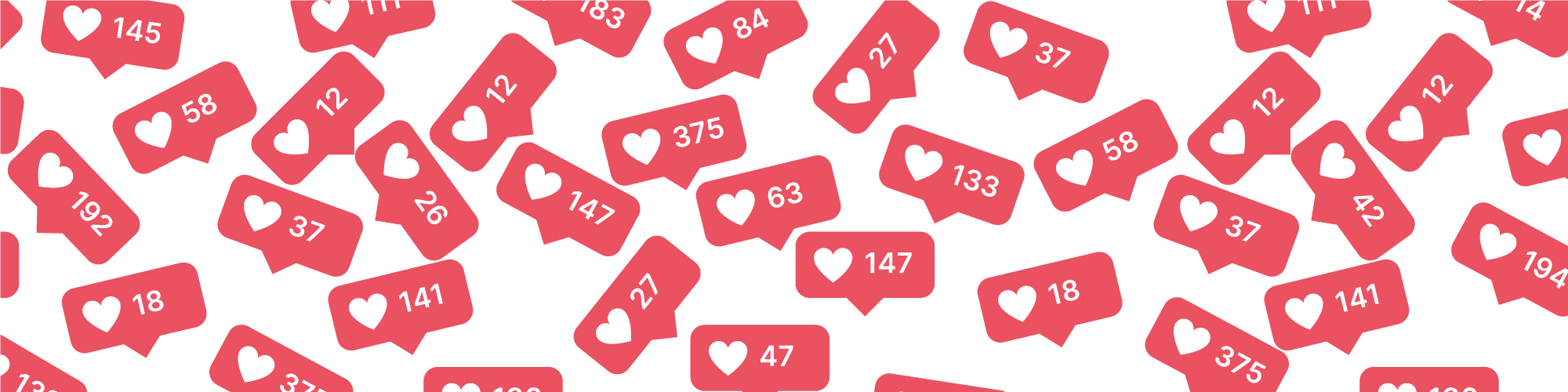

Нам могут быть не интересны точные значения (например, что видео набрало 1000 лайков, а не 1001).

К тому же, число просмотров/лайков некоторых видео может быть очень большим в сравнении с остальными. В итоге часть значений у нас встречается часто, а часть — очень редко, что негативно скажется на результате работы модели.

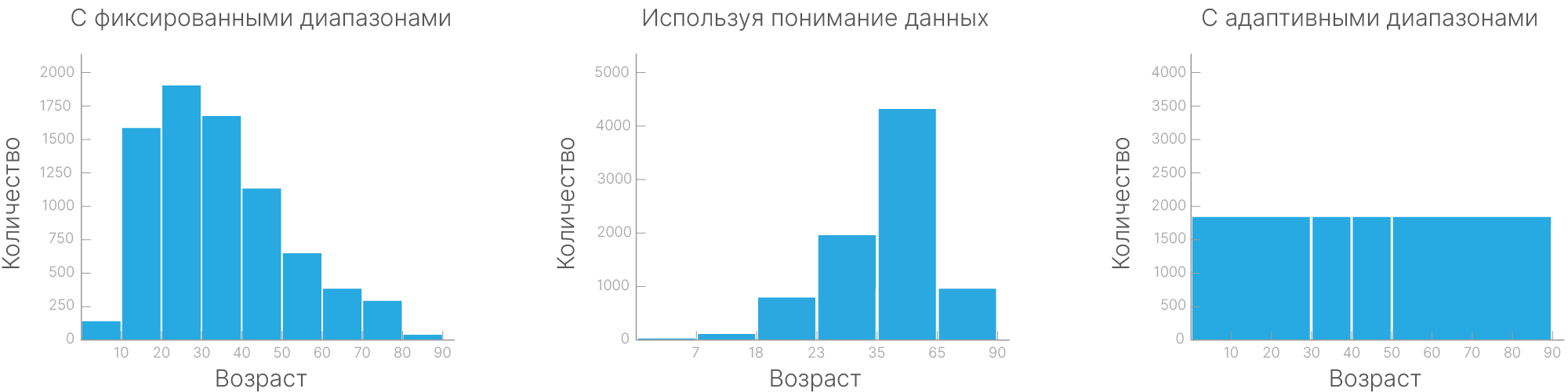

Бинирование — это метод группировки вещественных признаков в несколько категорий, определяемых диапазонами значений. При этом категория может кодироваться средним или медианным значением признака в диапазоне данной категории.

Способы деления данных:

Фиксированными диапазонами. Делим наши значения по диапазонам фиксированной длины. Так часто поступают с возрастом.

Используя понимание данных. Длина диапазона не всегда обязана быть кратна определенному ровному значению. В социальных исследованиях может быть полезным разделение на возрастные группы, которые определяются занятостью: школьники, студенты, выпускники, пенсионеры и т.д.

Адаптивными диапазонами. Бинирование с фиксированной длиной бина не поможет справиться с редкими значениями. В этой ситуации помогает бинирование, например, по квартилям — когда границы бина расставляются таким образом, чтобы между ними помещалась $1/4$ выборки.

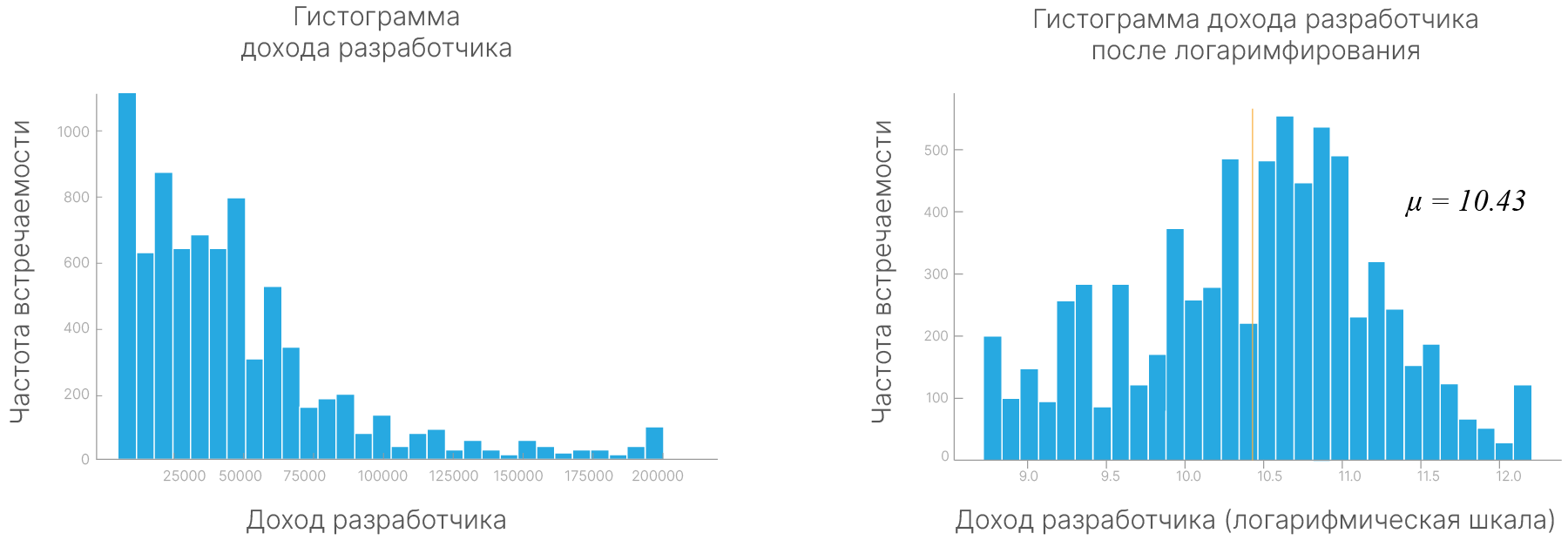

Логарифмическое преобразование — это применение логарифма к значениям признака. Это может быть полезным, если данные имеют сильно смещенное распределение, например, экспоненциальное. Логарифмическое преобразование может сделать распределение более близким к нормальному.

Квадратный корень. Взятие квадратного корня из значений признаков может помочь справиться с сильно смещенными данными. Он уменьшает влияние больших значений и увеличивает влияние меньших значений.

Преобразование Бокса-Кокса (Box-Cox Transform ✏️[blog]) — это семейство степенных преобразований, которое может адаптироваться к различным распределениям данных, общей целью которых является придать данным вид, более похожий на нормальное распределение, с которым работает бoльшее число моделей и сходимость которого лучше.

from scipy import stats

np.random.seed(42)

data = np.random.exponential(scale=2, size=1000)

plt.figure(figsize=(12, 4))

gs = plt.GridSpec(2, 3, height_ratios=[2, 1])

plt.subplot(gs[0, 0])

sns.scatterplot(x=np.arange(len(data)), y=data, s=10)

plt.title("Original Data")

plt.subplot(gs[1, 0])

sns.histplot(data, bins=30)

data_log = np.log(data)

plt.subplot(gs[0, 1])

sns.scatterplot(x=np.arange(len(data_log)), y=data_log, s=10)

plt.title("Log Transformation")

plt.subplot(gs[1, 1])

sns.histplot(data_log, bins=30)

data_boxcox, _ = stats.boxcox(data)

plt.subplot(gs[0, 2])

sns.scatterplot(x=np.arange(len(data_boxcox)), y=data_boxcox, s=10)

plt.title("Box-Cox Transformation")

plt.subplot(gs[1, 2])

sns.histplot(data_boxcox, bins=30)

plt.tight_layout()

plt.show()

Со всеми признаками производятся математические операции, поэтому для большинства моделей (деревья решений могут работать с пропущенными значениями, Meaning of Surrogate Split ✏️[blog]) отсутствие значений просто не дает производить эти операции.

Есть два основных подхода для работы с пропущенными значениями:

Удалить все объекты с пропущенными значениями.

На место пропущенных значений записать какие-то числа (заполнить пропущенные значения)

Иногда мы можем просто удалить объекты с пропущенными значениями, но если у нас мало данных и получение большего количества данных дорого/долго/невозможно, то нам нужно заполнить пропуски какими-то значениями.

Существует много способов заполнения пропусков значениями.

Рассмотрим наиболее популярные:

Заполнить константой. Можно предположить, что данные несложные, а признаки не зависят друг от друга, и заполнить пропущенные значения средними значениями соответствующего признака. Например, если средний возраст людей 30 лет, то для людей, чей возраст неизвестен, будем писать это же значение. Но в некоторых ситуациях такое заполнение может только навредить.

Предсказывать признаки моделью. Используем признак с пропущенными значениями как целевую переменную и на основе других заполненных признаков предсказываем пропущенные значения. Можем использовать алгоритм, который умеет справляться с пропусками. Один из таких алгоритмов — k-NN. Можно брать ближайших соседей по известным признакам и на место неизвестного признака подставлять среднее значение соседей.

Самостоятельно придумывать логику заполнения. Если мы имеем экспертное знание о природе пропусков, можем сами написать логику заполнения какими-то значениями.

В датасете Titanic отстался важный признак Age, который имеет пропуски. Посмотрим, как он связан с выживаемостью.

train_df = x_train.copy()

train_df["Survived"] = y_train

plt.figure(figsize=(10, 6))

age_survival_plot = sns.scatterplot(

data=train_df.groupby(["Age"], as_index=False)["Survived"].agg("sum"),

x="Age",

y="Survived",

hue="Survived",

s=70,

palette={

0: "#27a9e1",

1: "#ffab40",

2: "#ffab40",

3: "#ffab40",

4: "#ffab40",

5: "#ffab40",

6: "#49AD4D",

7: "#49AD4D",

8: "#49AD4D",

9: "#49AD4D",

11: "#49AD4D",

15: "#49AD4D",

},

)

age_survival_plot.set_title("Survived by Age")

age_survival_plot.set_xlabel("Age")

age_survival_plot.set_ylabel("Num of passengers")

custom_legend = [

plt.Line2D([0], [0], marker="o", color="w", markerfacecolor=color, markersize=10)

for color in ["#27a9e1", "#ffab40", "#49AD4D"]

]

age_survival_plot.legend(

custom_legend, ["0", "1-5", "6+"], title="Survived", loc="upper right"

)

plt.show()

Видим, что связь есть. Обучим модель без этого признака и посмотрим на результат:

x_train_working.head(3)

| SibSp | Parch | Fare | Pclass | Sex | Embarked | Title | |

|---|---|---|---|---|---|---|---|

| 331 | 0 | 0 | 28.500 | 1 | 1 | 0 | 4.0 |

| 733 | 0 | 0 | 13.000 | 2 | 1 | 0 | 4.0 |

| 382 | 0 | 0 | 7.925 | 3 | 1 | 0 | 4.0 |

results = dict()

rf = RandomForestClassifier(random_state=42)

rf.fit(x_train_working, y_train)

y_pred = rf.predict(x_test_working)

results["no feature"] = accuracy_score(y_test, y_pred).round(3)

print(f"Accuracy without feature 'Age': {results['no feature']}")

Accuracy without feature 'Age': 0.816

Заполним пропуски своей эвристикой. Вспомним, что в поле Title зашита общая информация о возрасте, посчитаем матожидание и дисперсию возраста для Title и сгенерируем недостающие значения.

np.random.seed(42)

train_df = x_train.copy()

train_df["Title"] = x_train_working["Title"]

mean = {}

std = {}

for title in range(5):

data = train_df.loc[train_df["Title"] == title]

mean[title] = data["Age"].mean()

std[title] = data["Age"].std()

def add_age_val(data, mean, std):

for i, row in data.iterrows():

if np.isnan(row["Age"]):

title = int(row["Title"])

data.loc[i, "Age"] = round(

np.random.uniform(

low=int(mean[title] - std[title]),

high=int(mean[title] + std[title]),

),

1,

)

return data

x_train_working["Age"] = x_train["Age"]

x_test_working["Age"] = x_test["Age"]

x_train_working = add_age_val(x_train_working, mean, std)

x_test_working = add_age_val(x_test_working, mean, std)

x_train_working[:5]

| SibSp | Parch | Fare | Pclass | Sex | Embarked | Title | Age | |

|---|---|---|---|---|---|---|---|---|

| 331 | 0 | 0 | 28.5000 | 1 | 1 | 0 | 4.0 | 45.5 |

| 733 | 0 | 0 | 13.0000 | 2 | 1 | 0 | 4.0 | 23.0 |

| 382 | 0 | 0 | 7.9250 | 3 | 1 | 0 | 4.0 | 32.0 |

| 704 | 1 | 0 | 7.8542 | 3 | 1 | 0 | 4.0 | 26.0 |

| 813 | 4 | 2 | 31.2750 | 3 | 0 | 0 | 3.0 | 6.0 |

Посмотрим, что получилось на обработанных данных.

rf = RandomForestClassifier(random_state=42)

rf.fit(x_train_working, y_train)

y_pred = rf.predict(x_test_working)

results["by title"] = accuracy_score(y_test, y_pred).round(3)

print(f"Accuracy with hand-filled feature 'Age': {results['by title']}")

Accuracy with hand-filled feature 'Age': 0.821

x_train_working["Age"] = x_train["Age"]

x_test_working["Age"] = x_test["Age"]

from sklearn.experimental import enable_iterative_imputer

from sklearn.impute import IterativeImputer

imputer = IterativeImputer()

imputer.fit(x_train_working)

x_train_working = imputer.transform(x_train_working)

x_test_working = imputer.transform(x_test_working)

rf = RandomForestClassifier(random_state=42)

rf.fit(x_train_working, y_train)

y_pred = rf.predict(x_test_working)

results["imputer"] = accuracy_score(y_test, y_pred).round(3)

print(f"Accuracy with feature 'Age' filled with IterativeImputer: {results['imputer']}")

Accuracy with feature 'Age' filled with IterativeImputer: 0.832

Сравним результаты при разном заполнении пропусков

pd.DataFrame([results], index=["accuracy"])

| no feature | by title | imputer | |

|---|---|---|---|

| accuracy | 0.816 | 0.821 | 0.832 |

В нашем случае IterativeImputer 🛠️[doc] дал наилучший результат. Хорошая практика — использовать данный метод как быстрый бейзлайн по заполнению пропусков.

Важно помнить, что пропуски в данных не всегда являются отсутствием значений, иногда пропуски могут быть обозначены совершенно разными способами: 0, -, (пусто), 'отсутствует', None, nan, и другие. Поэтому нужно приводить пропуски к единому формату, с которым удобно работать в дальнейшем, например np.nan.

Разведочный анализ данных (exploratory data analysis, EDA) — это процесс изучения данных с целью понимания их свойств. Его используют для поиска закономерностей, нахождения аномалий, создания новых признаков.

Это творческий процесс, и не существует единого рецепта, как это делать. Более того, разбору одной задачи можно посвятить лекцию. Наша задача в этом блоке — познакомиться с основными инструментами для анализа.

Будем работать с датасетом Wine Quality 🛠️[doc] по определению цвета вина в зависимости от его характеристик.

Загрузим датасет и сразу посмотрим, как он выглядит:

import pandas as pd

dataset = pd.read_csv(

"https://edunet.kea.su/repo/EduNet-web_dependencies/datasets/wine_quality_data.csv"

)

dataset

| fixed_acidity | volatile_acidity | citric_acid | residual_sugar | chlorides | free_sulfur_dioxide | total_sulfur_dioxide | density | pH | sulphates | alcohol | quality | is_red | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 7.4 | 0.70 | 0.00 | 1.9 | 0.076 | 11.0 | 34.0 | 0.99780 | 3.51 | 0.56 | 9.4 | 5 | 0 |

| 1 | 7.8 | 0.88 | 0.00 | 2.6 | 0.098 | 25.0 | 67.0 | 0.99680 | 3.20 | 0.68 | 9.8 | 5 | 0 |

| 2 | 7.8 | 0.76 | 0.04 | 2.3 | 0.092 | 15.0 | 54.0 | 0.99700 | 3.26 | 0.65 | 9.8 | 5 | 0 |

| 3 | 11.2 | 0.28 | 0.56 | 1.9 | 0.075 | 17.0 | 60.0 | 0.99800 | 3.16 | 0.58 | 9.8 | 6 | 0 |

| 4 | 7.4 | 0.70 | 0.00 | 1.9 | 0.076 | 11.0 | 34.0 | 0.99780 | 3.51 | 0.56 | 9.4 | 5 | 0 |

| ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... |

| 6492 | 6.2 | 0.21 | 0.29 | 1.6 | 0.039 | 24.0 | 92.0 | 0.99114 | 3.27 | 0.50 | 11.2 | 6 | 1 |

| 6493 | 6.6 | 0.32 | 0.36 | 8.0 | 0.047 | 57.0 | 168.0 | 0.99490 | 3.15 | 0.46 | 9.6 | 5 | 1 |

| 6494 | 6.5 | 0.24 | 0.19 | 1.2 | 0.041 | 30.0 | 111.0 | 0.99254 | 2.99 | 0.46 | 9.4 | 6 | 1 |

| 6495 | 5.5 | 0.29 | 0.30 | 1.1 | 0.022 | 20.0 | 110.0 | 0.98869 | 3.34 | 0.38 | 12.8 | 7 | 1 |

| 6496 | 6.0 | 0.21 | 0.38 | 0.8 | 0.020 | 22.0 | 98.0 | 0.98941 | 3.26 | 0.32 | 11.8 | 6 | 1 |

6497 rows × 13 columns

Можем сделать первые выводы об объеме датасета и количестве признаков.

Теперь посмотрим более детально, используя встроенные методы pandas:

dataset.info()

<class 'pandas.core.frame.DataFrame'> RangeIndex: 6497 entries, 0 to 6496 Data columns (total 13 columns): # Column Non-Null Count Dtype --- ------ -------------- ----- 0 fixed_acidity 6497 non-null float64 1 volatile_acidity 6497 non-null float64 2 citric_acid 6497 non-null float64 3 residual_sugar 6497 non-null float64 4 chlorides 6497 non-null float64 5 free_sulfur_dioxide 6497 non-null float64 6 total_sulfur_dioxide 6497 non-null float64 7 density 6497 non-null float64 8 pH 6497 non-null float64 9 sulphates 6497 non-null float64 10 alcohol 6497 non-null float64 11 quality 6497 non-null int64 12 is_red 6497 non-null int64 dtypes: float64(11), int64(2) memory usage: 660.0 KB

Видим, что нет пропусков. Смотрим, все ли признаки соответствуют своему Dtype, также можем оценить размер используемой памяти.

Посмотрим описательные статистики по признакам:

dataset.describe()

| fixed_acidity | volatile_acidity | citric_acid | residual_sugar | chlorides | free_sulfur_dioxide | total_sulfur_dioxide | density | pH | sulphates | alcohol | quality | is_red | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| count | 6497.000000 | 6497.000000 | 6497.000000 | 6497.000000 | 6497.000000 | 6497.000000 | 6497.000000 | 6497.000000 | 6497.000000 | 6497.000000 | 6497.000000 | 6497.000000 | 6497.000000 |

| mean | 7.215307 | 0.339666 | 0.318633 | 5.443235 | 0.056034 | 30.525319 | 115.744574 | 0.994697 | 3.218501 | 0.531268 | 10.491801 | 5.818378 | 0.753886 |

| std | 1.296434 | 0.164636 | 0.145318 | 4.757804 | 0.035034 | 17.749400 | 56.521855 | 0.002999 | 0.160787 | 0.148806 | 1.192712 | 0.873255 | 0.430779 |

| min | 3.800000 | 0.080000 | 0.000000 | 0.600000 | 0.009000 | 1.000000 | 6.000000 | 0.987110 | 2.720000 | 0.220000 | 8.000000 | 3.000000 | 0.000000 |

| 25% | 6.400000 | 0.230000 | 0.250000 | 1.800000 | 0.038000 | 17.000000 | 77.000000 | 0.992340 | 3.110000 | 0.430000 | 9.500000 | 5.000000 | 1.000000 |

| 50% | 7.000000 | 0.290000 | 0.310000 | 3.000000 | 0.047000 | 29.000000 | 118.000000 | 0.994890 | 3.210000 | 0.510000 | 10.300000 | 6.000000 | 1.000000 |

| 75% | 7.700000 | 0.400000 | 0.390000 | 8.100000 | 0.065000 | 41.000000 | 156.000000 | 0.996990 | 3.320000 | 0.600000 | 11.300000 | 6.000000 | 1.000000 |

| max | 15.900000 | 1.580000 | 1.660000 | 65.800000 | 0.611000 | 289.000000 | 440.000000 | 1.038980 | 4.010000 | 2.000000 | 14.900000 | 9.000000 | 1.000000 |

Чтобы стало нагляднее, можем использовать DataFrame.hist 🛠️[doc] прямо из pandas:

import matplotlib.pyplot as plt

dataset.hist(figsize=(20, 10), layout=(-1, 5))

plt.show()

Видим, что у нас присутствует дисбаланс классов (распределение целевого признака is_red). Почти все распределения признаков одномодальные. Можем оценить диапазон значений признаков.

import seaborn as sns

plt.figure(figsize=(8, 8))

heatmap = sns.heatmap(

dataset.corr(method="pearson", numeric_only=True).round(2),

annot=True,

square=True,

cmap="RdBu_r",

vmax=1,

vmin=-1,

cbar_kws={"fraction": 0.01}, # shrink colour bar

linewidth=2,

)

heatmap.set_xticklabels(

heatmap.get_xticklabels(), rotation=45, horizontalalignment="right"

)

heatmap.set_title("Correalation heatmap", fontdict={"fontsize": 18}, pad=16)

plt.show()

Видим, что два признака имеют высокую корреляцию между собой (free_sulfur_dioxide и total_sulfur_dioxide). Почему это плохо и что с этим делать ✏️[blog].

Также важно отметить, что корреляция Пирсона, посчитанная для категориальных признаков, может давать некорректные и бессмысленные результаты.

Поэтому на практике хорошо себя показывает Phi_K 🛠️[doc] ($\phi_k$) корреляция. Она, в отличие от корреляции Пирсона, учитывает нелинейные зависимости и работает с категориальными признаками.

!pip install -q phik

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 686.1/686.1 kB 3.9 MB/s eta 0:00:00

В этот раз отсортируем коэффициенты корреляции по целевой переменной:

import phik

plt.figure(figsize=(8, 8))

sotred_columns = (

dataset.phik_matrix(interval_cols=dataset.columns)

.round(2)

.sort_values("is_red", ascending=False, axis=1)

.columns

)

heatmap = sns.heatmap(

dataset.phik_matrix(interval_cols=dataset.columns)

.round(2)

.sort_values("is_red", ascending=False, axis=1)

.reindex(sotred_columns),

annot=True,

square=True,

cmap="Blues",

vmax=1,

vmin=0,

cbar_kws={"fraction": 0.01}, # shrink colour bar

linewidth=2,

)

heatmap.set_xticklabels(

heatmap.get_xticklabels(), rotation=45, horizontalalignment="right"

)

heatmap.set_title("Phik heatmap sorted by target", fontdict={"fontsize": 18}, pad=16)

plt.show()

Можем выделить признаки, которые имеют наибольший коэффициент. Посмотрим как они взаимодействуют друг с другом.

При большом количестве объектов бывает сложно понять, какие есть зависимости (объекты накладываются друг на друга), поэтому мы возьмем случайные 1000 объектов из нашего датасета, чтобы было нагляднее. Воспользуемся seaborn.pairplot 🛠️[doc].

sns.set_style("whitegrid")

sns.pairplot(

dataset.sample(1000),

vars=["total_sulfur_dioxide", "volatile_acidity", "chlorides"],

hue="is_red",

)

plt.show()

Можем отметить, что признак total_sulfur_dioxide действительно хорошо разделяется по целевому признаку. Также хорошее разделение видим в паре признаков total_sulfur_dioxide и volatile_acidity.

В датасете есть категориальный признак quality. Посмотрим, как распределен total_sulfur_dioxide в разрезе по целевому признаку и по каждому значению quality:

sns.catplot(

data=dataset,

x="quality",

y="total_sulfur_dioxide",

hue="is_red",

aspect=2,

alpha=0.5,

kind="violin", # strip, swarm, box, violin, boxen, point, bar, or count

split=True,

)

plt.show()

Видим, что в 9 категории нет объектов другого класса, но такой график не отражает количество объектов в категориях. Можем это посмотреть, воспользовавшись pandas.crosstab 🛠️[doc]:

cross_tab = sns.heatmap(

pd.crosstab(dataset["is_red"], dataset["quality"], normalize=True).round(4),

annot=True,

square=True,

cmap="Blues",

cbar_kws={"fraction": 0.01},

linewidth=1,

)

cross_tab.set_title("Crosstab heatmap", fontdict={"fontsize": 18}, pad=16)

plt.show()

Теперь видно, что объектов 9 категории довольно мало. Также можем оценить, в каких категориях сконцетрированы объекты.

Еще один полезный тип графика — это seaborn.relplot 🛠️[doc]. Eго удобно использовать, если у нас есть временной признак, тогда мы можем построить зависимость признака относительно времени.

У нас такого признака нет, построим два признака с раскраской по категориальной переменной quality:

relplot = sns.relplot(

data=dataset,

x="residual_sugar",

y="alcohol",

hue="quality",

kind="scatter", # or line

aspect=2,

alpha=0.6,

palette="Set2",

)

relplot.set_xticklabels(horizontalalignment="right", step=2)

plt.show()

Видно, что объекты 5 категории в среднем находятся ниже 7 категории, построим тот же seaborn.relplot, но уже для двух категорий. В этот раз для примера будем использовать параметр kind="line", который отвечает за вид графика:

relplot = sns.relplot(

data=dataset.query("quality == (5,7)"),

x="residual_sugar",

y="alcohol",

hue="quality",

kind="line",

aspect=2,

alpha=0.3,

palette="Set2",

)

relplot.set_xticklabels(horizontalalignment="right", step=2)

plt.show()

Итоги:

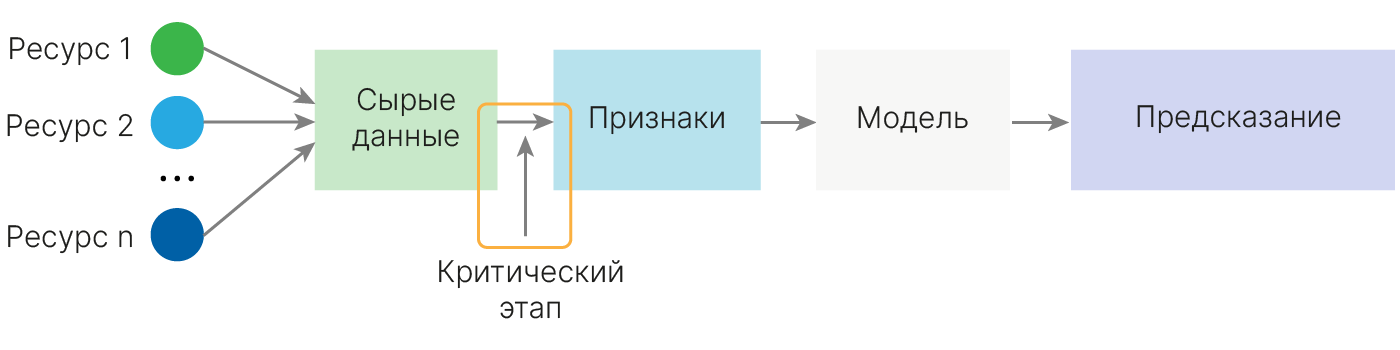

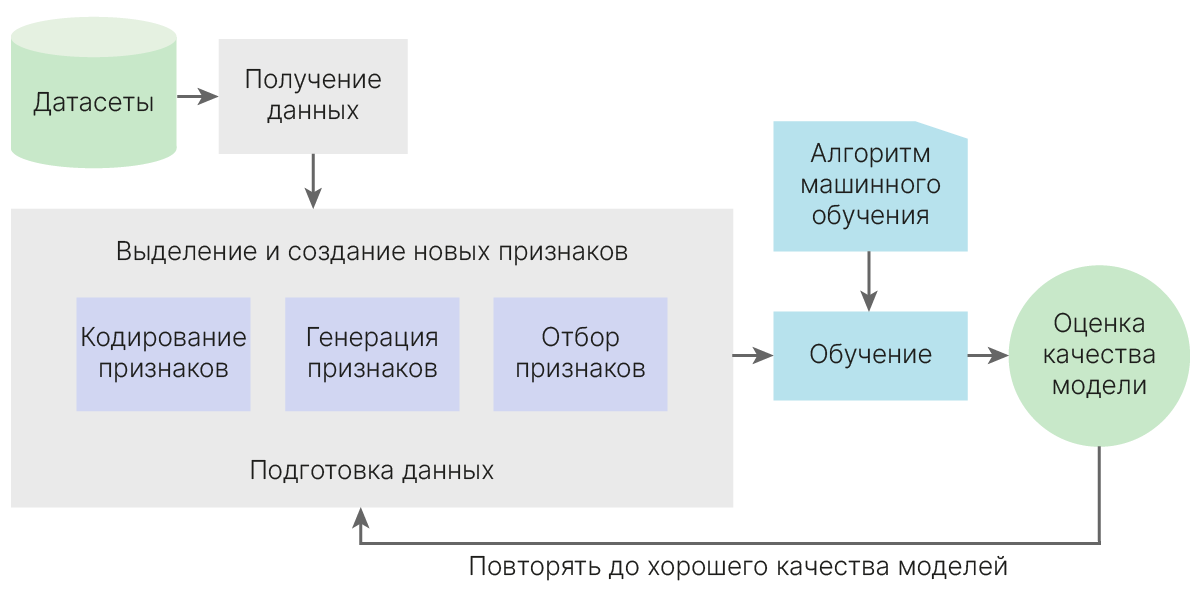

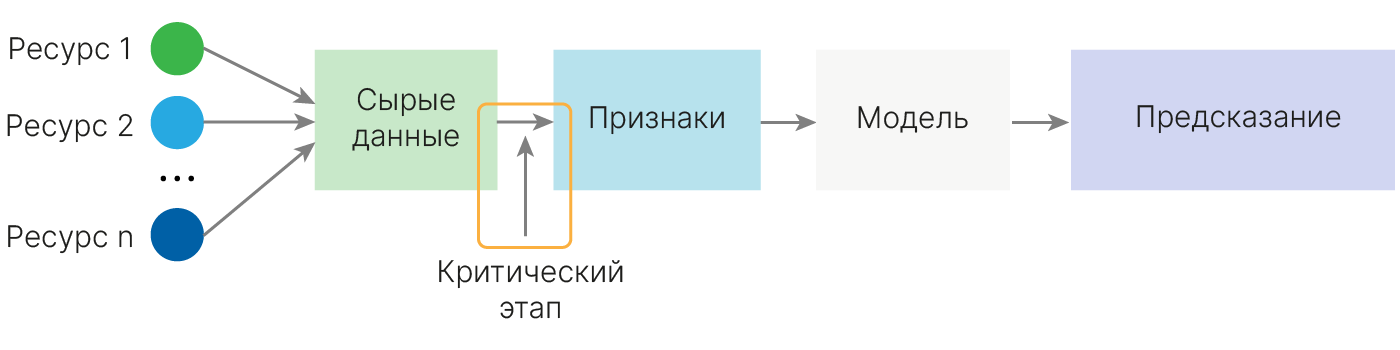

Общая схема классического машинного обучения выглядит так. Даже в случае нейросетей некоторая предобработка исходных данных все равно не бывает лишней.

Генерация признаков — процесс создания числовых представлений данных.

Процесс создания признаков зависит от модели, которую мы собираемся использовать.

Для одних моделей (линейные, древесные модели) может быть полезно добавить признаки, полученные делением/перемножением исходных. Другие модели (например, SVM) могут провести эти операции сами, причем, экономнее/менее переобучаясь.

Добавление признаков, явно зависящих друг от друга, мешает некоторым моделям. Например, плохая идея — дублировать в линейной модели признаки X1 и X2, или добавлять их сумму.

Feature engineering является критическим местом (bottleneck), в машинном обучении. На этом этапе определяется, что модель будет знать о данных. Можно упростить задачу для модели, подав подходящий набор признаков, или ввести модель в заблуждения, допустив критические ошибки.

ML модели “ленивы”: если дать модели подсказку об ответе, она не будет искать сложные закономерности в данных. Такой подсказкой может быть id покупателя. Для покупателя, который каждую неделю покупает одно и то же, модель выучит, что надо предсказывать все по признаку id. Если покупатель изменит свое поведение или придет новый покупатель, то модель может выдавать неадекватные предсказания. Такую же роль может сыграть информация о номере эксперимента, лаборатории, в которой его проводили, аспиранте, который его проводил, и т.д. Эта ситуация будет называться Data Leakage. Перечисленная выше информация может быть важна для анализа исходных данных, например, можно выяснить, что у прибора в лаборатории А проблемы с калибровкой.

При решении задачи машинного обучения важно оценивать результат. Один из способов оценить результат — это сделать базовое решение задачи. Как правило, это решение, которое требует мало времени для реализации и явно лучше случайного ответа. Далее, улучшая решение, мы можем понимать, насколько оно лучше базового и что на это повлияло (подбор гиперпараметров, кодирование признаков, генерация признаков и многое другое).

Постановка задачи следующая:

Автомобильная компания выходит на новый рынок. После интенсивного исследования рынка они пришли к выводу, что поведение нового рынка похоже на их существующий рынок. На существующем рынке отдел продаж, изучив поведение клиентов, разделил их на сегменты (классы) A, B, C, D. Для нового рынка данных о поведении нет, но есть данные о потенциальных клиентах (пол, возраст, образование, уровень дохода, состав семьи и т.д.). Нужно классифицировать потенциальных клиентов.

Загрузим датасет Customer-Segmentation 🛠️[doc] и посмотрим, какие есть признаки:

import pandas as pd

data = pd.read_csv(

"https://edunet.kea.su/repo/EduNet-web_dependencies/datasets/customer_segmentation.csv"

)

data

| ID | Gender | Ever_Married | Age | Graduated | Profession | Work_Experience | Spending_Score | Family_Size | Var_1 | Segmentation | |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 462809 | Male | No | 22 | No | Healthcare | 1.0 | Low | 4.0 | Cat_4 | D |

| 1 | 462643 | Female | Yes | 38 | Yes | Engineer | NaN | Average | 3.0 | Cat_4 | A |

| 2 | 466315 | Female | Yes | 67 | Yes | Engineer | 1.0 | Low | 1.0 | Cat_6 | B |

| 3 | 461735 | Male | Yes | 67 | Yes | Lawyer | 0.0 | High | 2.0 | Cat_6 | B |

| 4 | 462669 | Female | Yes | 40 | Yes | Entertainment | NaN | High | 6.0 | Cat_6 | A |

| ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... |

| 8063 | 464018 | Male | No | 22 | No | NaN | 0.0 | Low | 7.0 | Cat_1 | D |

| 8064 | 464685 | Male | No | 35 | No | Executive | 3.0 | Low | 4.0 | Cat_4 | D |

| 8065 | 465406 | Female | No | 33 | Yes | Healthcare | 1.0 | Low | 1.0 | Cat_6 | D |

| 8066 | 467299 | Female | No | 27 | Yes | Healthcare | 1.0 | Low | 4.0 | Cat_6 | B |

| 8067 | 461879 | Male | Yes | 37 | Yes | Executive | 0.0 | Average | 3.0 | Cat_4 | B |

8068 rows × 11 columns

data.info()

<class 'pandas.core.frame.DataFrame'> RangeIndex: 8068 entries, 0 to 8067 Data columns (total 11 columns): # Column Non-Null Count Dtype --- ------ -------------- ----- 0 ID 8068 non-null int64 1 Gender 8068 non-null object 2 Ever_Married 7928 non-null object 3 Age 8068 non-null int64 4 Graduated 7990 non-null object 5 Profession 7944 non-null object 6 Work_Experience 7239 non-null float64 7 Spending_Score 8068 non-null object 8 Family_Size 7733 non-null float64 9 Var_1 7992 non-null object 10 Segmentation 8068 non-null object dtypes: float64(2), int64(2), object(7) memory usage: 693.5+ KB

Посмотрим признак Family_Size. По смыслу он не подразумевает вещественных значений, хотя хранится в формате float64:

data["Family_Size"].unique()

array([ 4., 3., 1., 2., 6., nan, 5., 8., 7., 9.])

Действительно, все значения целые. В нашем случае не критично, но если датасет большой, то имеет смысл привести формат данных к более компактному представлению.

Видно, что есть пропуски. Для базового решения можно удалить или заполнить нулями. Мы заполним нулями и переведем все категориальные признаки в формат one-hot encoding

from sklearn.model_selection import train_test_split

data["Segmentation"] = data["Segmentation"].map({"D": 1, "A": 2, "C": 3, "B": 4})

data.fillna(0, inplace=True)

data.drop(columns=["ID"], inplace=True)

data = pd.get_dummies(data) # to ohe

x = data.drop(columns=["Segmentation"], axis=1)

y = data["Segmentation"]

x_train, x_test, y_train, y_test = train_test_split(

x, y, test_size=0.3, random_state=42

)

print("Shape of x_train :", x_train.shape)

print("Shape of y_train :", y_train.shape)

print("Shape of x_test :", x_test.shape)

print("Shape of y_test :", y_test.shape)

Shape of x_train : (5647, 32) Shape of y_train : (5647,) Shape of x_test : (2421, 32) Shape of y_test : (2421,)

Запустим модель случайного леса и посмотрим, какой результат получится:

import seaborn as sns

import matplotlib.pyplot as plt

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import confusion_matrix

from sklearn.metrics import classification_report

def train_and_plot(x_train, y_train, x_test, y_test):

model = RandomForestClassifier(random_state=42)

model.fit(x_train, y_train)

y_pred = model.predict(x_test)

# evaluating the model

print("Training Accuracy: ", model.score(x_train, y_train).round(3))

print("Testing Accuracy: ", model.score(x_test, y_test).round(3))

# confusion matrix

cm = confusion_matrix(y_test, y_pred, normalize="all")

plt.figure(figsize=(6, 6))

sns.heatmap(cm, annot=True)

# classification report

cr = classification_report(y_test, y_pred)

print(cr)

train_and_plot(x_train, y_train, x_test, y_test)

Training Accuracy: 0.966

Testing Accuracy: 0.491

precision recall f1-score support

1 0.62 0.71 0.66 692

2 0.41 0.38 0.39 597

3 0.50 0.49 0.49 580

4 0.37 0.35 0.36 552

accuracy 0.49 2421

macro avg 0.48 0.48 0.48 2421

weighted avg 0.48 0.49 0.49 2421

Мы можем использовать другие модели, чтобы получить новые признаки для наших данных. Например, используя разные модели, можем использовать их предсказания, как новые признаки. В каком-то смысле мы это уже делали на прошлой лекции, разбирая блендинг.

Генерация бинарного признакового пространства с помощью RandomForest:

Добавим новый бинарный признак, используя IsolationForest:

from sklearn.ensemble import IsolationForest

n_estimators = 300

contamination = 0.1 # threshold

model = IsolationForest(

n_estimators=n_estimators, contamination="auto", random_state=42

)

model.fit(x_train)

x_train["new_feature_1"] = model.predict(x_train)

x_test["new_feature_1"] = model.predict(x_test)

Обратите внимание, что при генерации новых признаков важно не переобучиться и не допустить утечку данных, поэтому мы обучаем IsolationForest на трейне, а не на всей выборке.

train_and_plot(x_train, y_train, x_test, y_test)

Training Accuracy: 0.966

Testing Accuracy: 0.494

precision recall f1-score support

1 0.62 0.71 0.66 692

2 0.42 0.39 0.40 597

3 0.51 0.49 0.50 580

4 0.36 0.34 0.35 552

accuracy 0.49 2421

macro avg 0.48 0.48 0.48 2421

weighted avg 0.49 0.49 0.49 2421

Качество немного улучшилось.

Можем использовать алгоритмы кластеризации, чтобы получить новые признаки. Количество кластеров можно подбирать, оно не всегда должно быть равно количеству классов. Для примера возьмем n_clusters=12.

import sklearn.cluster as cluster

clusters = cluster.KMeans(n_clusters=12, n_init="auto", random_state=42).fit(x_train)

x_train["new_feature_2"] = clusters.predict(x_train)

x_test["new_feature_2"] = clusters.predict(x_test)

x_train.head(3)

| Age | Work_Experience | Family_Size | Gender_Female | Gender_Male | Ever_Married_0 | Ever_Married_No | Ever_Married_Yes | Graduated_0 | Graduated_No | ... | Var_1_0 | Var_1_Cat_1 | Var_1_Cat_2 | Var_1_Cat_3 | Var_1_Cat_4 | Var_1_Cat_5 | Var_1_Cat_6 | Var_1_Cat_7 | new_feature_1 | new_feature_2 | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 5015 | 49 | 1.0 | 2.0 | False | True | False | False | True | False | False | ... | False | False | False | False | False | False | True | False | 1 | 6 |

| 5755 | 87 | 0.0 | 2.0 | False | True | False | False | True | False | False | ... | False | False | False | False | False | False | True | False | 1 | 4 |

| 7781 | 28 | 8.0 | 3.0 | True | False | False | True | False | False | False | ... | False | False | False | False | False | False | True | False | 1 | 2 |

3 rows × 34 columns

train_and_plot(x_train, y_train, x_test, y_test)

Training Accuracy: 0.966

Testing Accuracy: 0.503

precision recall f1-score support

1 0.63 0.71 0.67 692

2 0.43 0.40 0.42 597

3 0.50 0.49 0.50 580

4 0.39 0.37 0.38 552

accuracy 0.50 2421

macro avg 0.49 0.49 0.49 2421

weighted avg 0.50 0.50 0.50 2421

Можем генерировать признаки самостоятельно, придумывая различные гипотезы и эвристики. Это творческий процесс, и нет точного рецепта, какие признаки стоит сгенерировать. Также генерация признаков зависит от модели, для которой эти признаки генерируем. Например, признаки, описывающие нелинейное взаимодействие, могут кардинально изменить качество линейной модели.

Наша задача — рассмотреть инструменты для генерации признаков.

data = pd.read_csv(

"https://edunet.kea.su/repo/EduNet-web_dependencies/datasets/customer_segmentation.csv"

)

data.dropna(inplace=True)

data.head(3)

| ID | Gender | Ever_Married | Age | Graduated | Profession | Work_Experience | Spending_Score | Family_Size | Var_1 | Segmentation | |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 462809 | Male | No | 22 | No | Healthcare | 1.0 | Low | 4.0 | Cat_4 | D |

| 2 | 466315 | Female | Yes | 67 | Yes | Engineer | 1.0 | Low | 1.0 | Cat_6 | B |

| 3 | 461735 | Male | Yes | 67 | Yes | Lawyer | 0.0 | High | 2.0 | Cat_6 | B |

В этот раз закодируем признаки по их присутствию в данных:

data["Profession"].value_counts()

Profession Artist 2192 Healthcare 1077 Entertainment 809 Doctor 592 Engineer 582 Executive 505 Lawyer 500 Marketing 233 Homemaker 175 Name: count, dtype: int64

data["Gender"] = data["Gender"].map({"Male": 1, "Female": 0})

data["Graduated"] = data["Graduated"].map({"Yes": 1, "No": 0})

data["Ever_Married"] = data["Ever_Married"].map({"Yes": 1, "No": 0})

data["Spending_Score"] = data["Spending_Score"].map({"High": 1, "Average": 2, "Low": 3})

data["Var_1"] = data["Var_1"].map(

{"Cat_6": 1, "Cat_4": 2, "Cat_3": 3, "Cat_2": 4, "Cat_7": 5, "Cat_1": 6, "Cat_5": 7}

)

data["Segmentation"] = data["Segmentation"].map({"D": 1, "A": 2, "C": 3, "B": 4})

data["Profession"] = data["Profession"].map(

{

"Artist": 1,

"Healthcare": 2,

"Entertainment": 3,

"Doctor": 4,

"Engineer": 5,

"Executive": 5,

"Lawyer": 6,

"Marketing": 7,

"Homemaker": 8,

}

)

data.head(5)

| ID | Gender | Ever_Married | Age | Graduated | Profession | Work_Experience | Spending_Score | Family_Size | Var_1 | Segmentation | |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 462809 | 1 | 0 | 22 | 0 | 2 | 1.0 | 3 | 4.0 | 2 | 1 |

| 2 | 466315 | 0 | 1 | 67 | 1 | 5 | 1.0 | 3 | 1.0 | 1 | 4 |

| 3 | 461735 | 1 | 1 | 67 | 1 | 6 | 0.0 | 1 | 2.0 | 1 | 4 |

| 5 | 461319 | 1 | 1 | 56 | 0 | 1 | 0.0 | 2 | 2.0 | 1 | 3 |

| 6 | 460156 | 1 | 0 | 32 | 1 | 2 | 1.0 | 3 | 3.0 | 1 | 3 |

Можем производить различные математические операции с признаками: перемножать, делить, складывать и т.д. Для временных рядов полезно брать производные, считать стандартное отклонение и т.д

Для примера перемножим признак Age и Work_Experience

data["new_feature_1"] = data["Age"] * data["Work_Experience"]

data.head(3)

| ID | Gender | Ever_Married | Age | Graduated | Profession | Work_Experience | Spending_Score | Family_Size | Var_1 | Segmentation | new_feature_1 | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 462809 | 1 | 0 | 22 | 0 | 2 | 1.0 | 3 | 4.0 | 2 | 1 | 22.0 |

| 2 | 466315 | 0 | 1 | 67 | 1 | 5 | 1.0 | 3 | 1.0 | 1 | 4 | 67.0 |

| 3 | 461735 | 1 | 1 | 67 | 1 | 6 | 0.0 | 1 | 2.0 | 1 | 4 | 0.0 |

Полезный метод для генерации признаков — это pd.groupby 🛠️[doc].

Посчитаем средний возраст для каждой профессии и опыта работы:

data["new_feature_2"] = data.groupby(["Profession", "Work_Experience"], as_index=False)[

"Age"

].transform("mean")

data.head(3)

| ID | Gender | Ever_Married | Age | Graduated | Profession | Work_Experience | Spending_Score | Family_Size | Var_1 | Segmentation | new_feature_1 | new_feature_2 | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 462809 | 1 | 0 | 22 | 0 | 2 | 1.0 | 3 | 4.0 | 2 | 1 | 22.0 | 26.739255 |

| 2 | 466315 | 0 | 1 | 67 | 1 | 5 | 1.0 | 3 | 1.0 | 1 | 4 | 67.0 | 48.608466 |

| 3 | 461735 | 1 | 1 | 67 | 1 | 6 | 0.0 | 1 | 2.0 | 1 | 4 | 0.0 | 75.520548 |

Можно использовать разные функции. Например, медиану:

data["new_feature_3"] = data.groupby(["Spending_Score", "Family_Size"], as_index=False)[

"Var_1"

].transform("median")

data.head(3)

| ID | Gender | Ever_Married | Age | Graduated | Profession | Work_Experience | Spending_Score | Family_Size | Var_1 | Segmentation | new_feature_1 | new_feature_2 | new_feature_3 | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 462809 | 1 | 0 | 22 | 0 | 2 | 1.0 | 3 | 4.0 | 2 | 1 | 22.0 | 26.739255 | 1.0 |

| 2 | 466315 | 0 | 1 | 67 | 1 | 5 | 1.0 | 3 | 1.0 | 1 | 4 | 67.0 | 48.608466 | 1.0 |

| 3 | 461735 | 1 | 1 | 67 | 1 | 6 | 0.0 | 1 | 2.0 | 1 | 4 | 0.0 | 75.520548 | 1.0 |

Также можем написать свою функции и использовать ее:

import numpy as np

custom_func = lambda x: np.percentile(x, 75)

data["new_feature_4"] = data.groupby(["Spending_Score", "Family_Size"], as_index=False)[

"Age"

].transform(custom_func)

data.head(3)

| ID | Gender | Ever_Married | Age | Graduated | Profession | Work_Experience | Spending_Score | Family_Size | Var_1 | Segmentation | new_feature_1 | new_feature_2 | new_feature_3 | new_feature_4 | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 462809 | 1 | 0 | 22 | 0 | 2 | 1.0 | 3 | 4.0 | 2 | 1 | 22.0 | 26.739255 | 1.0 | 32.0 |

| 2 | 466315 | 0 | 1 | 67 | 1 | 5 | 1.0 | 3 | 1.0 | 1 | 4 | 67.0 | 48.608466 | 1.0 | 57.0 |

| 3 | 461735 | 1 | 1 | 67 | 1 | 6 | 0.0 | 1 | 2.0 | 1 | 4 | 0.0 | 75.520548 | 1.0 | 79.0 |

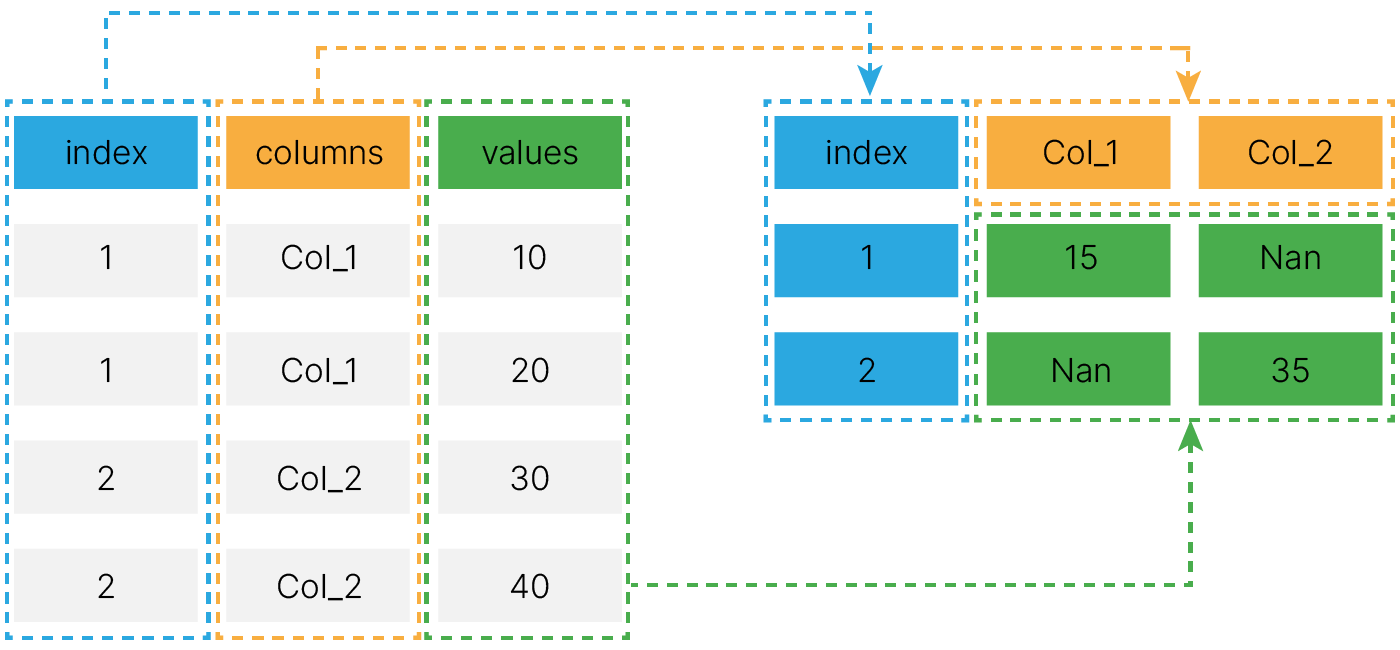

Можем сгенерировать новую таблицу признаков, используя pivot_table 🛠️[doc]:

data.pivot_table(

index="index",

columns=["columns"],

values=["values"],

aggfunc=["mean"],

)

data_pivot = data.pivot_table(

index="Family_Size", # indexes

columns=["Var_1"], # new columns

values=["Age"], # values are used fo aggfunc

aggfunc=["mean", "count"], # mean/count/sum

).fillna(0)

data_pivot.columns = [f"Cat{int(i[2])}_{i[0]}" for i in data_pivot.columns]

data_pivot.reset_index(inplace=True)

data_pivot.head(3)

| Family_Size | Cat1_mean | Cat2_mean | Cat3_mean | Cat4_mean | Cat5_mean | Cat6_mean | Cat7_mean | Cat1_count | Cat2_count | Cat3_count | Cat4_count | Cat5_count | Cat6_count | Cat7_count | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 1.0 | 49.434354 | 44.256637 | 46.272000 | 41.333333 | 40.041667 | 44.230769 | 42.777778 | 914.0 | 113.0 | 125.0 | 45.0 | 24.0 | 13.0 | 9.0 |

| 1 | 2.0 | 51.064619 | 43.015625 | 39.494048 | 45.171053 | 44.159091 | 42.187500 | 40.888889 | 1563.0 | 192.0 | 168.0 | 76.0 | 44.0 | 32.0 | 18.0 |

| 2 | 3.0 | 42.033257 | 38.161290 | 36.627907 | 36.263889 | 37.935484 | 34.476190 | 36.333333 | 872.0 | 155.0 | 129.0 | 72.0 | 31.0 | 21.0 | 12.0 |

А потом соединить ее с исходной:

data = data.merge(data_pivot, how="inner", on="Family_Size")

data.head(3)

| ID | Gender | Ever_Married | Age | Graduated | Profession | Work_Experience | Spending_Score | Family_Size | Var_1 | ... | Cat5_mean | Cat6_mean | Cat7_mean | Cat1_count | Cat2_count | Cat3_count | Cat4_count | Cat5_count | Cat6_count | Cat7_count | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 462809 | 1 | 0 | 22 | 0 | 2 | 1.0 | 3 | 4.0 | 2 | ... | 37.114286 | 39.047619 | 39.230769 | 726.0 | 158.0 | 132.0 | 89.0 | 35.0 | 21.0 | 13.0 |

| 1 | 465176 | 0 | 1 | 55 | 1 | 1 | 1.0 | 2 | 4.0 | 1 | ... | 37.114286 | 39.047619 | 39.230769 | 726.0 | 158.0 | 132.0 | 89.0 | 35.0 | 21.0 | 13.0 |

| 2 | 464942 | 1 | 0 | 19 | 0 | 2 | 4.0 | 3 | 4.0 | 2 | ... | 37.114286 | 39.047619 | 39.230769 | 726.0 | 158.0 | 132.0 | 89.0 | 35.0 | 21.0 | 13.0 |

3 rows × 29 columns

Мы довольно быстро увеличили количество признаков в нашем датасете. Проверим, как это повлияло на качество:

data.drop(columns=["ID"], inplace=True)

x = data.drop(columns=["Segmentation"], axis=1)

y = data["Segmentation"]

x_train, x_test, y_train, y_test = train_test_split(

x, y, test_size=0.3, random_state=42

)

print("Shape of x_train :", x_train.shape)

print("Shape of y_train :", y_train.shape)

print("Shape of x_test :", x_test.shape)

print("Shape of y_test :", y_test.shape)

Shape of x_train : (4665, 27) Shape of y_train : (4665,) Shape of x_test : (2000, 27) Shape of y_test : (2000,)

train_and_plot(x_train, y_train, x_test, y_test)

Training Accuracy: 0.964

Testing Accuracy: 0.472

precision recall f1-score support

1 0.60 0.67 0.63 530

2 0.38 0.36 0.37 500

3 0.50 0.52 0.51 495

4 0.35 0.32 0.34 475

accuracy 0.47 2000

macro avg 0.46 0.47 0.46 2000

weighted avg 0.46 0.47 0.47 2000

Стало хуже. Возможно, какие-то признаки и улучшали качество, но другие его испортили сильнее. После того, как мы нагенерировали много признаков, стоит задуматься о том, какие признаки улучшают качество, а какие его ухудшают.

Рассмотрим способы и подходы, чтобы отделять полезные признаки от бесполезных.

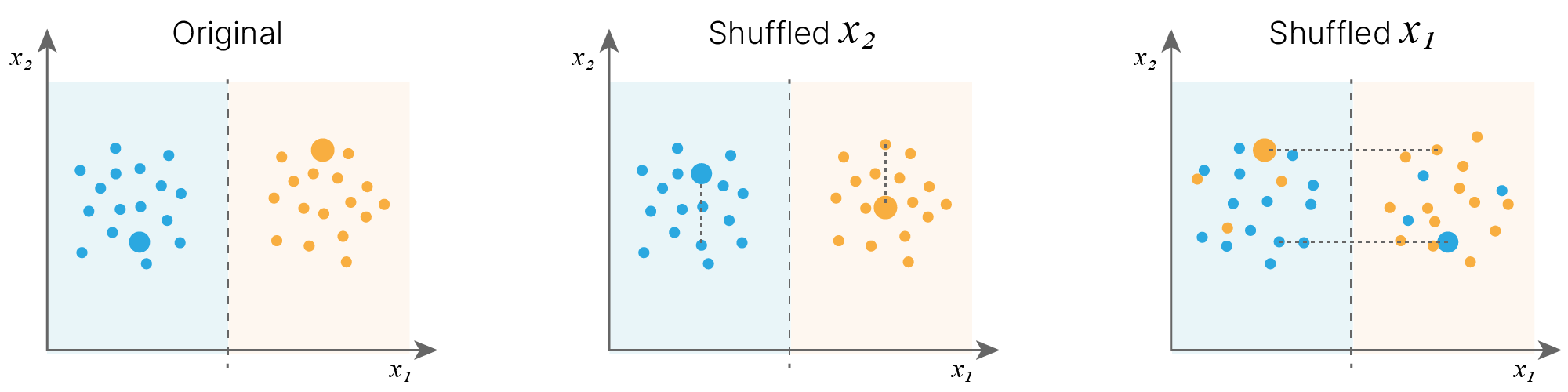

Не всегда нужно использовать все признаки, которые у нас есть и которые мы можем нагенерировать. Нам нужны только те признаки, которые позволяют решить задачу.

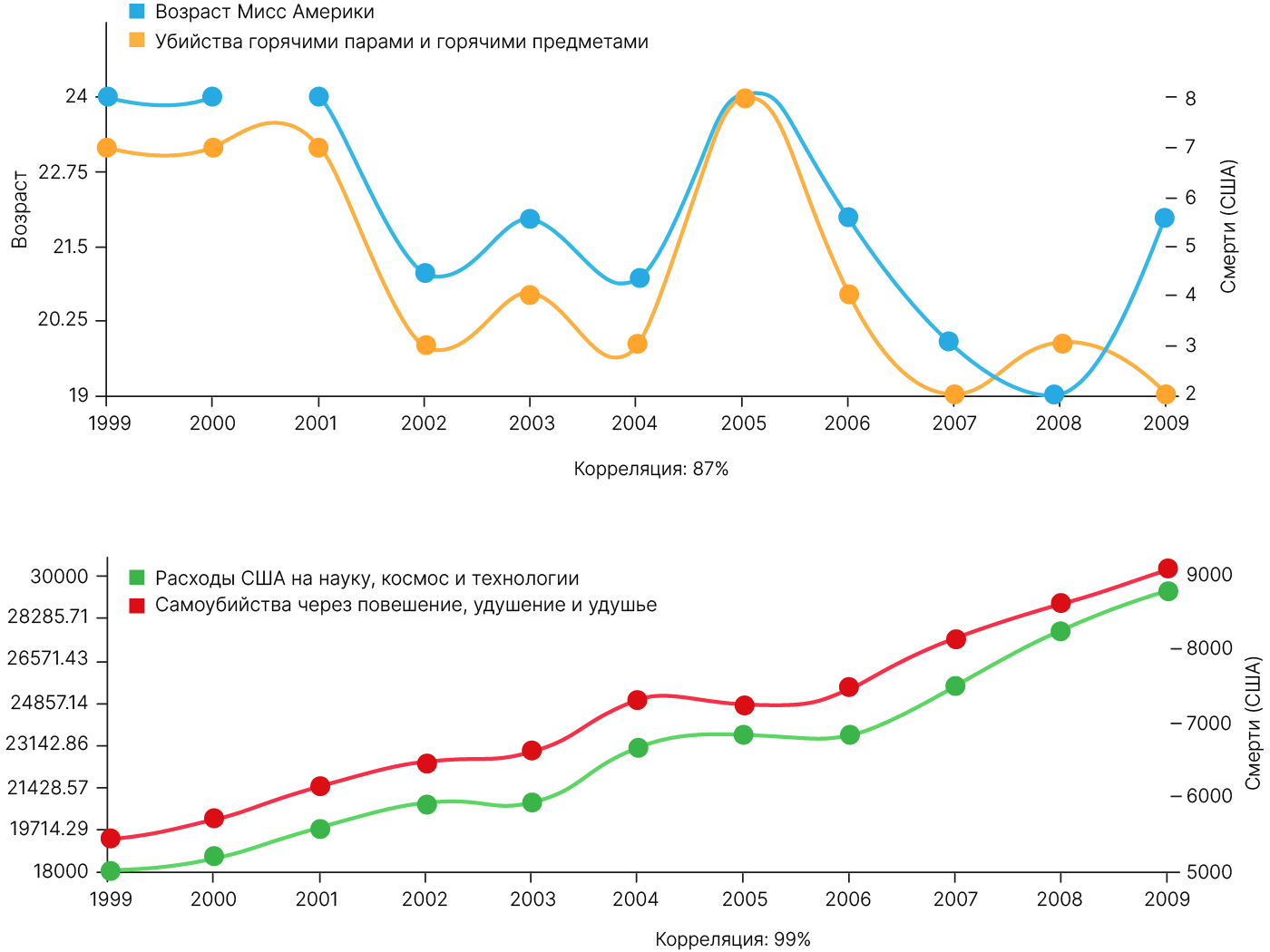

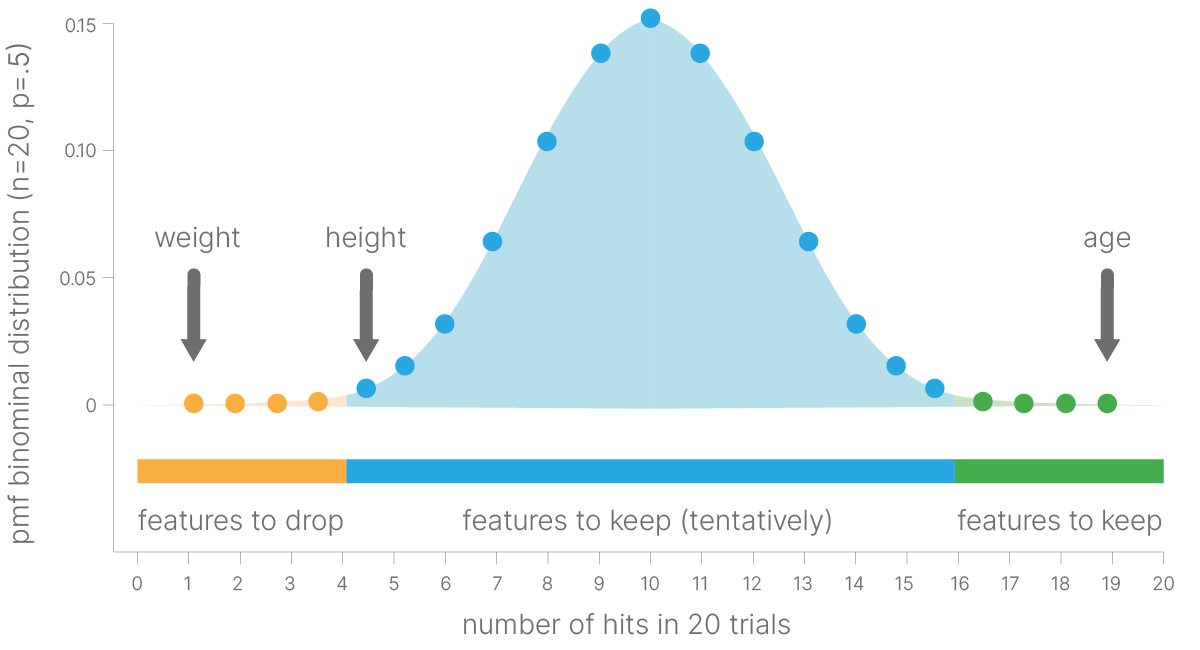

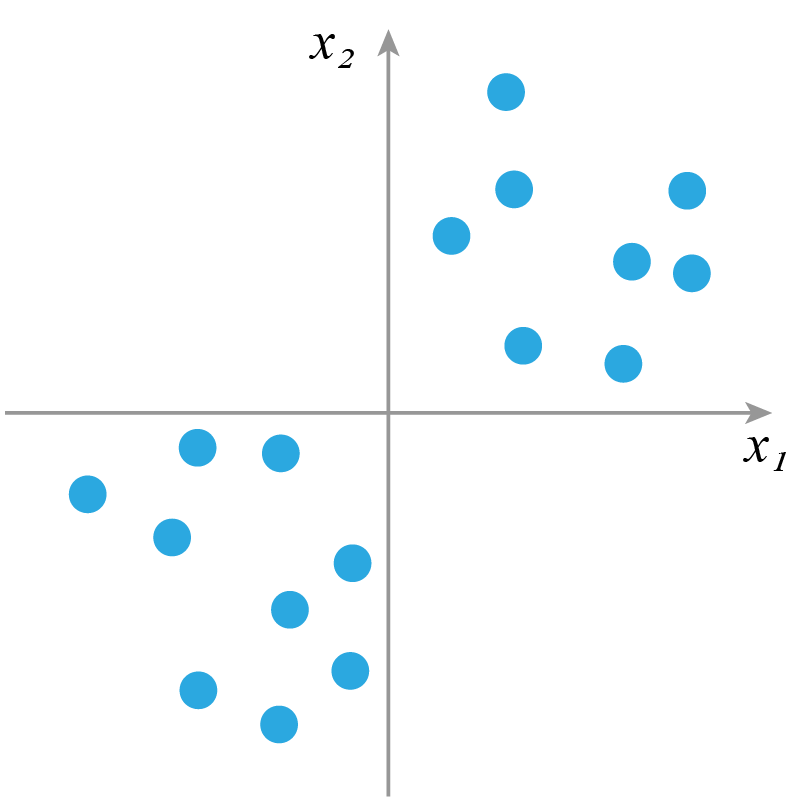

Признаки могут коррелировать с целевой переменной случайно. Если провести эксперимент и сгенерировать большое количество случайных признаков для нашего датасета, мы можем заметить эффект, что некоторые из них действительно улучшают качество предсказания, но это никак не связано с реальной закономерностью. На новых (тестовых) данных мы обнаружим неадекватность предсказаний.

В более общем случае можно говорить, что в многомерном пространстве почти всегда можно найти корреляции:

Скорость работы модели часто имеет значение

В практических задачах часто приходится искать компромисс между точностью предсказания модели и временем его получения.

Спектр таких задач достаточно широк: от проблем построения быстрых систем ранжирования рекламных объявлений в интернет-маркетинге до построения быстрых систем распознавания сложных событий на ускорителях заряженных частиц.

Вычислительная сложность модели растёт с увеличением числа входных признаков, поэтому работающие с меньшим числом признаков модели являются предпочтительными.

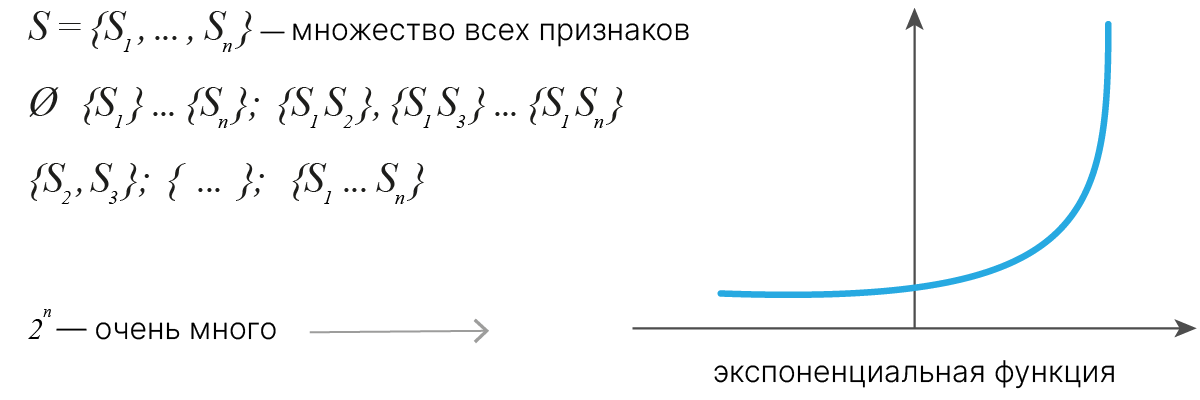

Можно попытаться перебрать все возможные комбинации признаков. Однако даже для 100 признаков такой подход будет считаться до конца Вселенной.

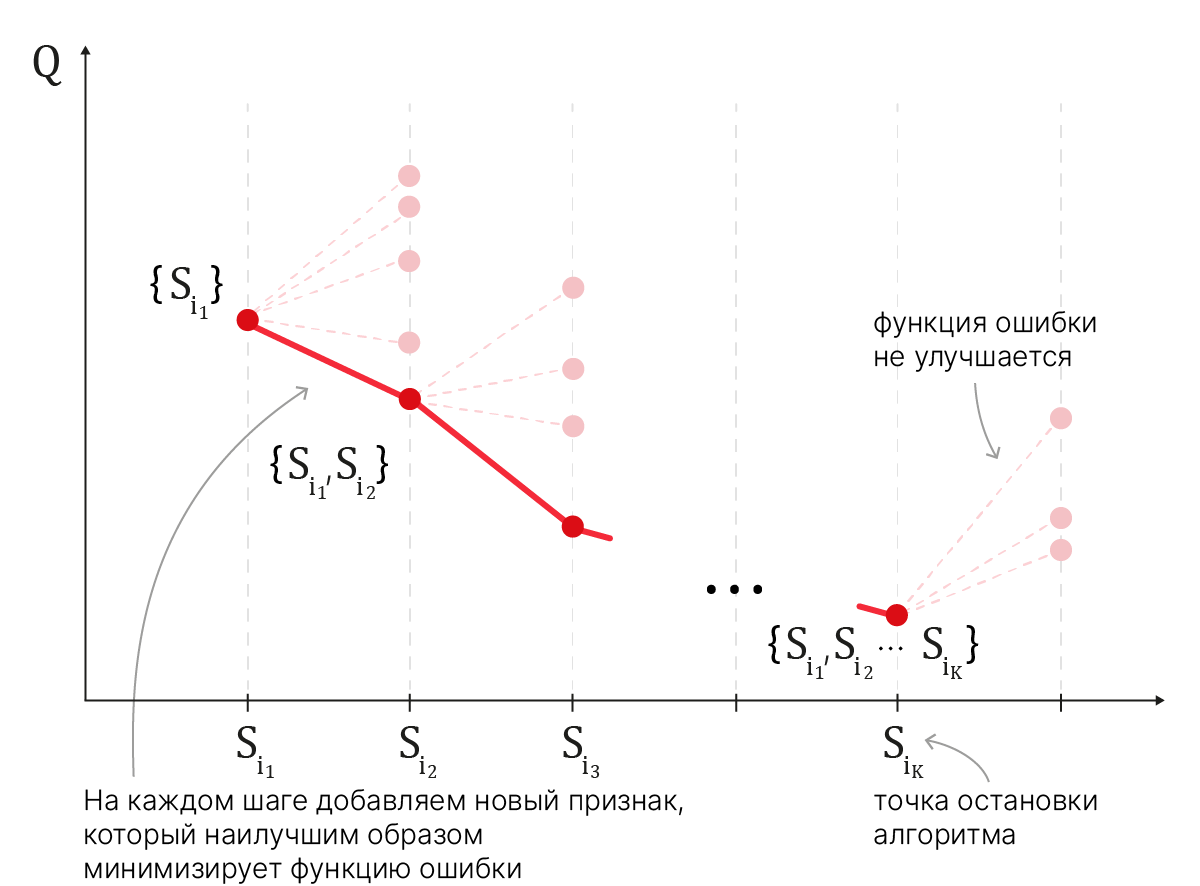

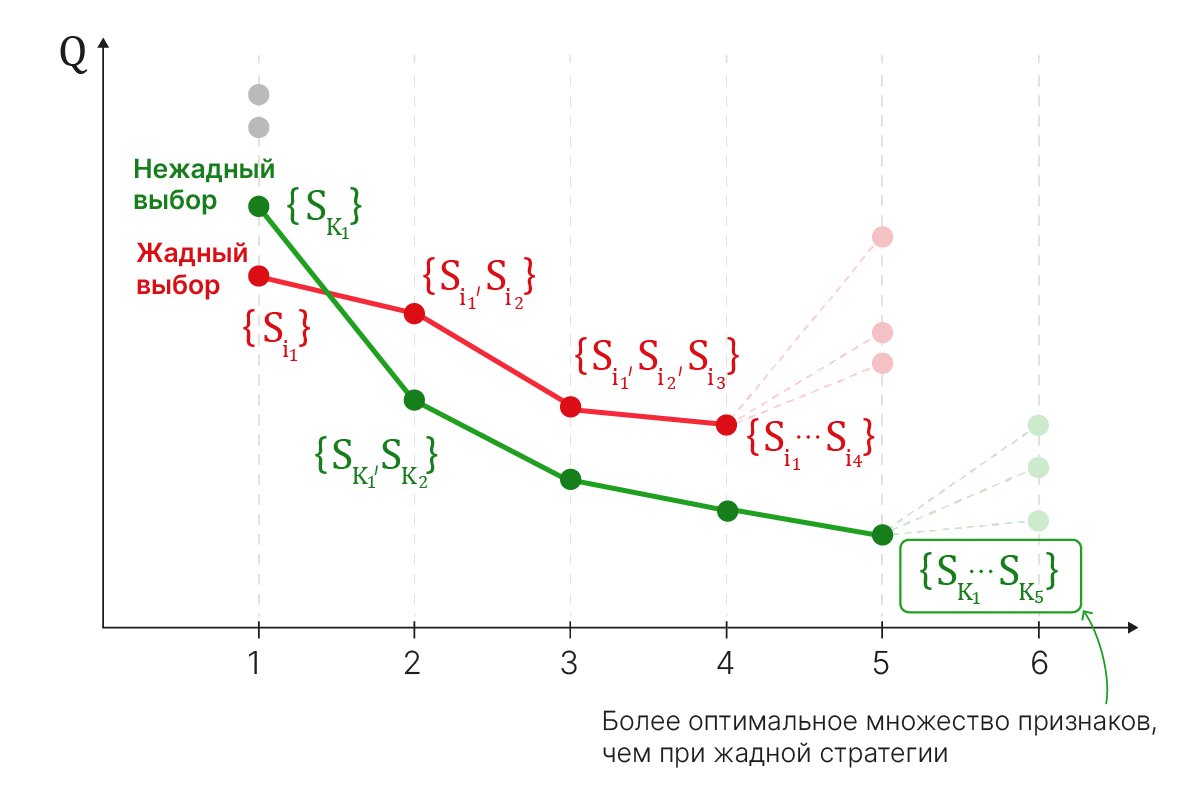

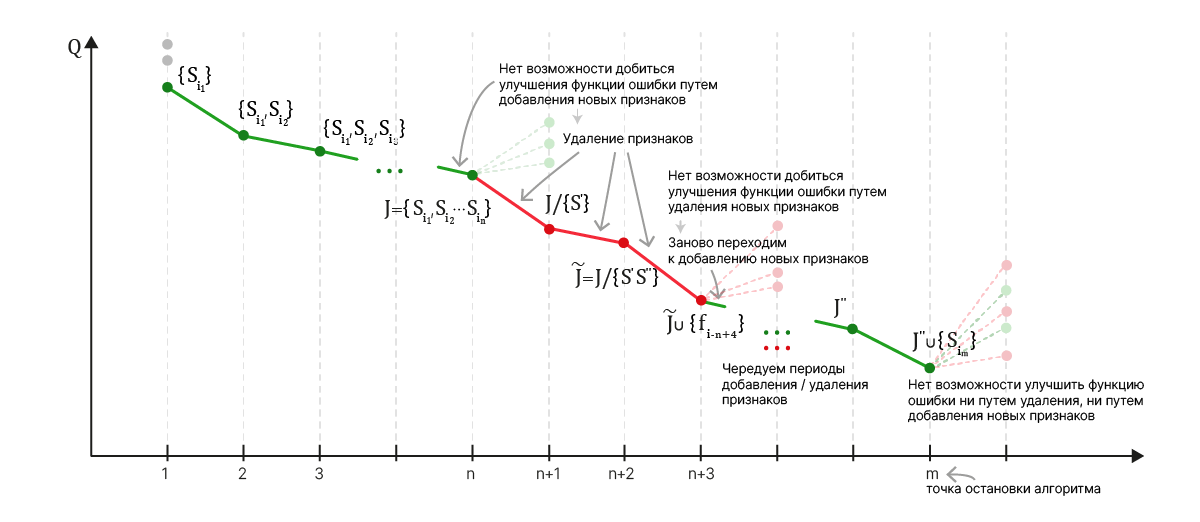

Потому прибегают к эвристикам, которые могут пропускать оптимальное решение.