Классическое машинное обучение

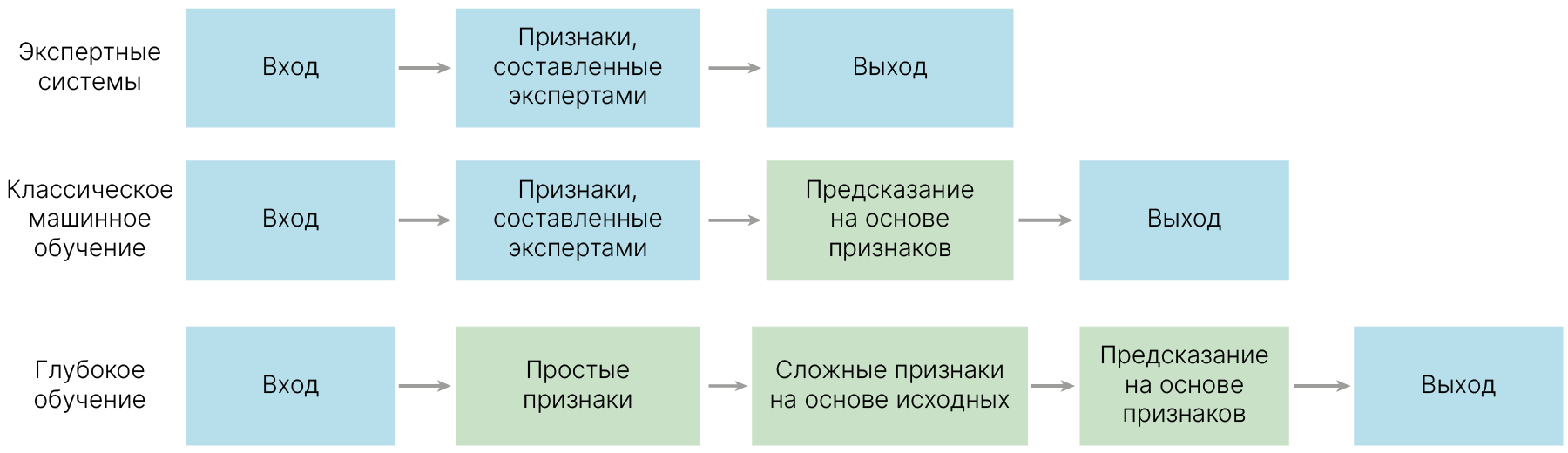

Помимо нейронных сетей, обучение работе с которыми является основной задачей курса, есть и другие подходы к проблеме создания систем, помогающих решать те или иные задачи.

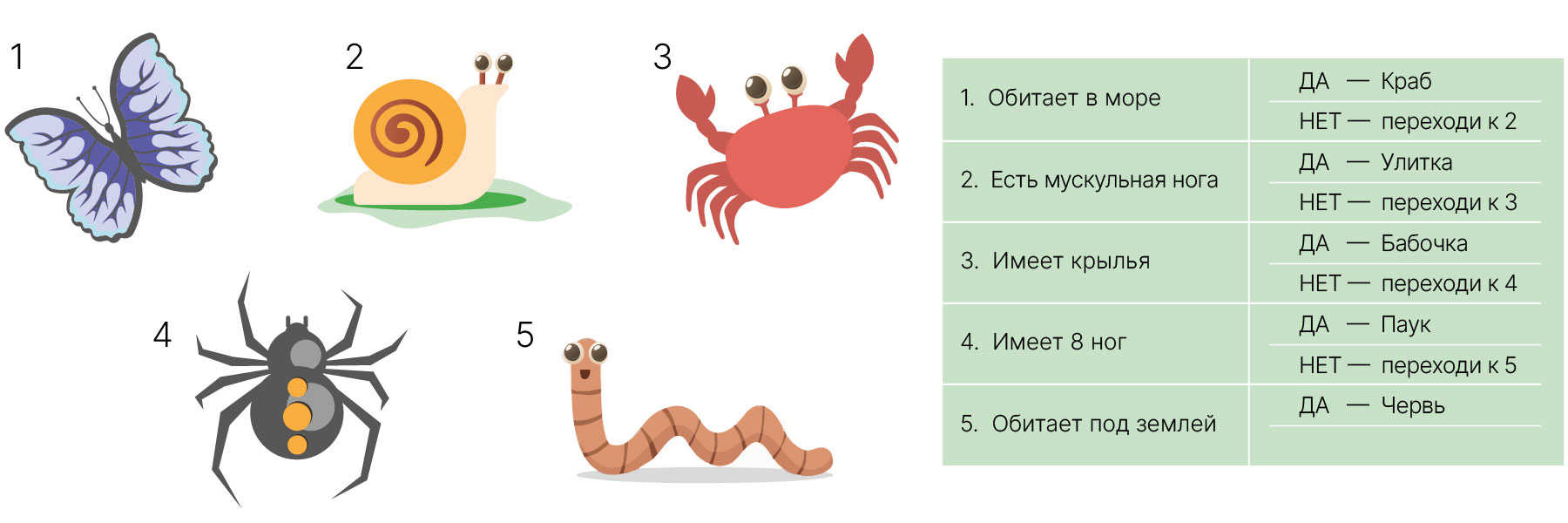

Самым первым подходом к созданию системы, способной на основе входных данных делать какие-то выводы, были так называемые Rule-based systems. В этих системах и за описание объекта — выделение значимых признаков, и за выработку правил, по которым система должна принимать то или иное решение, отвечал человек.

Такие системы до сих пор используются, например, в определителях растений. Определители представляют собой набор утверждений, например: "Растение имеет стержневую корневую систему", "Плод растения — костянка", на основе согласия/несогласия с которыми книга отсылает вас к другим утверждениям или, в конце концов, к названию растения.

Результативность такого подхода зависит от:

Единственной выгодой такой системы по сравнению с экспертом является то, что в большинстве случаев требования к умениям пользователя все же меньше.

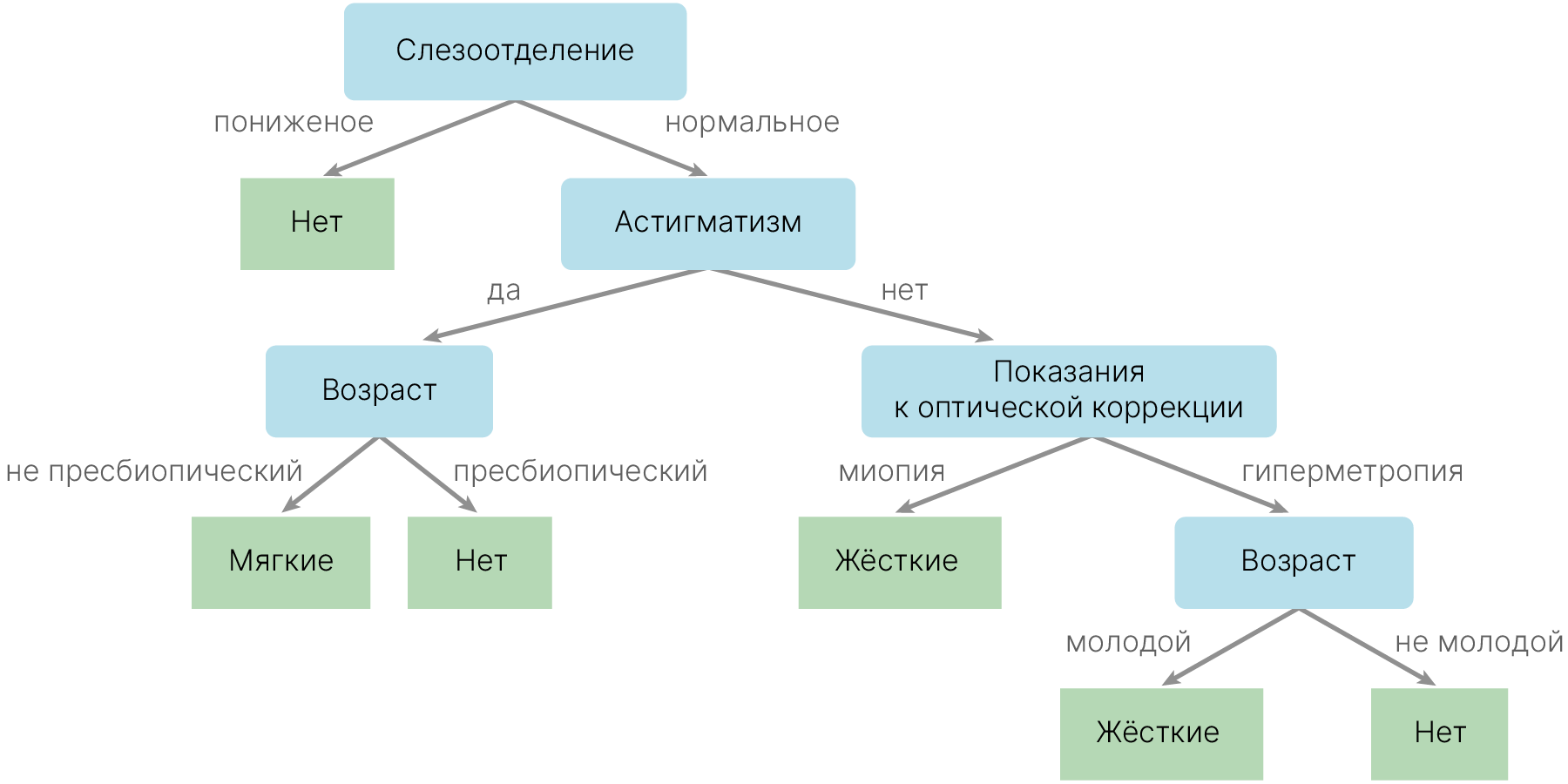

Игрушечный пример такой схемы:

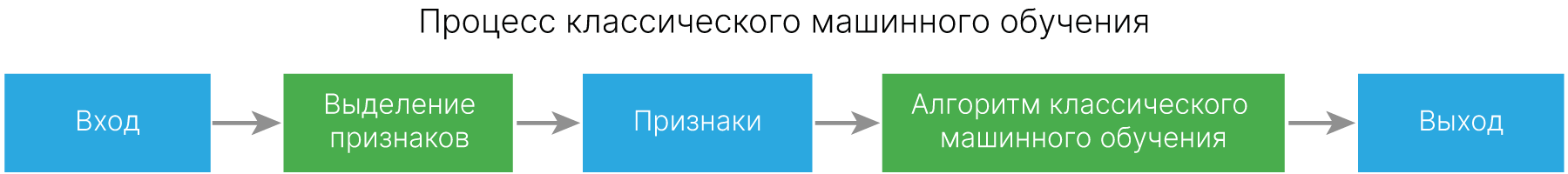

Классическое машинное обучение избавляет нас от необходимости вручную составлять какие-то правила.

В этом подходе от нас все равно требуется описание нашего объекта определенными признаками — мы должны получать это описание либо вручную, либо обрабатывая объект какими-то программами. Чтобы отличать такие признаки от признаков, которые автоматически выделяют нейронные сети, их называют hand-designed features.

Затем эти описанные объекты передаются алгоритму, который уже сам формирует набор правил, по которому он должен решать поставленную задачу. Уже разобранные вами линейная регрессия и SVM сами выбирают, какие признаки и с какими весами им учитывать при принятии финального решения. В некоторых случаях (например, SVM) признаки могут дополнительно (явно или неявно) преобразовываться внутри самой модели, и на их основе могут формироваться новые признаки.

Но главное ограничение всегда остается: за описание объекта отвечает какой-то внешний источник и то, какие признаки подавать алгоритму на вход, решает человек. А набор возможных преобразований признаков, как правило, строго фиксирован.

И составление таких признаков требует от исследователя очень хорошего знания изучаемой темы, знания специфики работы используемого алгоритма — к примеру, подавать алгоритму на вход попарные произведения всех признаков, или алгоритм сам в ходе работы их явно или неявно получит.

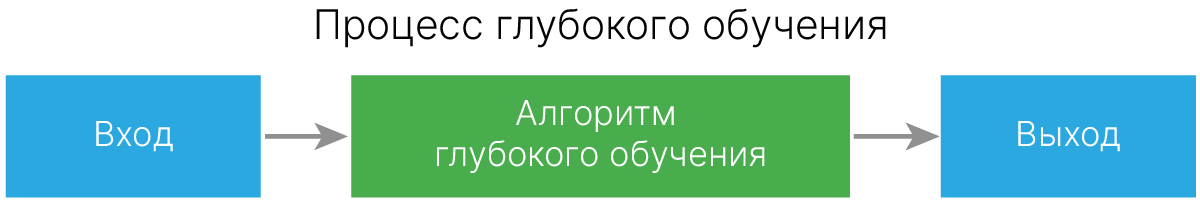

В глубоком обучении признаки может выделить нейросеть. Важно понимать, что нейросеть не гарантирует нахождение качественных признаков, но имеет шансы их получить.

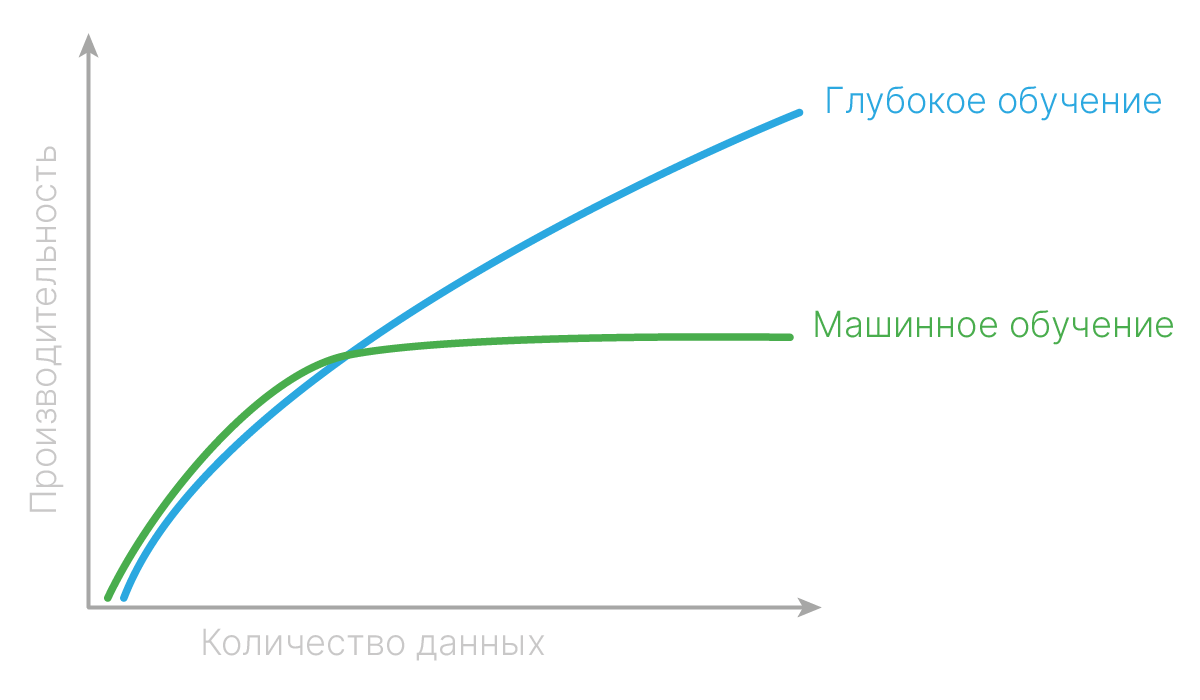

Нейросеть преобразует признаковое пространство от слоя к слою и сама определяет, какие признаки для данных объектов и для данной задачи важны, и итеративно выделяет сначала простые признаки, а затем комбинирует их в более сложные. В то время как качество подходов классического машинного обучения по мере увеличения размера обучающей выборки со временем выходит на плато, для нейросетей это плато наступает сильно позже или вообще не наступает.

Потенциально такой подход позволяет почти не применять человеческую экспертизу при построении модели под задачу. Однако в реальности человеческая экспертиза теперь переходит на уровень подбора архитектуры нейросети.

Существует ряд причин, почему важно знать и применять методы классического машинного обучения:

Деревья решений — это одни из первых моделей машинного обучения, которые были известны человеку. Изначально их строили без специальных алгоритмов, а просто вручную.

Когда требовалось принять решение по проблеме, для которой построено дерево, человек брал и проходился по этому дереву.

За принципом работы дерева решений стоит понятная интуиция. В каждом узле есть какой-то вопрос. Например, нормальное ли у человека слезоотделение, есть ли у него астигматизм и так далее. И, отвечая на каждый из этих вопросов, мы перемещаемся по дереву до тех пор, пока не придем к нужному типу линз.

Такое дерево решений можно построить без использования моделей машинного обучения, просто на основании опыта многих врачей (экспертные системы).

Вручную такие деревья строить тяжело, для большого объема данных их руками и не построишь. Также возникает вопрос: зачем нужна такая старая модель?

Оказывается, что эти модели могут быть неожиданно эффективны и их можно автоматически строить с помощью алгоритмов и делать это достаточно быстро даже на больших объемах данных.

По словам Энтони Голдблума, основателя и генерального директора Kaggle, на соревнованиях побеждают алгоритмы, основанные на деревьях решений, и нейронные сети.

Где побеждают ансамбли деревьев решений?

В любой задаче, где нет какой-то локальной связанности, которая есть в изображениях, текстах и т.д., деревья решений эффективнее, чем нейронные сети.

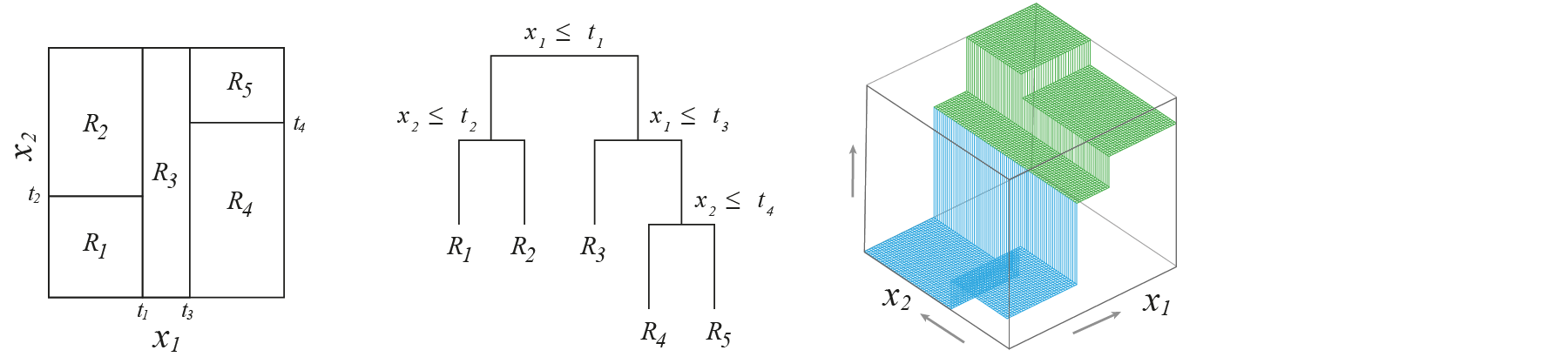

Принцип работы дерева решений можно проиллюстрировать на данном примере. Есть 2 признака, в данном случае вещественных. Для каждой точки мы создаем вопрос: признак $x_1$ больше $0.7$ или меньше? Если больше $0.7$, то это красная точка. Если меньше $0.7$, то идем во второй внутренний узел T2 и спрашиваем: признак $x_2$ меньше $0.5$ или больше? Если меньше $0.5$, то точка будет красная, в другом случае — синяя.

Разбиение пространства

Дерево решений делит пространство признаков с помощью плоскостей на области, и в каждой из этих областей предсказывается константная величина.

Деревья решений, как правило, используются при решении 2-х типов задач — классификации и регрессии. Первая — классификация. Например, предсказание типа линз.

Особенно актуальны модели, которые могут предсказывать вероятности классов. Жесткие предсказания — не самый удачный вариант, лучше оставить человеку возможность выбирать. К примеру, лекарства всегда действуют с какой-то вероятностью, потому что невозможно учесть все факторы.

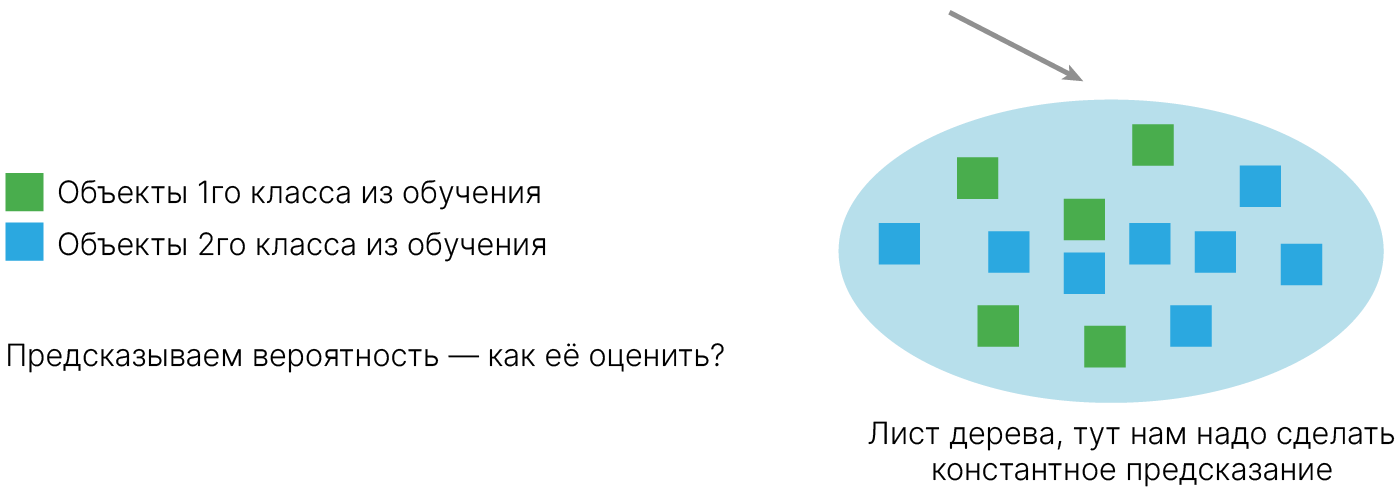

В деревьях решений в каждом листе находятся разные объекты, то есть каждому листу могут соответствовать объекты разных классов, а предсказать нужно один.

Мы хотим оценить вероятность принадлежности объекта к какому то определенному классу. Как это сделать: число представителей данного класса делим на общее число объектов. Это дает нам одну важную интуицию: желательно, чтобы в листе дерева было не очень мало объектов. Чем объектов меньше, тем больше возможная ошибка.

Это согласуется с тем, как мы делаем в статистике. При построении дерева мы видим только обучающую выборку, а хотим делать выводы о генеральной совокупности. Конкретно здесь мы оцениваем, какая доля из объектов, попадающих в данный узел, принадлежит нужному классу. Можно использовать распределение Бернулли 📚[wiki] для двух классов или мультиномиальное распределение 📚[wiki] для большего количества классов.

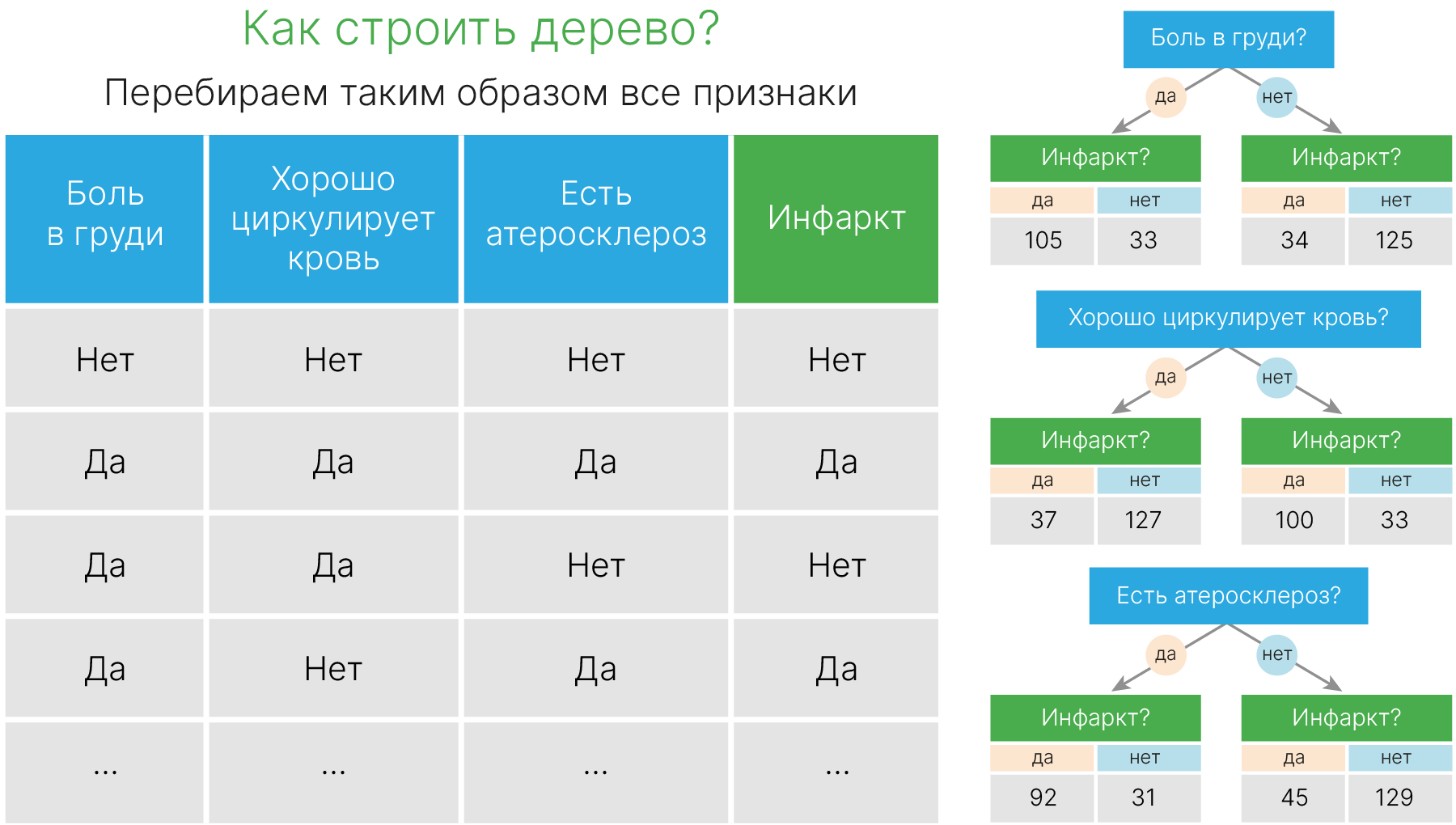

Представим, что мы решаем задачу бинарной классификации (есть инфаркт у человека или нет). В наших табличных данных только бинарные признаки. Мы хотим построить дерево решений по этой таблице.

Возьмем в качестве первого вопроса признак "боль в груди". В 1-ом и во 2-ом листе получается разное распределение людей. В левом листе инфаркт более вероятен, в правом — менее вероятен.

Другим признаком может быть “как хорошо циркулирует кровь”, в таком случае тоже получится неплохое разделение. Последний признак — “есть ли атеросклероз”.

Мы получили три разбиения по разным признакам. Теперь мы бы хотели выбрать лучший признак, а для этого нам нужно их сравнить.

Логично выбрать такое разбиение, которое дает нам "хорошие" узлы — те, в которых преимущественно сосредоточены объекты одного класса

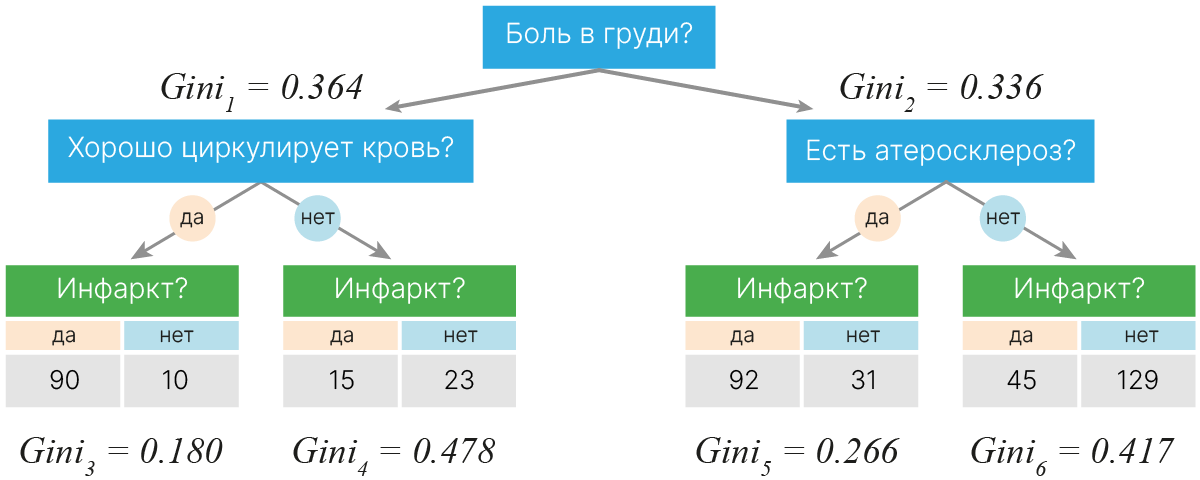

Одна из используемых метрик называется Gini ✏️[blog] . Она считается по следующей формуле:

$$\large \text{Gini} = 1 - \sum_ip_i^2$$Gini — мера неопределенности ✏️[blog] значения класса внутри узла. Соответственно, чем она ниже, тем лучше получившийся узел.

Посчитаем Gini для признака "Боль в груди":

$\text{Gini}_1 = 1- (\dfrac{105}{105+33})^2 - (\dfrac{33}{105+33})^2 = 0.364$

$\text{Gini}_2 = 1- (\dfrac{34}{34+125})^2 - (\dfrac{125}{34+125})^2 = 0.336$

Такую метрику можно посчитать для каждого узла. Дальше посчитать метрику для следующего узла. Дальше можем оценить насколько стал лучше результат в зависимости от используемого признака.

где $n_1, n_2$ — число объектов в листьях,

$ \quad\ \text{Gini}_0$ — чистота исходного узла.

Боль в груди:

$\text{Impurity decrease} = 0.498 - (\dfrac{138}{138+159})\cdot 0.364 - (\dfrac{159}{138+159})\cdot 0.336 = 0.149$

Хорошо циркулирует кровь:

$\text{Impurity decrease} = 0.498 - (\dfrac{164}{164+133})\cdot 0.349 - (\dfrac{133}{164+133})\cdot 0.373 = 0.138$

Есть атеросклероз:

$\text{Impurity decrease} = 0.498 - (\dfrac{123}{123+174})\cdot 0.377 - (\dfrac{174}{123+174})\cdot 0.383 = 0.117$

Выбираем это разбиение как приводящее к наибольшему уменьшению Impurity

Наибольший $\text{Impurity decrease}$ в признаке “боль в груди”. Значит, мы возьмем “боль в груди” как признак, на основании которого продолжим строить дерево.

Каждый раз мы будем выбирать новые признаки. В одном листе один признак лучше разделяет его на 2, в другом — другой. Тут мы остановились при достижении глубины дерева 2.

Мы могли выбрать другой критерий остановки. Например, когда у нас получатся листья, в которых есть объекты только 1 класса. В этом случае не имеет смысла использовать другие разбиения. Либо может сложиться ситуация, когда разбиение по признаку, которое мы дополнительно взяли, ситуацию никак не улучшает.

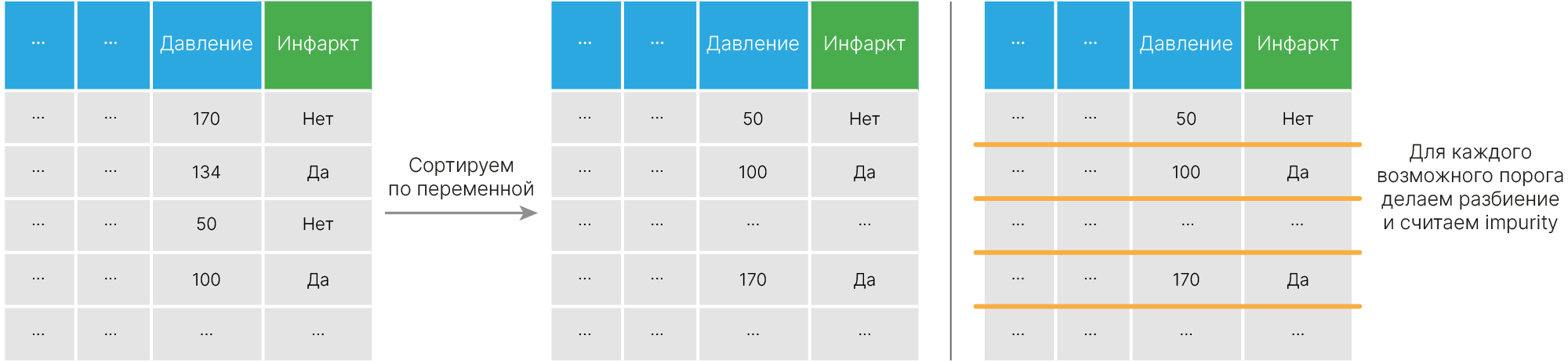

Вещественный признак сортируется, после чего мы выбираем оптимальный порог для разбиения. Для этого считаем impurity_decrease для каждого порога и выбираем лучший.

Для решения задач регрессии дерево строится практически так же, но есть несколько нюансов.

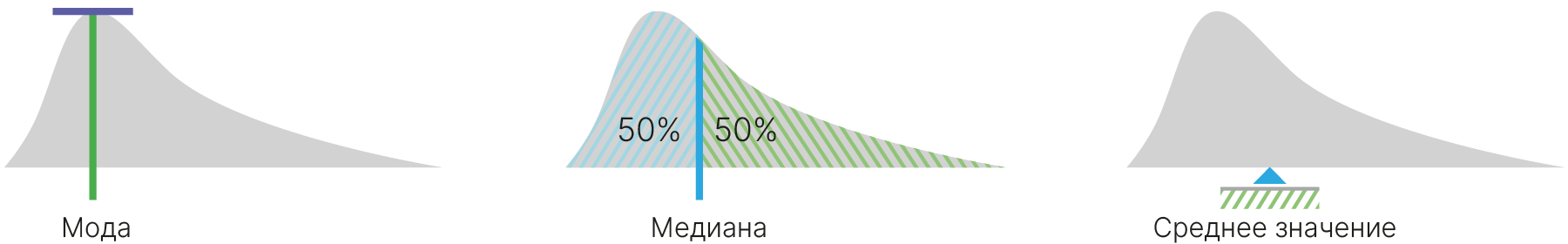

Как лучше всего одним числом охарактеризовать все эти объекты, попавшие в один лист?

Если мы вспомним статистику, то у нас нет однозначного ответа. Мы можем для распределения всех этих объектов в листе предсказывать наиболее частое значение, медиану, среднее значение.

Обычно предсказывают среднее значение, потому что с ним легче всего работать и его чаще всего используют в статистике.

Хотим оценить среднее всех объектов генеральной совокупности, попадающих в данный узел, используя объекты из тренировочной выборки, попавшие в данный узел.

$$\large \overline{y} = \dfrac {\sum_i y_i} {n}$$У нашей оценки будет дисперсия, которая показывает, насколько сильно мы можем ошибаться по сравнению с реальным (несмещенным) средним.

$$\large D(Y) = \dfrac {\sum_{i=1}^n(y_i-\overline{y})} {n-1} $$Из-за неточности в оценке среднего при оценке дисперсии в знаменателе стоит $n-1$. Желательно иметь в каждом листе достаточное число объектов, чтобы компенсировать эту $-1$.

Теперь надо сформулировать критерий качества узла для регрессионного дерева. Мы хотим, чтобы значения в узле отличались как можно меньше. В этом случае наше среднее будет предсказывать значение для объекта, попавшего в узел, с меньшей ошибкой. В идеале мы хотим, чтобы все значения были одинаковы.

MSE на тренировочной выборке, если мы предсказываем ее среднее, будет таким:

$$\large \text{MSE} = \frac 1 N \sum_{l=1}^L \sum_{i=1}^{n_l} (y_{li} - \overline{y_l})^2 = \frac 1 N \sum_{l=1}^L \sum_{i=1}^{n_l}\dfrac{n_l-1}{n_l}D(Y_l),$$где $N$ — общее количество объектов в выборке, $L$ — общее число листьев, $n_l$ — число объектов в листе $l$.

Уменьшение дисперсии листьев $D(Y_l)$ приводит к уменьшению $MSE$.

Дополнительно будем взвешивать дисперсии на размер узла. Иначе самыми выгодными будут разбиения, отправляющие в один из узлов только один объект.

Разбиение регрессионного дерева:

$$\large R_1(j, s) = \{ Y | x_j \leq s \} \ \text{and} \ R_2(j, s) = \{ Y | x_j > s \}$$Мера качества узла — дисперсия оценки $R_0$.

Остальное так же, как с классификацией:

$$\large \frac{D_{R_1} \cdot n_1 + D_{R_2} \cdot n_2}{n_1 + n_2} < D_{R_0} $$Взгляд с точки зрения функционального анализа

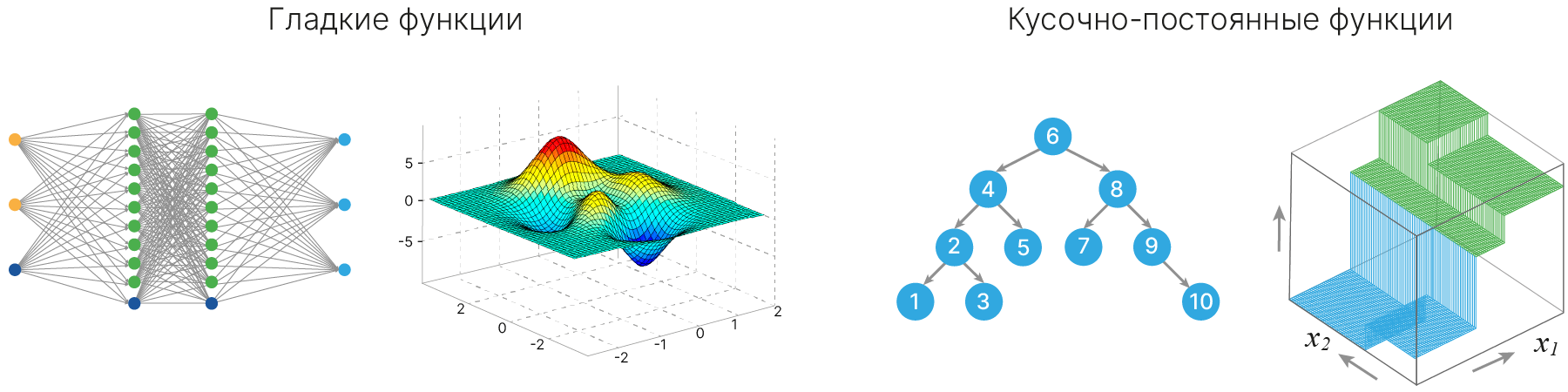

$\displaystyle \qquad \qquad h(x) = \sum \sigma(\dots \sum(w^Tx)) \qquad \qquad \qquad \qquad \qquad \qquad \qquad \qquad h(x) = \sum_dc_dI\{x \in R_d\}$

У деревьев решений есть еще одно хорошее свойство. Позже вы познакомитесь с замечательной теоремой об универсальном аппроксиматоре 📚[wiki]. Ее суть в том, что нейросеть с одним скрытым слоем сможет аппроксимировать любую заданную гладкую функцию.

Для деревьев решений есть аналогичная теорема, говорящая о том, что дерево может аппроксимировать любую заданную кусочно-постоянную функцию.

Дерево решений, в отличие от нейронной сети, может адаптироваться к выборке любого размера, любому количеству признаков. Для нейронной сети эта теорема предполагает, что можно бесконечно увеличивать скрытые слои.

В случае же с деревьями решений лист разбивается еще на 2 части. Это можно делать бесконечно до тех пор, пока в каждом листе не окажется по одному объекту. Это приведет к сильному переобучению, но, если бы у нас была вся генеральная совокупность, мы бы выучили ее гораздо легче деревом решений, чем нейронной сетью.

Деревья решений не используются в чистом виде, потому что они неустойчивы. Если у нас есть данные, и мы удалим из них 2 объекта, то дерево решений может сильно поменяться.

Продемонстрируем неустойчивость решения, получаемого при помощи деревьев решений, на примере датасета Iris (ирисы Фишера 📚[wiki]).

Ирисы Фишера состоят из данных о 150 экземплярах ириса, по 50 экземпляров трёх видов: Ирис щетинистый (Iris setosa), Ирис виргинский (Iris virginica) и Ирис разноцветный (Iris versicolor).

Для каждого экземпляра измерялись четыре характеристики (в сантиметрах):

Будем учиться отделять Ирис виргинский (versicolor) от остальных видов.

from sklearn.datasets import load_iris

import pandas as pd

dataset = load_iris()

df = pd.DataFrame(dataset.data, columns=dataset.feature_names)

df["target"] = dataset.target != 1 # 0 for setosa, 1 - versicolor, 2 - virginica

Сделаем два разных разбиения на обучение и тест. И посмотрим, будут ли отличаться деревья, построенные для данных разбиений.

import matplotlib.pyplot as plt

from sklearn import tree

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import train_test_split

# first set of points

x_train1, x_test1, y_train1, y_test1 = train_test_split(

df[dataset.feature_names], df["target"], random_state=0

)

clf1 = DecisionTreeClassifier(max_depth=3)

clf1.fit(x_train1, y_train1)

# second set of points

x_train2, x_test2, y_train2, y_test2 = train_test_split(

df[dataset.feature_names], df["target"], random_state=42

)

clf2 = DecisionTreeClassifier(max_depth=3)

clf2.fit(x_train2, y_train2)

fn = ["sepal length (cm)", "sepal width (cm)", "petal length (cm)", "petal width (cm)"]

cn = ["setosa", "versicolor", "virginica"]

fig, axes = plt.subplots(nrows=1, ncols=2, figsize=(15, 5), dpi=100)

tree.plot_tree(clf1, feature_names=fn, class_names=cn, filled=True, ax=axes[0])

tree.plot_tree(clf2, feature_names=fn, class_names=cn, filled=True, ax=axes[1])

plt.show()

Видим, что даже деревья максимальной глубины 3 уже не совпадают между собой. Справедливо отметить, что у нас маленький датасет — как правило, чем датасет больше, тем устойчивее будет получаться дерево на первых уровнях.

Если использовать деревья бОльшей глубины, то и структура деревьев (то, как они выглядят, даже если не обращать внимания на конкретные признаки в узлах), будет отличаться.

# first set of points

clf1 = DecisionTreeClassifier(max_depth=10, random_state=0)

clf1.fit(x_train1, y_train1)

# second set of points

clf2 = DecisionTreeClassifier(max_depth=10, random_state=42)

clf2.fit(x_train2, y_train2)

fn = ["sepal length (cm)", "sepal width (cm)", "petal length (cm)", "petal width (cm)"]

cn = ["setosa", "versicolor", "virginica"]

fig, axes = plt.subplots(nrows=1, ncols=2, figsize=(15, 5), dpi=100)

tree.plot_tree(clf1, feature_names=fn, class_names=cn, filled=True, ax=axes[0])

tree.plot_tree(clf2, feature_names=fn, class_names=cn, filled=True, ax=axes[1])

plt.show()

Если алгоритм при небольшом изменении признаков сильно меняет свое решение, то это указывает на возможное переобучение. Алгоритм сильно реагирует на любой шум в данных— доверять его решениям опасно.

Посмотрим это на синтетическом датасете:

# handson-ml

import numpy as np

from matplotlib.colors import ListedColormap

def plot_decision_boundary(

clf, x, y, axes=[-1.5, 2.5, -1, 1.5], alpha=0.85, contour=True, bolded=False

):

x1s = np.linspace(axes[0], axes[1], 100)

x2s = np.linspace(axes[2], axes[3], 100)

x1, x2 = np.meshgrid(x1s, x2s)

x_new = np.c_[x1.ravel(), x2.ravel()]

y_pred = clf.predict(x_new).reshape(x1.shape)

custom_cmap = ListedColormap(["#FEE7D0", "#bea6ff", "#B8E1EC"])

plt.contourf(x1, x2, y_pred, alpha=0.3, cmap=custom_cmap)

if contour:

custom_cmap2 = ListedColormap(["#FEE7D0", "#5D5DA6", "#B8E1EC"])

if bolded:

custom_cmap2 = ListedColormap(["#FEE7D0", "#5D5DA6", "#000000"])

plt.contour(x1, x2, y_pred, cmap=custom_cmap2)

plt.plot(x[:, 0][y == 0], x[:, 1][y == 0], "D", c="#F9B041", alpha=alpha)

plt.plot(x[:, 0][y == 1], x[:, 1][y == 1], "o", c="#2DA9E1", alpha=alpha)

plt.axis(axes)

plt.xlabel(r"$x_1$", fontsize=18)

plt.ylabel(r"$x_2$", fontsize=18, rotation=0)

import sklearn

x, y = sklearn.datasets.make_moons(n_samples=500, noise=0.30, random_state=42)

plt.figure(figsize=(8, 6))

plt.plot(x[:, 0][y == 0], x[:, 1][y == 0], "D", c="#F9B041")

plt.plot(x[:, 0][y == 1], x[:, 1][y == 1], "o", c="#2DA9E1")

plt.show()

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=42)

plt.figure(figsize=(8, 6))

clf = DecisionTreeClassifier(max_depth=20, random_state=42)

clf.fit(x_train, y_train)

plot_decision_boundary(clf, x, y)

plt.title("Decision border", fontsize=14)

plt.show()

В областях, покрашенных в оранжевый, модель будет классифицировать точки как объекты из класса $0$. В синих — как объекты из класса $1$.

Обратите внимание на странные рваные области на рисунке. В этих областях из-за шума, присутствующего в данных, оказались объекты неправильного класса. Дерево переобучилось под обучающую выборку.

Что произойдет, если мы возьмем разные разбиения данных на обучение и тест для одного и того же датасета?

# first set of points

x_train1, x_test1, y_train1, y_test1 = train_test_split(x, y, random_state=1)

clf1 = DecisionTreeClassifier(max_depth=20, random_state=42)

clf1.fit(x_train1, y_train1)

# second set of points

x_train2, x_test2, y_train2, y_test2 = train_test_split(x, y, random_state=2)

clf2 = DecisionTreeClassifier(max_depth=20, random_state=42)

clf2.fit(x_train2, y_train2)

plt.figure(figsize=(16, 6))

plt.subplot(121)

plot_decision_boundary(clf1, x, y)

plt.title("Decision border 1", fontsize=14)

plt.subplot(122)

plot_decision_boundary(clf2, x, y)

plt.title("Decision border 2", fontsize=14)

plt.show()

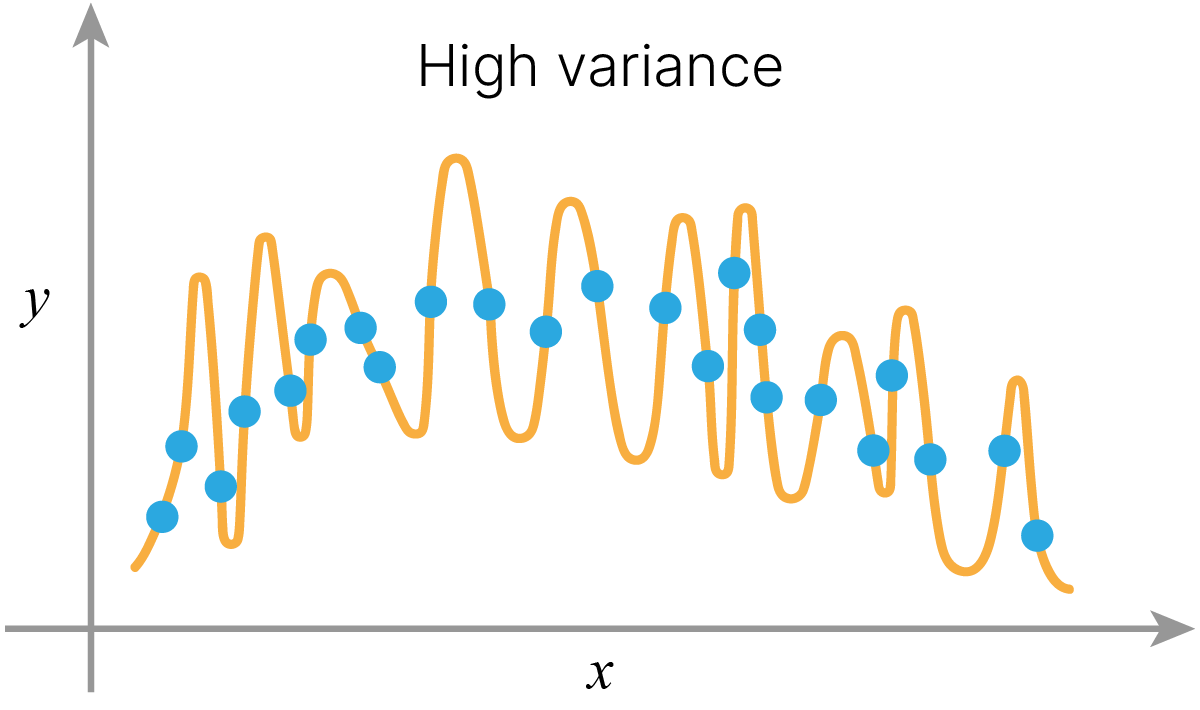

Границы решений поменялись. Исчезли одни "рваные" границы и появились другие. Наше дерево неустойчиво, из-за малейшего шума в данных оно может поменять свое предсказание. Оно переобучается на шум в данных.

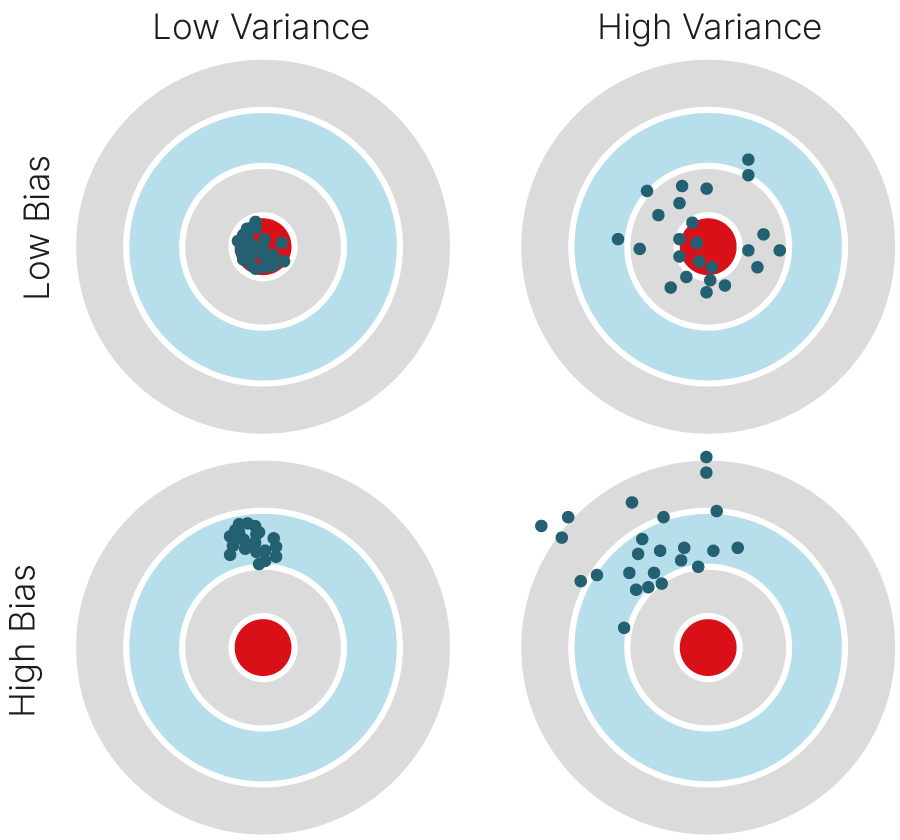

Говорят, что у нашего дерева высокий variance.

Можно ли что-то поправить?

У нас в настройках максимальная глубина дерева поставлена равной 20. Сделаем дерево глубины 1:

# first set of points

clf1 = DecisionTreeClassifier(max_depth=1, random_state=42)

clf1.fit(x_train1, y_train1)

# second set of points

clf2 = DecisionTreeClassifier(max_depth=1, random_state=42)

clf2.fit(x_train2, y_train2)

plt.figure(figsize=(16, 6))

plt.subplot(121)

plot_decision_boundary(clf1, x, y)

plt.title("Decision border 1", fontsize=14)

plt.subplot(122)

plot_decision_boundary(clf2, x, y)

plt.title("Decision border 2", fontsize=14)

plt.show()

Или глубины 2:

# first set of points

clf1 = DecisionTreeClassifier(max_depth=2, random_state=42)

clf1.fit(x_train1, y_train1)

# second set of points

clf2 = DecisionTreeClassifier(max_depth=2, random_state=42)

clf2.fit(x_train2, y_train2)

plt.figure(figsize=(16, 6))

plt.subplot(121)

plot_decision_boundary(clf1, x, y)

plt.title("Decision border 1", fontsize=14)

plt.subplot(122)

plot_decision_boundary(clf2, x, y)

plt.title("Decision border 2", fontsize=14)

plt.show()

Теперь полученные границы решений (почти) совпадают. Но наше дерево не в состоянии (в обоих случаях) уловить закономерность в исходных данных. Если мы отложим только тренировочный датасет, то увидим следующее:

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=42)

clf1 = DecisionTreeClassifier(max_depth=2, random_state=42)

clf1.fit(x_train, y_train)

clf2 = DecisionTreeClassifier(max_depth=20, random_state=42)

clf2.fit(x_train, y_train)

plt.figure(figsize=(16, 6))

plt.subplot(121)

plot_decision_boundary(clf1, x_train, y_train)

plt.title("Decision border, depth=2, train only", fontsize=14)

plt.subplot(122)

plot_decision_boundary(clf2, x_train, y_train)

plt.title("Decision border, depth=20, train only", fontsize=14)

plt.show()

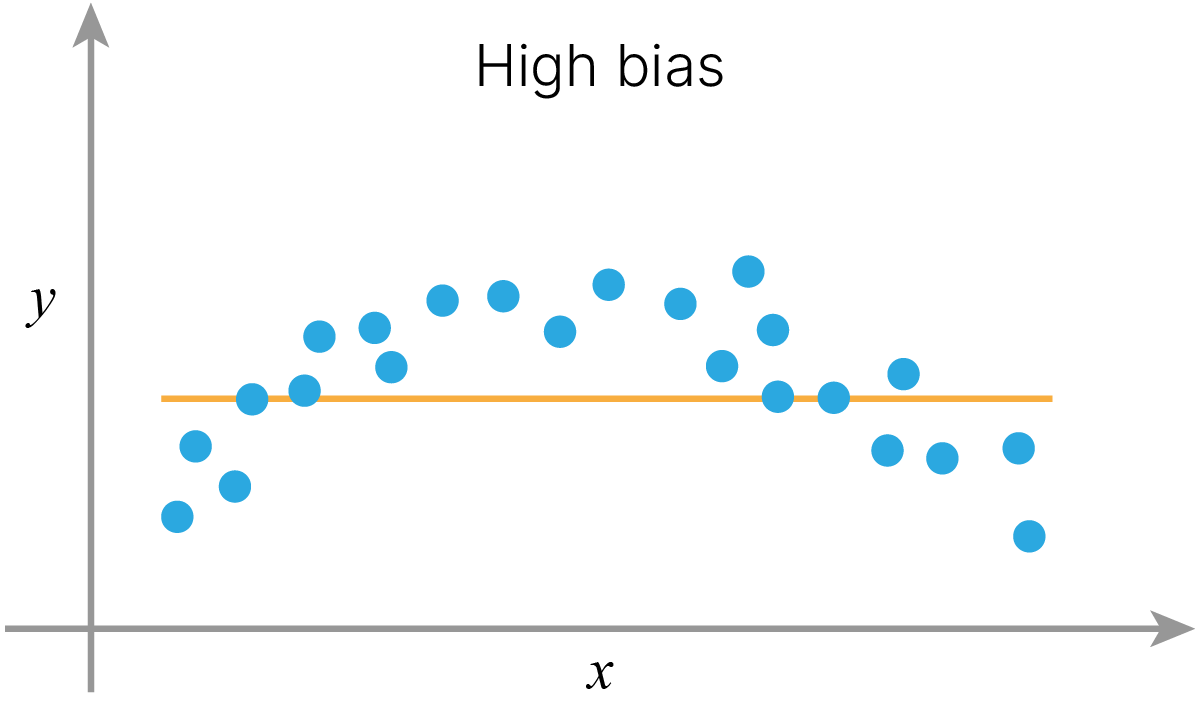

Мы видим, что в то время как дерево большой глубины выучило нашу тренировочную выборку почти идеально, дерево малой глубины для многих объектов из тренировочной выборки предсказывает не тот класс. Причем, оно не может исправиться просто в силу ограничения на глубину.

В случае дерева с малой глубиной нам не хватает сложности модели, чтобы уловить внутреннюю структуру данных. Говорят, что у нашей модели высокий bias.

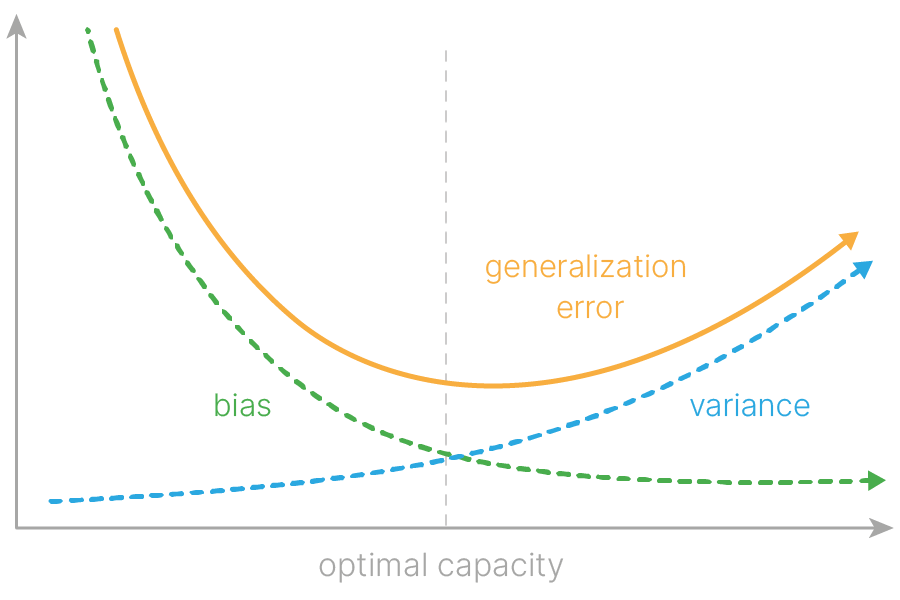

Можно показать, что ошибка любой модели раскладывается в сумму трех компонент:

$$ \large \text{Model error} = \text{Bias} + \text{Variance} + \text{Irreducible error} $$Обычно, высокий bias имеют модели, которые недостаточно сложны по сравнению с реальной закономерностью данных. Например, реальная зависимость, которую мы наблюдаем, нелинейная, а мы пытаемся аппроксимировать ее прямой линией. В этом случае наше решение заведомо смещено (biased) в сторону линейной модели, и мы будем систематически ошибаться в сравнении с реальной моделью данных.

Можно получить и обратную ситуацию. Если модель будет слишком сложная (в смысле своей выразительной способности) и "гибкая", то она сможет подстроиться под данные и выучить тренировочную выборку полностью. В этом случае модель будет подстраиваться под любой шум в данных и пытаться объяснить его какой-то сложной закономерностью.

Малое изменение в данных будет приводить к большим изменениям в прогнозе модели.

Иногда bias и variance представляют еще таким образом:

Если удачно подобрать модель и ее гиперпараметры, то гипотетически можно точно предсказать среднее значение ожидаемой величины, то есть получить и низкий $\text{Bias}$, и низкий $\text{Variance}$.

В реальности при измерении физической величины есть случайные непредсказуемые погрешности — отклонения от среднего. Из-за этого предсказания всегда будут иметь определенный уровень ошибки, ниже которого опуститься нельзя — это и есть $\text{Irreducible error}$.

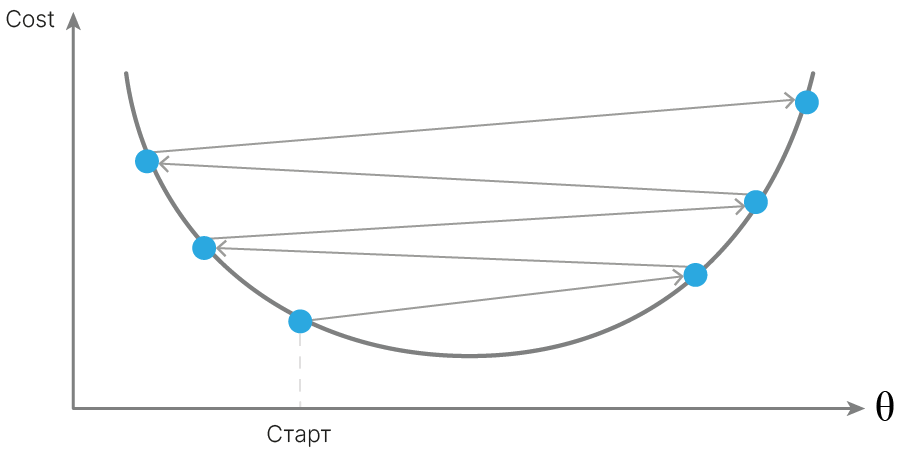

В практических задачах, когда невозможно подобрать реальную модель данных, не получается бесконечно уменьшать и Bias, и Variance — приходится искать компромисс (bias-variance tradeoff). С какого-то момента при уменьшении Bias начнет увеличиваться Variance, и наоборот. Задача исследователя — найти точку оптимума.

Можно построить зависимость этих величин от сложности модели (capacity). По мере увеличения сложности Variance имеет тенденцию к возрастанию, а Bias — к убыванию. Более сложные модели подстраиваются под случайные шумы обучающей выборки, а более простые — не могут воспроизвести реальные закономерности.

Управлять эффектом variance и bias можно как с помощью выбора модели, так и с помощью выбора гиперпараметров модели.

Продемонстрируем источники компонент Bias и Variance на примере регрессии зашумленной косинусоиды методом k-NN. Создадим функцию для генерации небольшой обучающей выборки и отобразим ее на графике

np.random.seed(42)

num_points = 300

num_grid = 500

x_max = 3.14

plt.figure(figsize=(10, 6))

def get_sample(num_points, x_max, std=0.3, x_sample=None):

if x_sample is None:

x_sample = (np.random.rand(num_points) - 0.5) * 2 * x_max

y_sample = np.cos(x_sample.flatten()) + np.random.randn(x_sample.shape[0]) * std

return x_sample.reshape(-1, 1), y_sample

x_grid = np.linspace(-x_max, x_max, num_grid).reshape(-1, 1)

x_sample, y_sample = get_sample(num_points=num_points, x_max=x_max)

_, y_true = get_sample(num_points=num_points, x_max=x_max, std=0, x_sample=x_grid)

plt.scatter(x_sample, y_sample, c="#bea6ff", label="Noise")

plt.plot(x_grid, y_true, "b--", linewidth=4, label="Real func")

plt.xlabel("X")

plt.ylabel("Y")

plt.legend()

plt.show()

Обучим одну и ту же модель с параметром количества соседей $1$ на разных выборках. Сравним предсказания моделей друг с другом и с реальной целевой функцией.

from sklearn.neighbors import KNeighborsRegressor

np.random.seed(42)

num_points = 30

num_models = 3

plt.figure(figsize=(24, 6))

model = KNeighborsRegressor(n_neighbors=1)

y_pred = np.zeros((num_models, num_grid))

sample_color = ["#00E134", "#FF9100", "#FF00B3"]

for model_num in range(num_models):

x_sample, y_sample = get_sample(num_points=num_points, x_max=x_max)

model.fit(x_sample, y_sample)

y_pred[model_num] = model.predict(x_grid)

_, y_true = get_sample(num_points=num_points, x_max=x_max, std=0, x_sample=x_grid)

plt.subplot(1, 3, model_num + 1)

plt.scatter(

x_sample, y_sample, c=sample_color[model_num], label=f"sample {model_num+1}"

)

plt.plot(

x_grid,

y_pred[model_num],

c=sample_color[model_num],

alpha=0.8,

label=f"model trained on sample {model_num+1}",

)

plt.plot(x_grid, y_true, "b--", linewidth=4, label="real mean")

plt.xlabel("X")

plt.ylabel("Y")

plt.ylim(-1.5, 1.8)

plt.legend(loc="lower center")

Предсказания моделей отличаются друг от друга и от истинной кривой средних значений косинуса.

Обучим 1000 моделей, для разного количества соседей ($1, 3, 25$) на разных подвыборках наших данных. Выберем одну тестовую точку и посмотрим, как предсказания моделей в этой точке зависят от гиперпараметра — количества соседей.

import matplotlib.gridspec as gridspec

num_models = 1000

for n_neighbors in [1, 3, 25]:

model = KNeighborsRegressor(n_neighbors=n_neighbors)

y_pred = np.zeros((num_models, num_grid))

plt.figure(figsize=(10, 4))

gs = gridspec.GridSpec(1, 2, width_ratios=[2, 1])

plt.subplot(gs[0])

for model_num in range(num_models):

x_sample, y_sample = get_sample(num_points=num_points, x_max=x_max)

model.fit(x_sample, y_sample)

y_pred[model_num] = model.predict(x_grid)

plt.plot(x_grid, y_pred[model_num], alpha=0.01, c="g", linewidth=5)

_, y_true = get_sample(num_points=num_points, x_max=x_max, std=0, x_sample=x_grid)

plt.plot(x_grid, y_true, c="b", linewidth=3, label="real mean")

plt.axvline(x=x_grid[num_grid // 2], c="r", linewidth=1, label="X text point")

plt.xlim((-x_max, x_max))

plt.ylim((-1, 2))

plt.xlabel("X")

plt.ylabel("Y")

plt.gca().set_title(f"{num_models} models: {n_neighbors} nearest neighbours")

plt.legend(loc="upper right")

plt.subplot(gs[1])

var = y_pred[:, num_grid // 2].var()

bias = np.abs(y_true[num_grid // 2] - y_pred[:, num_grid // 2].mean())

plt.hist(

y_pred[:, num_grid // 2],

bins=15,

color="g",

alpha=0.5,

orientation="horizontal",

label=f"predictions: \nvar = {var:.2f}\nbias = {bias:.2f}",

)

plt.axhline(y=y_true[num_grid // 2], c="b", linewidth=3, label="real mean")

plt.ylim((-1, 2))

plt.xlabel("hist counts")

plt.ylabel("Y")

plt.gca().set_title(f"predictions at test point")

plt.legend(loc="upper left")

plt.tight_layout()

plt.show()

По мере увеличения числа соседей:

Дерево малой глубины имеет малую сложность и высокий Bias.

Дерево большой глубины имеет высокую сложность и высокий Variance.

Можно подобрать для дерева идеальную capacity, когда Bias и Variance будут суммарно давать наименьший вклад в ошибку. Этим мы занимаемся при подборе параметров. Но есть и другие способы борьбы с Variance и/или Bias, которые мы разберем позже.

Заметим, что если бы мы могли не просто брать решение дерева, а привязывать к этому какую-то статистику, например, сколько деревьев, построенных по подобной процедуре, приняли такое же решение, то мы смогли бы получить более качественное решение.

Если наложить решающие границы 100 решающих деревьев, построенных на разных выборках из $x, y$, то мы увидим, что "хорошие области", соответствующие реальному разделению данных, будут общими между деревьями, а плохие — индивидуальны. К сожалению, в реальности мы не можем брать бесконечное число наборов данных из генеральной совокупности (представленной в данном случае $x, y$)

plt.figure(figsize=(8, 6))

for i in range(1, 101):

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=i)

clf = DecisionTreeClassifier(max_depth=20, random_state=0)

clf.fit(x_train, y_train)

plot_decision_boundary(clf, x, y, alpha=0.02, contour=False)

plt.show()

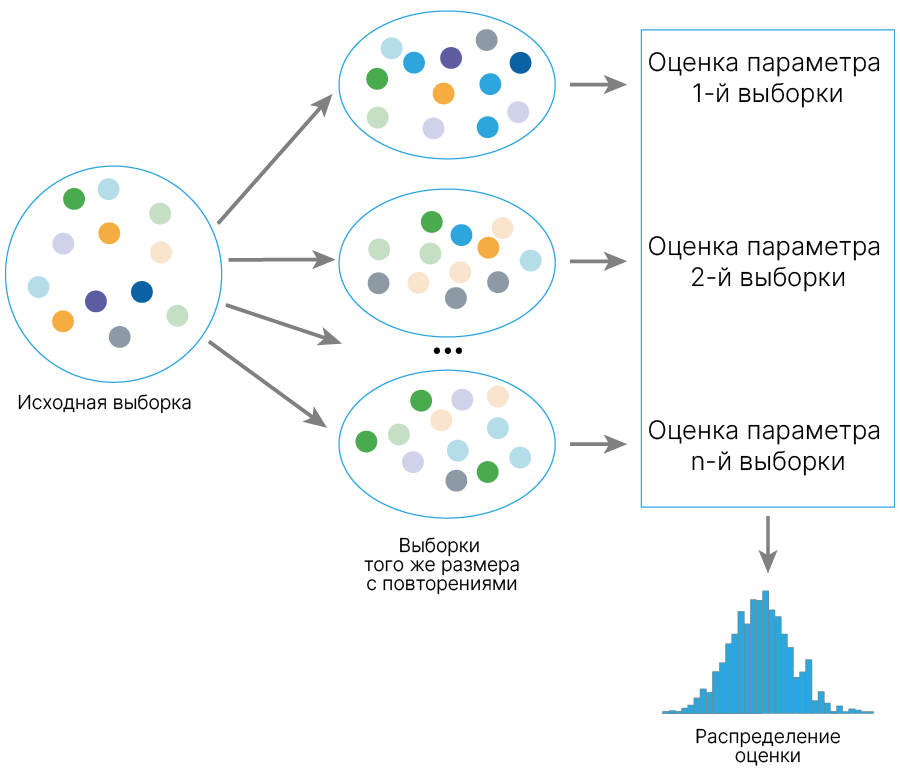

Мы хотим получить какое-то представление о точности нашей оценки: качества модели, корреляции между двумя переменными и т.д. И мы не знаем, как распределена характеристика, которую мы оцениваем.

Есть много подходов к тому, как получить такую оценку, и один из них — бутстрэп.

Что мы делаем:

Делаем из нашего исходного датасета N выборок такого же размера с повторениями.

Для каждой полученной выборки (обычно их называют псевдовыборками) считаем характеристику, для которой хотим получить оценку.

В результате такой процедуры получаем N значений характеристики. Строим гистограмму этих значений. Получаем примерное распределение нашей характеристики.

Можем построить 95% доверительный интервал для нашей характеристики. Для этого отрезаем 2.5% самых больших значений и самых малых.

Давайте попробуем сделать это на двух практических примерах.

Подробнее про бутстрэп 🎓[article].

Мы хотим сравнить поведение двух моделей на тестовом датасете. Допустим, нас интересует F1-score. Как нам это сделать?

Сгенерируем данные:

import numpy as np

size = 1500

y = np.random.choice([0, 1], size=size, replace=True)

print(f"shape y: {y.shape}")

print(f"First 10 values: {y[0:10]}")

shape y: (1500,) First 10 values: [1 0 0 0 1 1 0 1 1 1]

Напишем функцию, которая имитирует поведение модели, угадывающей правильный класс в $p$ процентах случаев:

def guess_model(y_real, p):

guessed = np.random.choice([True, False], size=size, replace=True, p=[p, 1 - p])

y_pred = np.zeros_like(y_real)

y_pred[guessed] = y_real[guessed]

y_pred[~guessed] = 1 - y_real[~guessed]

return y_pred

Пусть у нас две модели обладают одинаковым качеством, а третья — лучшим:

model1 = lambda y: guess_model(y, p=0.7)

model2 = lambda y: guess_model(y, p=0.7)

model3 = lambda y: guess_model(y, p=0.75)

np.random.seed(0)

y_pred1 = model1(y)

y_pred2 = model2(y)

y_pred3 = model3(y)

Первый вариант — просто посчитать F1-score каждой модели и проранжировать их в соответствии с F1-score:

from sklearn.metrics import f1_score

qual1 = f1_score(y_true=y, y_pred=y_pred1)

qual2 = f1_score(y_true=y, y_pred=y_pred2)

qual3 = f1_score(y_true=y, y_pred=y_pred3)

print(f" qual1: {qual1:.3f}\n qual2: {qual2:.3f}\n qual3: {qual3:.3f}")

qual1: 0.708 qual2: 0.691 qual3: 0.774

Нужная нам модель выбрана, но почему мы считаем различия между второй и третьей моделью значимыми, а между первой и второй — нет?

print(f"qual2 - qual1: {(qual2 - qual1):.3f}\nqual3 - qual2: {(qual3 - qual2):.3f}")

qual2 - qual1: -0.017 qual3 - qual2: 0.083

Такой способ (при помощи точечной оценки) может привести к ошибке, так как не дает нам судить о значимости отличий.

Существует много способов посчитать значимость данного отличия. Мы рассмотрим способ сравнения на основе bootstrap. Об остальных можете почитать в обзоре, приведенном в списке литературы.

Способ состоит в применении бутстрэпа к предсказаниям модели и реальным меткам.

def bootstrap_metric(x, y, metric_fn, samples_cnt=1000, random_state=42):

np.random.seed(random_state)

b_metric = np.zeros(samples_cnt)

for it in range(samples_cnt):

poses = np.random.choice(x.shape[0], size=x.shape[0], replace=True)

x_boot = x[poses]

y_boot = y[poses]

m_val = metric_fn(x_boot, y_boot)

b_metric[it] = m_val

return b_metric

Так мы сможем получить распределние нашей оценки:

import seaborn as sns

import matplotlib.pyplot as plt

boot_f1score_m1 = bootstrap_metric(

y, y_pred1, metric_fn=lambda x, y: f1_score(y_true=x, y_pred=y)

)

# plot histogram of the obtained values:

plt.figure(figsize=(10, 6))

sns.histplot(boot_f1score_m1)

plt.title("bootstrap f1 scores")

plt.show()

boot_f1score_m1 = bootstrap_metric(

y, y_pred1, metric_fn=lambda x, y: f1_score(y_true=x, y_pred=y)

)

boot_f1score_m2 = bootstrap_metric(

y, y_pred2, metric_fn=lambda x, y: f1_score(y_true=x, y_pred=y)

)

boot_f1score_m3 = bootstrap_metric(

y, y_pred3, metric_fn=lambda x, y: f1_score(y_true=x, y_pred=y)

)

Построим 90% доверительный интервал качества для каждой модели:

alpha = 0.10

print(

"F1 score for the 1st model: ",

np.quantile(boot_f1score_m1, q=[alpha / 2, 1 - alpha / 2]),

)

print(

"F1 score for the 2st model: ",

np.quantile(boot_f1score_m2, q=[alpha / 2, 1 - alpha / 2]),

)

print(

"F1 score for the 3st model: ",

np.quantile(boot_f1score_m3, q=[alpha / 2, 1 - alpha / 2]),

)

F1 score for the 1st model: [0.68614132 0.72807627] F1 score for the 2st model: [0.66925519 0.71175207] F1 score for the 3st model: [0.75284586 0.79355148]

Теперь мы видим, что доверительные интервалы для качества первой и второй модели практически одинаковы, в то время как доверительный интервал для качества третьей модели от них сильно отличается и не пересекается.

Можем построить боксплот (box-plot 📚[wiki]):

import pandas as pd

plt.figure(figsize=(16, 6))

sns.boxplot(

data=pd.DataFrame(

{

"model1": boot_f1score_m1,

"model2": boot_f1score_m2,

"model3": boot_f1score_m3,

}

)

)

plt.ylabel("f1 score", size=20)

plt.tick_params(axis="both", which="major", labelsize=14)

plt.show()

Мы могли бы использовать и тест Манна — Уитни 📚[wiki]:

from scipy.stats import mannwhitneyu

statistic_m1_m2, p_value_m1_m2 = mannwhitneyu(boot_f1score_m1, boot_f1score_m2)

statistic_m1_m3, p_value_m1_m3 = mannwhitneyu(boot_f1score_m1, boot_f1score_m3)

statistic_m2_m3, p_value_m2_m3 = mannwhitneyu(boot_f1score_m2, boot_f1score_m3)

# fmt: off

print(f"m1 and m2 Mann–Whitney statistic: {statistic_m1_m2:<10} p-value:{p_value_m1_m2}")

print(f"m1 and m3 Mann–Whitney statistic: {statistic_m1_m3:<10} p-value:{p_value_m1_m3}")

print(f"m2 and m3 Mann–Whitney statistic: {statistic_m2_m3:<10} p-value:{p_value_m2_m3}")

# fmt: on

m1 and m2 Mann–Whitney statistic: 819172.5 p-value:7.059998764073036e-135 m1 and m3 Mann–Whitney statistic: 51.0 p-value:0.0 m2 and m3 Mann–Whitney statistic: 2.0 p-value:0.0

Видим, что результат идентичен. В дальнейшем мы будем использовать только графки для оценки, но на практике полезно использовать несколько способов, чтобы избежать ошибочных суждений.

Рассмотрим на другом примере, используя данные о людях с наличием или отсутствием сердечных заболеваний. Загрузим датасет Heart Disease 🛠️[doc].

heart_dataset = pd.read_csv(

"https://edunet.kea.su/repo/EduNet-web_dependencies/datasets/heart.csv"

)

from sklearn.model_selection import train_test_split

x = heart_dataset.drop("target", axis=1)

y = heart_dataset["target"] > 0

x_train, x_test, y_train, y_test = train_test_split(x, y.values, random_state=42)

from sklearn.linear_model import LogisticRegression

from sklearn.svm import SVC

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import GridSearchCV

svc_model = GridSearchCV(

SVC(), {"kernel": ("linear", "rbf"), "C": [0.01, 0.1, 1, 10]}

).fit(x_train, y_train)

logr_model = GridSearchCV(

LogisticRegression(solver="liblinear", max_iter=100000),

{"penalty": ("l1", "l2"), "C": [0.01, 0.1, 1, 10, 100]},

).fit(x_train, y_train)

# few objects in the leaf - poor estimates of class probabilities - the model is overfitting

dt_model = GridSearchCV(

DecisionTreeClassifier(),

{"max_depth": [1, 3, 5, 7, 10], "min_samples_leaf": [1, 3, 5, 10]},

).fit(x_train, y_train)

from sklearn.metrics import average_precision_score # PR-AUC

y_pred1 = svc_model.decision_function(

x_test

) # by default, SVM gives score to each object instead of probabilities

y_pred2 = logr_model.predict_proba(x_test)[:, 1]

y_pred3 = dt_model.predict_proba(x_test)[:, 1]

qual1 = average_precision_score(y_true=y_test, y_score=y_pred1)

qual2 = average_precision_score(y_true=y_test, y_score=y_pred2)

qual3 = average_precision_score(y_true=y_test, y_score=y_pred3)

print(f"Logistic regression pr-auc: {qual1:.03f}")

print(f"SVC pr-auc: {qual2:.03f}")

print(f"DecisionTreeClassifier pr-auc: {qual3:.03f}")

Logistic regression pr-auc: 0.893 SVC pr-auc: 0.902 DecisionTreeClassifier pr-auc: 0.801

Теперь подсчитаем бутстрэп-оценки. Обратите внимание на то, что теперь мы передаем не предсказания, а вероятности.

boot_score_logreg = bootstrap_metric(

y_test, y_pred1, metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y)

)

boot_score_svc = bootstrap_metric(

y_test, y_pred2, metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y)

)

boot_score_dt = bootstrap_metric(

y_test, y_pred3, metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y)

)

alpha = 0.10

print(

"Logistic regression pr-auc 90%-ci: ",

np.quantile(boot_score_logreg, q=[alpha / 2, 1 - alpha / 2]),

)

print("SVC pr-auc 90%-ci:", np.quantile(boot_score_svc, q=[alpha / 2, 1 - alpha / 2]))

print(

"DecisionTreeClassifier pr-auc 90%-ci:",

np.quantile(boot_score_dt, q=[alpha / 2, 1 - alpha / 2]),

)

Logistic regression pr-auc 90%-ci: [0.80793003 0.97363727] SVC pr-auc 90%-ci: [0.8276533 0.97115084] DecisionTreeClassifier pr-auc 90%-ci: [0.70049707 0.90513571]

Видим, что качество SVC и логистической регрессии почти не отличается, а дерево решений уступает обеим моделям.

plt.figure(figsize=(16, 6))

sns.boxplot(

data=pd.DataFrame(

{"Log-reg": boot_score_logreg, "SVC": boot_score_svc, "DT": boot_score_dt}

)

)

plt.ylabel("PR-AUC", size=20)

plt.xlabel("Base models", size=20)

plt.tick_params(axis="both", which="major", labelsize=14)

plt.show()

Пусть у нас есть сигнал:

1110110011

Но при передаче на другое устройство в нем могут возникать ошибки:

1010111011

Самое простое решение возникшей проблемы:

1010111011

1110010011

11001101 11

1110110011

Напишем код, чтобы удостовериться в наших выводах.

import numpy as np

def get_signal(size, random_state=42):

signal = np.random.choice([0, 1], size, replace=True)

return signal

def compare_signs(sig1, sig2):

return (sig1 != sig2).sum()

def add_noise(sig, noise_p=0.20):

sig = sig.copy()

changed = np.random.choice(

[True, False], sig.shape[0], replace=True, p=[noise_p, 1 - noise_p]

)

sig[changed] = 1 - sig[changed]

return sig

def average_signals(sigs):

sig = np.mean(sigs, axis=0)

sig = np.round(sig, 0)

return sig

def send_signal(signal, tries):

passed_sigs = [add_noise(signal) for _ in range(tries)]

fin_signal = average_signals(passed_sigs)

return fin_signal

import matplotlib.pyplot as plt

np.random.seed(42)

repeats = 1000

signals_cnt_rng = range(1, 30, 2)

signal = get_signal(10)

mistakes = np.zeros((repeats, len(signals_cnt_rng)))

for j, sig_cnt in enumerate(signals_cnt_rng):

for i in range(repeats):

rec_sig = send_signal(signal, sig_cnt)

mistakes[i, j] = compare_signs(rec_sig, signal)

mn = mistakes.mean(axis=0)

sd = mistakes.std(axis=0)

plt.figure(figsize=(10, 5))

plt.title("Number of error in signal", fontsize=14)

plt.ylabel("Number of errors", fontsize=14)

plt.xlabel("Number of signals passed at once", fontsize=14)

plt.plot(signals_cnt_rng, mn)

plt.fill_between(signals_cnt_rng, mn - sd, mn + sd, facecolor="blue", alpha=0.1)

plt.show()

Оказывается, это имеет отношение к проблеме, с которой мы столкнулись с деревьями решений.

Постановка задачи:

Есть 10 объектов, в реальности все принадлежат классу 1

1111111111

Пусть у нас есть три независимых классификатора A, B и C. Каждый предсказывает 1 в 70% случаев.

Мы хотим получить общий классификатор на основании этих трех.

Мы хотим получить предсказание базовых классификаторов и применить к ним какую-то функцию, которая выдаст итоговый ответ. Вид этой функции задается заранее.

Будем просто усреднять предсказание наших классификаторов

$$\large h(x) = \dfrac 1 T \sum_{i=1}^{T}a_i(x) $$Простое голосование

Посчитаем вероятность того, что:

Таким образом, если брать большинство голосов, то мы будем в 78% случаев предсказывать верно. Мы взяли 3 классификатора, которые сами по себе были не очень хорошими, и получили классификатор лучшего качества. Если взять больше классификаторов, то ситуация будет еще лучше.

Пусть теперь у нас три классификатора, выдающие следующие предсказания

1111111100 — $80\%$ точность

1111111100 — $80\%$ точность

1</font>011111100 — $70\%$ точность

Если объединим предсказания, то получим:

1111111100 — $80\%$ точность

Потому что очень высокая зависимость предсказаний. Выше видно, что два классификатора предсказывают абсолютно одинаково. Вероятность, что они делают это случайно, очень мала.

А вот если возьмем такие классификаторы, то все получится:

1111111100 — $80\%$ точность

0111011101 — $70\%$ точность

1000101111 — $60\%$ точность

Усреднение:

1111111101 — $90\%$ точность

def get_predictions(y_real, p, cnt):

size = y_real.shape[0]

guessed = np.random.choice([True, False], (cnt, size), p=[p, 1 - p])

y = np.repeat(y_real.reshape(1, -1), cnt, axis=0)

y[~guessed] = 1 - y[~guessed]

return y

import pandas as pd

import seaborn as sns

size = 1000

reps = 10

cnt_base_predictors = [1] + list(range(5, 105, 5))

single_qual = [0.45, 0.5, 0.51, 0.55, 0.6, 0.75, 0.9]

dt = {"cnt": [], "single_qual": [], "accuracy": []}

for i in range(reps):

y_real = np.random.choice([0, 1], size)

for cnt in cnt_base_predictors:

for p in single_qual:

preds = get_predictions(y_real, p, cnt)

voting = np.round(preds.mean(axis=0))

accuracy = (y_real == voting).mean()

dt["cnt"].append(cnt)

dt["single_qual"].append(f"{p:.02}")

dt["accuracy"].append(accuracy)

results = pd.DataFrame(dt)

plt.figure(figsize=(16, 6))

sns.lineplot(data=results, x="cnt", y="accuracy", hue="single_qual", lw=3, alpha=0.5)

plt.xlabel("Number of base classifiers", size=20)

plt.ylabel("Accuracy", size=20)

plt.legend(loc="best", fontsize=12, title="Single classifier quality")

plt.show()

Видим, что:

Посмотрим, как зависит качество предсказания от коррелированности предсказателей. Конкретно — от ожидаемой коррелированности вероятностей ошибиться на данном объекте для любой взятой пары классификаторов из ансамбля.

import scipy

def get_correlated_predictions(y_real, p, cnt, r):

size = y_real.shape[0]

x1 = np.random.uniform(0, 1, size)

x2 = np.random.uniform(0, 1, (cnt, size))

q = np.sqrt(r)

y = q * x1 + (1 - q**2) ** 0.5 * x2 # y variables now correlated with correlation=r

y_mod = np.zeros_like(y)

for i in range(y.shape[0]):

y_mod[i] = scipy.stats.rankdata(y[i])

y = y_mod / size # back to uniform, slightly affects correlations

y_pred = np.repeat(y_real.reshape(1, -1), cnt, axis=0)

y_pred[y < 1 - p] = 1 - y_pred[y < 1 - p] # to predictions, affects correlations

return y_pred

np.random.seed(42)

x = np.arange(0, 1, 0.05)

accuracy = np.zeros_like(x)

p = 0.7

cnt = 100

for ind, r in enumerate(x):

preds = get_correlated_predictions(y_real, p, cnt, r)

voting = np.round(preds.mean(axis=0))

accuracy[ind] = (y_real == voting).mean()

plt.figure(figsize=(16, 6))

plt.title(f"Accuracy of {cnt} classifiers ensemble", size=20)

plt.xlabel("Correlation among classifiers", size=20)

plt.ylabel("Accuracy", size=20)

plt.axhline(y=p, color="red", lw=5, ls="--", label="Single classifier")

sns.lineplot(x=x, y=accuracy, lw=5, label="Ensemble")

plt.legend(fontsize=20)

plt.show()

Видим, что по мере увеличения коррелированности моделей качество все больше и больше приближается к качеству одной базовой модели.

Нам нужны классификаторы, которые сами по себе предсказывают лучше, чем случайные, при этом они должны быть не коррелированы. На самом деле это нетривиальная задача: откуда нам брать разные классификаторы, если у нас один датасет?

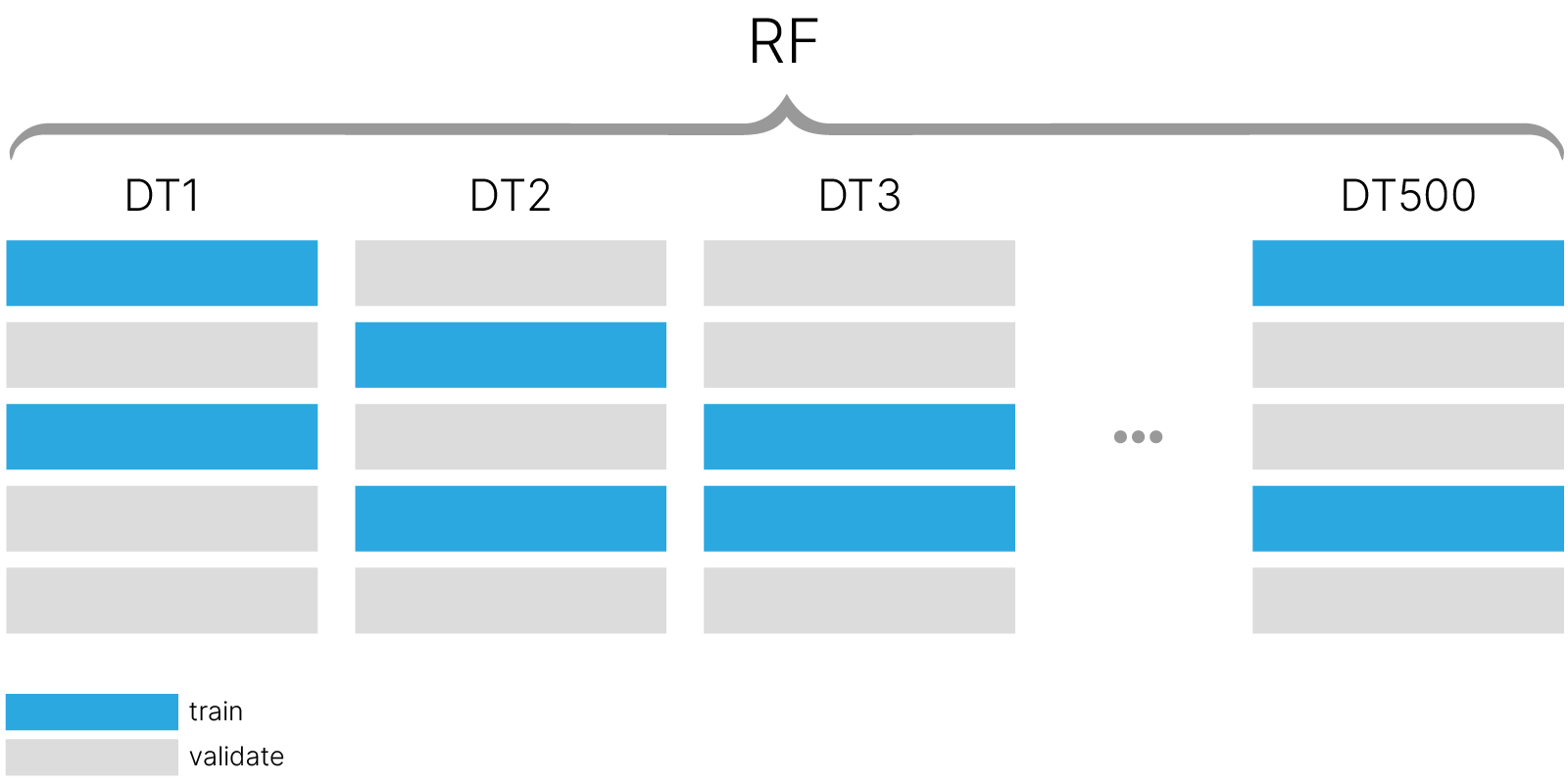

Первый вариант — нам поможет уже рассмотренный bootstrap:

Делаем из нашего исходного датасета N выборок такого же размера с повторениями.

На каждой псевдовыборке строим отдельную модель. Чтобы полученные модели были слабо зависимы, будем использовать алгоритм, который чувствителен к небольшим изменениям в выборке.

Получаем N слабо зависимых моделей.

Когда нам нужно сделать предсказание для нового объекта, делаем предсказание каждой из N моделей, а затем усредняем предсказание.

В sklearn для бэггинга можно использовать класс BaggingClassifier из sklearn.ensemble. Мы напишем свой код для бэггинга для большей наглядности происходящего.

import sklearn

def get_bootstrap_sample(x, y):

size = x.shape[0]

poses = np.random.choice(size, size=size, replace=True)

x_boot = x[poses]

y_boot = y[poses]

return x_boot, y_boot

class BaggingBinaryClassifierEnsemble:

def __init__(self, base_classifier, ensemble_size, random_state=42):

self.base_classifier = base_classifier

self.ensemble_size = ensemble_size

self.random_state = random_state

self.ensemble = []

def fit(self, x, y):

np.random.seed(self.random_state)

for est_id in range(self.ensemble_size):

x_boot, y_boot = get_bootstrap_sample(x, y)

model = sklearn.clone(self.base_classifier) # create new base model

model.fit(x_boot, y_boot)

self.ensemble.append(model)

def predict_proba(self, x):

if not self.ensemble:

raise Exception("Unfitted model")

y_pred = 0

for est in self.ensemble:

y_pred += est.predict(x)

y_pred = y_pred / self.ensemble_size

return y_pred

def predict(self, x):

y_proba = self.predict_proba(x)

y_pred = np.round(y_proba)

return y_pred

Для простоты здесь и далее будем использовать параметры моделей, подобранные ранее, когда мы использовали их вне ансамбля. В данном случае это не имеет значения, но в случае разбираемых далее случайного леса и градиентного бустинга параметры подбирают вместе с построением ансамбля.

heart_dataset = pd.read_csv(

"https://edunet.kea.su/repo/EduNet-web_dependencies/datasets/heart.csv"

)

from sklearn.model_selection import train_test_split

x = heart_dataset.drop("target", axis=1)

y = heart_dataset["target"] > 0

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=42)

from sklearn.svm import SVC

from sklearn.linear_model import LogisticRegression

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import GridSearchCV

svc_model = GridSearchCV(

SVC(), {"kernel": ("linear", "rbf"), "C": [0.01, 0.1, 1, 10]}

).fit(x_train, y_train)

logr_model = GridSearchCV(

LogisticRegression(solver="liblinear", max_iter=100000),

{"penalty": ("l1", "l2"), "C": [0.01, 0.1, 1, 10, 100]},

).fit(x_train, y_train)

# few objects in the leaf - poor estimates of class probabilities - the model is overtraining

dt_model = GridSearchCV(

DecisionTreeClassifier(),

{"max_depth": [1, 3, 5, 7, 10], "min_samples_leaf": [1, 3, 5, 10]},

).fit(x_train, y_train)

Опробуем модель:

bagging_dt = BaggingBinaryClassifierEnsemble(

dt_model.best_estimator_, ensemble_size=100

)

bagging_logreg = BaggingBinaryClassifierEnsemble(

logr_model.best_estimator_, ensemble_size=100

)

bagging_svc = BaggingBinaryClassifierEnsemble(

svc_model.best_estimator_, ensemble_size=100

)

bagging_dt.fit(x_train.values, y_train.values)

bagging_logreg.fit(x_train.values, y_train.values)

bagging_svc.fit(x_train.values, y_train.values)

y_pred_blr = bagging_logreg.predict_proba(x_test.values)

y_pred_bsvc = bagging_svc.predict_proba(x_test.values)

y_pred_bdt = bagging_dt.predict_proba(x_test.values)

from sklearn.metrics import average_precision_score # PR-AUC

qual_blr = average_precision_score(y_true=y_test, y_score=y_pred_blr)

qual_bsvc = average_precision_score(y_true=y_test, y_score=y_pred_bsvc)

qual_bdt = average_precision_score(y_true=y_test, y_score=y_pred_bdt)

print(f"Bagged Logistic regression pr-auc: {qual_blr:.03f}")

print(f"Bagged SVC pr-auc: {qual_bsvc :.03f}")

print(f"Bagged DecisionTreeClassifier pr-auc: {qual_bdt:.03f}")

Bagged Logistic regression pr-auc: 0.872 Bagged SVC pr-auc: 0.900 Bagged DecisionTreeClassifier pr-auc: 0.898

def bootstrap_metric(x, y, metric_fn, samples_cnt=1000, alpha=0.05, random_state=42):

size = len(x)

np.random.seed(random_state)

b_metric = np.zeros(samples_cnt)

for it in range(samples_cnt):

poses = np.random.choice(x.shape[0], size=x.shape[0], replace=True)

x_boot = x[poses]

y_boot = y[poses]

m_val = metric_fn(x_boot, y_boot)

b_metric[it] = m_val

return b_metric

boot_score_blogreg = bootstrap_metric(

y_test.values,

y_pred_blr,

metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y),

)

boot_score_bsvc = bootstrap_metric(

y_test.values,

y_pred_bsvc,

metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y),

)

boot_score_bdt = bootstrap_metric(

y_test.values,

y_pred_bdt,

metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y),

)

alpha = 0.10

print(

"Bagged Logistic regression pr-auc 90%-ci: ",

np.quantile(boot_score_blogreg, q=[alpha / 2, 1 - alpha / 2]),

)

print(

"Bagged SVC pr-auc 90%-ci:",

np.quantile(boot_score_bsvc, q=[alpha / 2, 1 - alpha / 2]),

)

print(

"Bagged DecisionTreeClassifier pr-auc 90%-ci:",

np.quantile(boot_score_bdt, q=[alpha / 2, 1 - alpha / 2]),

)

Bagged Logistic regression pr-auc 90%-ci: [0.78262498 0.95069418] Bagged SVC pr-auc 90%-ci: [0.81964811 0.9761168 ] Bagged DecisionTreeClassifier pr-auc 90%-ci: [0.83053272 0.95963424]

y_pred1 = svc_model.decision_function(

x_test

) # by default, SVM gives score to each object instead of probabilities

y_pred2 = logr_model.predict_proba(x_test)[:, 1]

y_pred3 = dt_model.predict_proba(x_test)[:, 1]

qual1 = average_precision_score(y_true=y_test, y_score=y_pred1)

qual2 = average_precision_score(y_true=y_test, y_score=y_pred2)

qual3 = average_precision_score(y_true=y_test, y_score=y_pred3)

boot_score_logreg = bootstrap_metric(

y_test.values,

y_pred1,

metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y),

)

boot_score_svc = bootstrap_metric(

y_test.values,

y_pred2,

metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y),

)

boot_score_dt = bootstrap_metric(

y_test.values,

y_pred3,

metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y),

)

plt.figure(figsize=(11, 6))

result_arrays = [

boot_score_logreg,

boot_score_svc,

boot_score_dt,

boot_score_blogreg,

boot_score_bsvc,

boot_score_bdt,

]

base_models = ["Log-Reg", "SVC", "DT"] * 2

ensemble_types = ["Single"] * 3 + ["Bagged"] * 3

dfs = []

for i, res in enumerate(result_arrays):

df = pd.DataFrame(res, columns=["pr_auc"])

df["base_model"] = base_models[i]

df["ensemble_method"] = ensemble_types[i]

dfs.append(df)

sns.boxplot(data=pd.concat(dfs), y="pr_auc", x="base_model", hue="ensemble_method")

plt.xlabel("Base models", size=20)

plt.ylabel("PR-AUC", size=20)

plt.legend(fontsize=20)

plt.tick_params(axis="both", which="major", labelsize=14)

plt.show()

Дереву решений — при ансамблировании удается получить качество не хуже других базовых моделей.

from sklearn import datasets

x, y = sklearn.datasets.make_moons(n_samples=500, noise=0.30, random_state=42)

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=42)

from matplotlib.colors import ListedColormap

def plot_decision_boundary(

clf, x, y, axes=[-1.5, 2.5, -1, 1.5], alpha=0.85, contour=True, bolded=False

):

x1s = np.linspace(axes[0], axes[1], 100)

x2s = np.linspace(axes[2], axes[3], 100)

x1, x2 = np.meshgrid(x1s, x2s)

x_new = np.c_[x1.ravel(), x2.ravel()]

y_pred = clf.predict(x_new).reshape(x1.shape)

custom_cmap = ListedColormap(["#FEE7D0", "#bea6ff", "#B8E1EC"])

plt.contourf(x1, x2, y_pred, alpha=0.3, cmap=custom_cmap)

if contour:

custom_cmap2 = ListedColormap(["#FEE7D0", "#5D5DA6", "#B8E1EC"])

if bolded:

custom_cmap2 = ListedColormap(["#FEE7D0", "#5D5DA6", "#000000"])

plt.contour(x1, x2, y_pred, cmap=custom_cmap2)

plt.plot(x[:, 0][y == 0], x[:, 1][y == 0], "D", c="#F9B041", alpha=alpha)

plt.plot(x[:, 0][y == 1], x[:, 1][y == 1], "o", c="#2DA9E1", alpha=alpha)

plt.axis(axes)

plt.xlabel(r"$x_1$", fontsize=18)

plt.ylabel(r"$x_2$", fontsize=18, rotation=0)

plt.figure(figsize=(16, 6))

plt.subplot(121)

clf = DecisionTreeClassifier(max_depth=10, random_state=42)

clf.fit(x_train, y_train)

plot_decision_boundary(clf, x, y)

plt.title("Single Decision Tree", fontsize=14)

plt.subplot(122)

bagging_dt = BaggingBinaryClassifierEnsemble(

DecisionTreeClassifier(max_depth=10), ensemble_size=100

)

bagging_dt.fit(x_train, y_train)

plot_decision_boundary(bagging_dt, x, y)

plt.title("Bagged Decision Tree", fontsize=14)

plt.show()

Видим, что разделяющая плоскость для дерева более гладкая и лучше отражает реальное разделение классов.

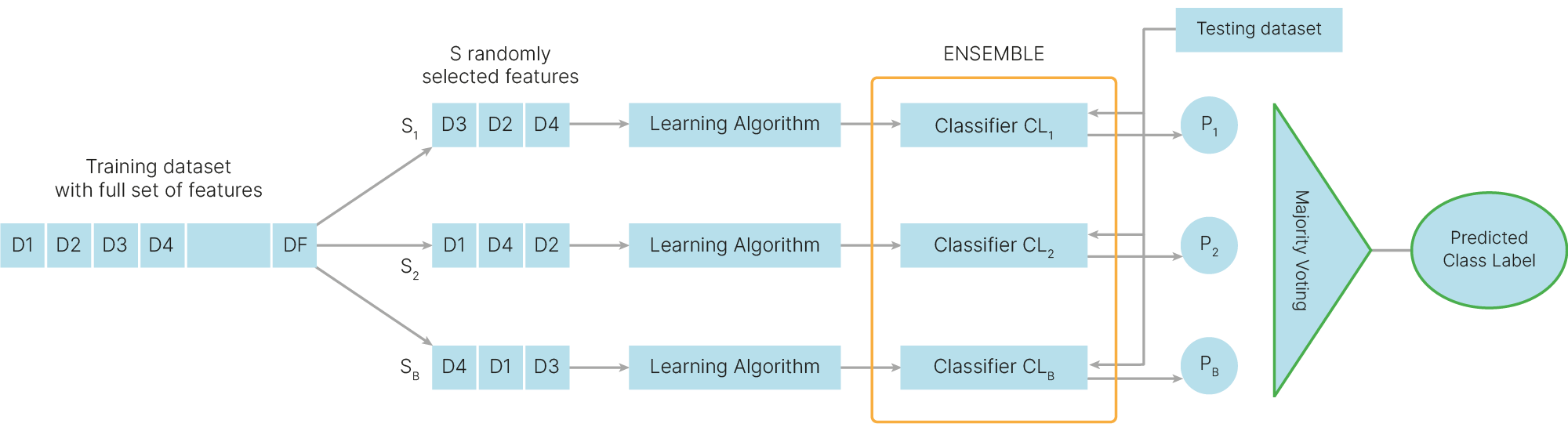

Второй вариант получения псевдовыборок — сэмплировать не объекты, а признаки. При этом бесполезно иметь в выборке два одинаковых признака, так как потом мы делаем выборки меньшего размера, чем исходное число признаков и без повторений.

Обычно для каждой модели выбирают:

для задач классификации:

$$\sqrt{\text{feature_cnt}}$$

для задач регрессии:

$$ \frac {\text{feature_cnt}} {3}$$

Хотя строгих правил нет, этот параметр можно подбирать на кросс-валидации.

Напишем метод случайных подпространств сами:

def get_rsm_sample(x, y, f_num=None):

size = x.shape[1]

f_num = f_num or int(np.sqrt(size)) + 1

f_num = min(size, f_num)

f_poses = np.random.choice(size, size=f_num, replace=False)

x_rsm = x[:, f_poses]

y_rsm = y.copy()

return x_rsm, y_rsm, f_poses

class RSMBinaryClassifierEnsemble:

def __init__(

self, base_classifier, ensemble_size, random_state=42, max_features=None

):

self.base_classifier = base_classifier

self.ensemble_size = ensemble_size

self.random_state = random_state

self.max_features = max_features

self.ensemble = []

self.feature_poses = []

# we had to keep track of features selected. In sklearn Random Forest, discussed below,

# another, more stable implementation is used.

# they use `f_num` random features but in case no good split found, they try other features too.

def fit(self, x, y):

np.random.seed(self.random_state)

for est_id in range(self.ensemble_size):

x_boot, y_boot, f_poses = get_rsm_sample(x, y, f_num=self.max_features)

self.feature_poses.append(f_poses)

model = sklearn.clone(self.base_classifier) # create new base model

model.fit(x_boot, y_boot)

self.ensemble.append(model)

def predict_proba(self, x):

if not self.ensemble:

raise Exception("Unfitted model")

y_pred = 0

for ind, est in enumerate(self.ensemble):

y_pred += est.predict(x[:, self.feature_poses[ind]])

y_pred = y_pred / self.ensemble_size

return y_pred

def predict(self, x):

y_proba = self.predict_proba(x)

y_pred = np.round(y_proba)

return y_pred

x = heart_dataset.drop("target", axis=1)

y = heart_dataset["target"] > 0

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=42)

rsm_dt = RSMBinaryClassifierEnsemble(dt_model.best_estimator_, ensemble_size=100)

rsm_logreg = RSMBinaryClassifierEnsemble(logr_model.best_estimator_, ensemble_size=100)

rsm_svc = RSMBinaryClassifierEnsemble(svc_model.best_estimator_, ensemble_size=100)

rsm_dt.fit(x_train.values, y_train.values)

rsm_logreg.fit(x_train.values, y_train.values)

rsm_svc.fit(x_train.values, y_train.values)

y_pred_rlr = rsm_logreg.predict_proba(x_test.values)

y_pred_rsvc = rsm_svc.predict_proba(x_test.values)

y_pred_rdt = rsm_dt.predict_proba(x_test.values)

boot_score_rlogreg = bootstrap_metric(

y_test.values,

y_pred_rlr,

metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y),

)

boot_score_rsvc = bootstrap_metric(

y_test.values,

y_pred_rsvc,

metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y),

)

boot_score_rdt = bootstrap_metric(

y_test.values,

y_pred_rdt,

metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y),

)

alpha = 0.10

print(

"RSM Logistic regression pr-auc 90%-ci: ",

np.quantile(boot_score_blogreg, q=[alpha / 2, 1 - alpha / 2]),

)

print(

"RSM SVC pr-auc 90%-ci:", np.quantile(boot_score_bsvc, q=[alpha / 2, 1 - alpha / 2])

)

print(

"RSM DecisionTreeClassifier pr-auc 90%-ci:",

np.quantile(boot_score_bdt, q=[alpha / 2, 1 - alpha / 2]),

)

RSM Logistic regression pr-auc 90%-ci: [0.78262498 0.95069418] RSM SVC pr-auc 90%-ci: [0.81964811 0.9761168 ] RSM DecisionTreeClassifier pr-auc 90%-ci: [0.83053272 0.95963424]

plt.figure(figsize=(14, 6))

result_arrays = [

boot_score_logreg,

boot_score_svc,

boot_score_dt,

boot_score_blogreg,

boot_score_bsvc,

boot_score_bdt,

boot_score_rlogreg,

boot_score_rsvc,

boot_score_rdt,

]

base_models = ["Log-Reg", "SVC", "DT"] * 3

ensemble_types = ["Single"] * 3 + ["Bagged"] * 3 + ["RSM"] * 3

dfs = []

for i, res in enumerate(result_arrays):

df = pd.DataFrame(res, columns=["pr_auc"])

df["base_model"] = base_models[i]

df["ensemble_method"] = ensemble_types[i]

dfs.append(df)

sns.boxplot(data=pd.concat(dfs), y="pr_auc", x="base_model", hue="ensemble_method")

plt.xlabel("Base model", size=20)

plt.ylabel("PR-AUC", size=20)

plt.legend(fontsize=20)

plt.tick_params(axis="both", which="major", labelsize=14)

plt.show()

RSM значительно помогает только дереву решений. Остальные методы почти не улучшают своего качества.

Можно объединить оба способа: применяем bootstrap к объектам (получается выборка одного размера, но с повторяющимися объектами, а каких-то объектов не будет), и, кроме этого, выкидываем часть признаков. В этом случае мы получим еще более сильно отличающиеся друг от друга случайные выборки.

sklearn.ensemble.BaggingClassifier и sklearn.ensemble.BaggingRegressor вопреки названию могут поддерживать оба способа.

Теперь будем использовать BaggingClassier из стандартной библиотеки:

from sklearn.ensemble import BaggingClassifier

models = {}

logr_model = GridSearchCV(

LogisticRegression(solver="liblinear", max_iter=100000),

{"penalty": ("l1", "l2"), "C": [0.01, 0.1, 1, 10, 100]},

).fit(x_train, y_train)

models["LogReg"] = logr_model

svc_model = GridSearchCV(

SVC(), {"kernel": ("linear", "rbf"), "C": [0.01, 0.1, 1, 10]}

).fit(x_train, y_train)

models["SVC"] = svc_model

# few objects in the leaf - poor estimates of class probabilities - the model is overtraining

dt_model = GridSearchCV(

DecisionTreeClassifier(),

{"max_depth": [1, 3, 5, 7, 10], "min_samples_leaf": [1, 3, 5, 10]},

).fit(x_train, y_train)

models["DT"] = dt_model

bagging_logr = BaggingClassifier(

logr_model.best_estimator_, n_estimators=100, random_state=42

)

models["Bagging LogReg"] = bagging_logr

bagging_svc = BaggingClassifier(

svc_model.best_estimator_, n_estimators=100, random_state=42

)

models["Bagging SVC"] = bagging_svc

bagging_dt = BaggingClassifier(

dt_model.best_estimator_, n_estimators=100, random_state=42

)

models["Bagging DT"] = bagging_dt

sqrt_features = int(np.sqrt(x.shape[1])) + 1

rsm_logreg = BaggingClassifier(

logr_model.best_estimator_,

n_estimators=100,

bootstrap=False,

max_features=sqrt_features,

random_state=42,

)

models["RSM LogReg"] = rsm_logreg

rsm_svc = BaggingClassifier(

svc_model.best_estimator_,

n_estimators=100,

bootstrap=False,

max_features=sqrt_features,

random_state=42,

)

models["RSM SVC"] = rsm_svc

rsm_dt = BaggingClassifier(

dt_model.best_estimator_,

n_estimators=100,

bootstrap=False,

max_features=sqrt_features,

random_state=42,

)

models["RSM DT"] = rsm_dt

# Both Bagging and RSM

bag_rsm_logreg = BaggingClassifier(

logr_model.best_estimator_,

n_estimators=100,

bootstrap=True,

max_features=sqrt_features,

random_state=42,

)

models["BagRSM LogReg"] = bag_rsm_logreg

bag_rsm_svc = BaggingClassifier(

svc_model.best_estimator_,

n_estimators=100,

bootstrap=True,

max_features=sqrt_features,

random_state=42,

)

models["BagRSM SVC"] = bag_rsm_svc

bag_rsm_dt = BaggingClassifier(

dt_model.best_estimator_,

n_estimators=100,

bootstrap=True,

max_features=sqrt_features,

random_state=42,

)

models["BagRSM DT"] = bag_rsm_dt

for name, model in models.items():

model.fit(x_train, y_train)

predictions = {}

for name, model in models.items():

if name != "SVC":

y_pred = model.predict_proba(x_test)[:, 1]

else:

y_pred = model.decision_function(x_test)

predictions[name] = y_pred

boot_scores = {}

for name, y_pred in predictions.items():

boot_score = bootstrap_metric(

y_test.values,

y_pred,

metric_fn=lambda x, y: average_precision_score(y_true=x, y_score=y),

)

boot_scores[name] = boot_score

plt.figure(figsize=(16, 6))

base_models = ["Log-Reg", "SVC", "DT"] * 4

ensemble_types = ["Single"] * 3 + ["Bagged"] * 3 + ["RSM"] * 3 + ["BagRSM"] * 3

dfs = []

for i, model_name in enumerate(boot_scores):

df = pd.DataFrame(boot_scores[model_name], columns=["pr_auc"])

df["base_model"] = base_models[i]

df["ensemble_method"] = ensemble_types[i]

dfs.append(df)

sns.boxplot(data=pd.concat(dfs), y="pr_auc", x="base_model", hue="ensemble_method")

plt.xlabel("Base model", size=20)

plt.ylabel("PR-AUC", size=20)

plt.legend(fontsize=20, loc="lower right")

plt.tick_params(axis="both", which="major", labelsize=14)

plt.show()

Существенное улучшение качества наблюдается только при использовании решающего дерева в качестве базовой модели.

Чтобы простое голосование повышало качество ансамбля, необходимо, чтобы ошибки базовых моделей не коррелировали между собой.

Попробуем оценить попарную корреляцию в ошибках базовых моделей в ансамблях.

import itertools

def base_model_pair_correlation(ensemble, x):

corrs = []

for (i, est1), (j, est2) in itertools.combinations(

enumerate(ensemble.estimators_), 2

):

xi_test = x.values[:, ensemble.estimators_features_[i]]

xj_test = x.values[:, ensemble.estimators_features_[j]]

if not isinstance(est1, sklearn.svm.SVC):

y_pred_t1 = est1.predict_proba(xi_test)[:, 1]

y_pred_t2 = est2.predict_proba(xj_test)[:, 1]

else:

y_pred_t1 = est1.decision_function(xi_test)

xj_test = x_test.values[:, ensemble.estimators_features_[j]]

y_pred_t2 = est2.decision_function(xj_test)

corrs.append(scipy.stats.pearsonr(y_pred_t1, y_pred_t2)[0])

return np.array(corrs)

pair_correlations = {}

for name, model in models.items():

if not "Bagging" in name and not "RSM" in name:

continue

pair_correlations[name] = base_model_pair_correlation(model, x_test)

cor_res = pd.DataFrame(pair_correlations)

cor_res = cor_res.melt(

value_vars=cor_res.columns, value_name="paircor", var_name="model"

)

# get base models and ensembling methods from names

def read_base(s):

if "dt" in s.lower():

return "DT"

elif "svc" in s.lower():

return "SVC"

else:

return "Log-Reg"

def read_ensemble(s):

bag, rsm = False, False

if "bag" in s.lower():

bag = True

if "rsm" in s.lower():

rsm = True

if bag and rsm:

return "BagRSM"

if bag:

return "Bagged"

if rsm:

return "RSM"

return "Single"

cor_res["base_model"] = cor_res["model"].apply(read_base)

cor_res["ensemble_method"] = cor_res["model"].apply(read_ensemble)

Кроме того, посчитаем качество базовых моделей, входящих в каждый из ансамблей.

def base_model_prauc(ensemble, x, y):

qual = np.zeros(ensemble.n_estimators)

for ind, est in enumerate(ensemble.estimators_):

x_test = x.values[:, ensemble.estimators_features_[i]]

if not isinstance(est, sklearn.svm.SVC):

y_pred = est.predict_proba(x_test)[:, 1]

else:

y_pred = est.decision_function(x_test)

qual[ind] = average_precision_score(y_score=y_pred, y_true=y)

return qual

base_prauc = {}

for name, model in models.items():

if not "Bagging" in name and not "RSM" in name:

continue

base_prauc[name] = base_model_prauc(model, x_test, y_test)

base_prauc_res = pd.DataFrame(base_prauc)

base_prauc_res = base_prauc_res.melt(

value_vars=base_prauc_res.columns, value_name="pr_auc", var_name="model"

)

base_prauc_res["base_model"] = base_prauc_res["model"].apply(read_base)

base_prauc_res["ensemble_method"] = base_prauc_res["model"].apply(read_ensemble)

plt.figure(figsize=(16, 12))

plt.subplot(211)

sns.boxplot(data=cor_res, y="paircor", x="base_model", hue="ensemble_method")

plt.title("Pairwise correlations in ensembles", size=25)

plt.xlabel("", size=20)

plt.ylabel("Pairwise correlation", size=20)

plt.legend(fontsize=20, loc="lower left")

plt.tick_params(axis="both", which="major", labelsize=14)

plt.subplot(212)

sns.boxplot(data=base_prauc_res, y="pr_auc", x="base_model", hue="ensemble_method")

plt.title("Base model quality", size=25)

plt.xlabel("", size=20)

plt.ylabel("PR-AUC", size=20)

plt.subplots_adjust()

plt.legend(fontsize=20, loc="lower left")

plt.tick_params(axis="both", which="major", labelsize=14)

plt.show()

Можно сделать следующие выводы:

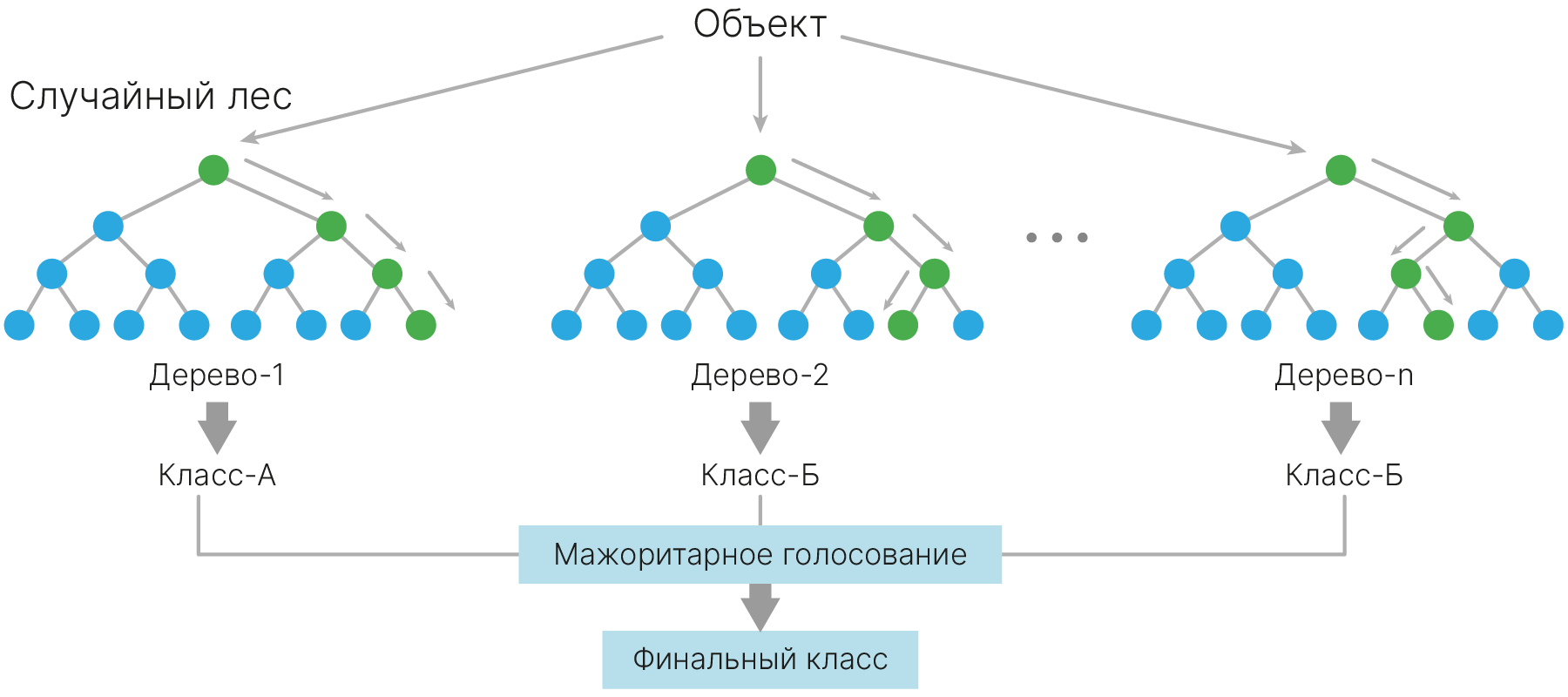

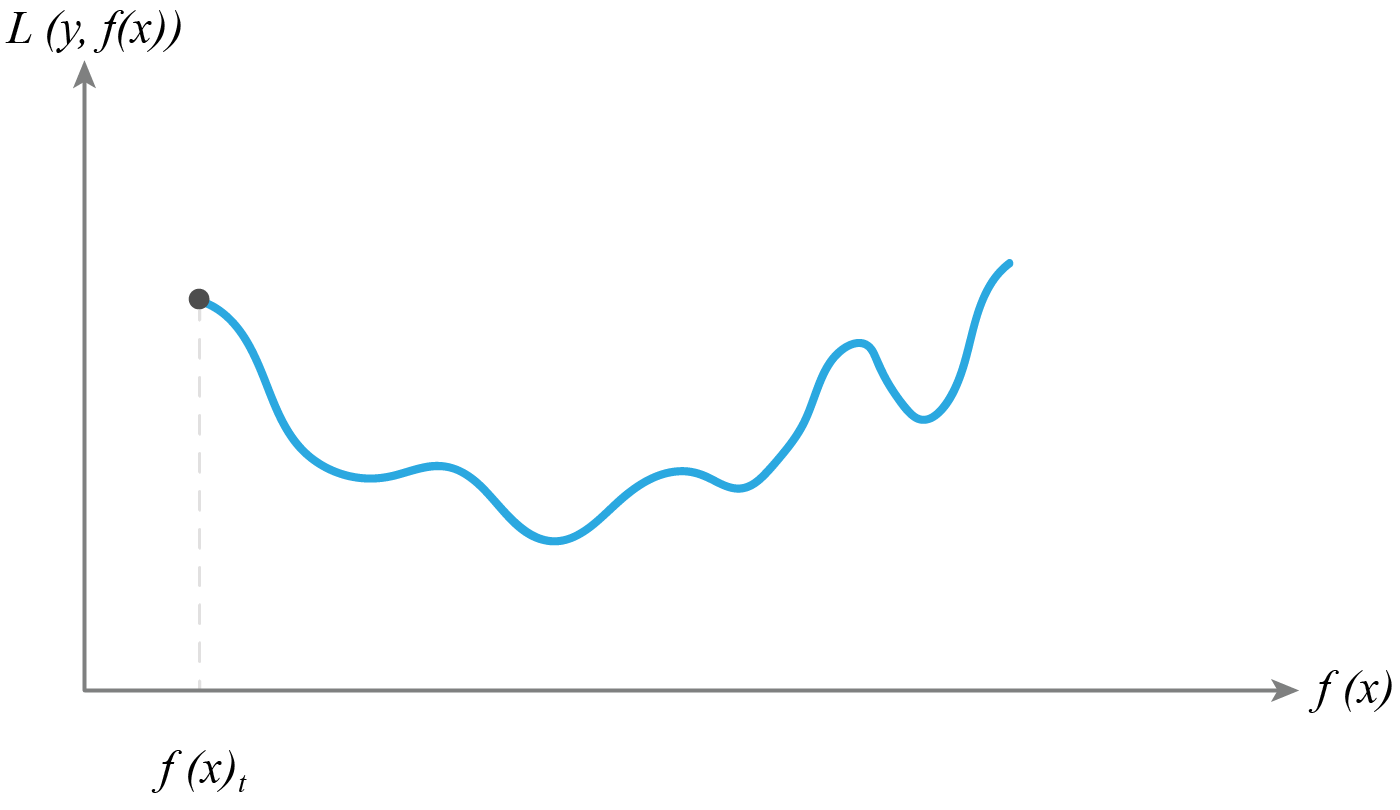

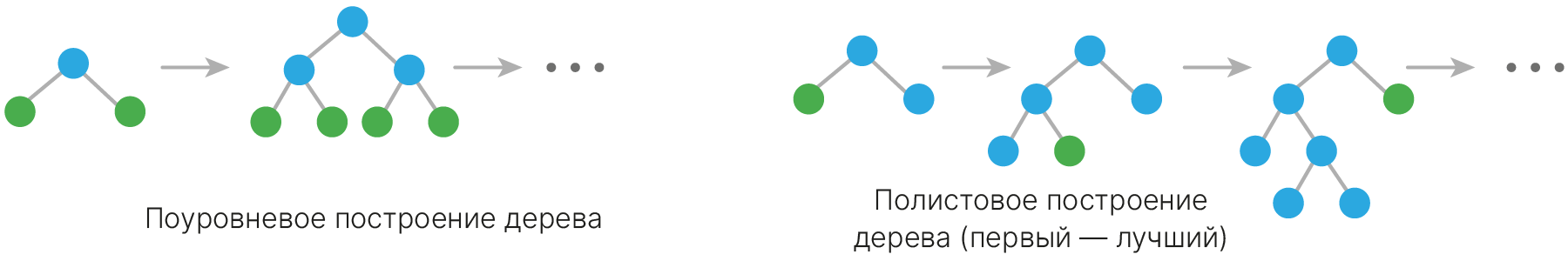

Из предыдущей части мы увидели, что использование bagging или RSM для SVM или подобных моделей не несет большого смысла. Но для деревьев решений это не так. Будем брать деревья большой глубины. Незначительные изменения в данных приводят к значительным изменениям в топологии таких деревьев. Таким образом, мы приходим к случайному лесу = Bagging + RSM над деревом решений.

При этом RSM в классическом случайном лесе делается не на уровне дерева, а на уровне узла. В каждом узле дерева, когда мы выбираем лучшее разбиение его на два дочерних, мы просматриваем не все признаки, а только определенное их количество.

Случайный лес работает лучше, чем отдельное случайно взятое дерево. Но главное, что случайный лес намного более устойчив к шуму. Это свойство до сих пор позволяет случайному лесу успешно использоваться в областях с шумными данными.

Для случайного леса верно следующее: когда мы берем множество базовых классификаторов (в данном случае деревьев) и усредняем их, то результат этих усреднений стремится к идеальному дереву решений, причем построенному на идеальных, а не на исходных признаках.

Проверим это на задаче регрессии California Housing dataset 🛠️[doc].

calif_housing = sklearn.datasets.fetch_california_housing()

x = calif_housing.data

y = calif_housing.target

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=42)

Данные — средние характеристики квартиры в доме. Цель — предсказать цену на дом.

Создадим несколько случайных лесов с различным количеством деревьев и простое дерево решений для сравнения с ним (baseline).

from sklearn.ensemble import RandomForestRegressor

from sklearn.tree import DecisionTreeRegressor

models_rf = {}

# add single decision tree for comparison

models_rf["DT"] = GridSearchCV(

DecisionTreeRegressor(),

{"max_depth": [1, 3, 5, 7, 10], "min_samples_leaf": [1, 3, 5, 10]},

)

# this can be done faster, see warm_start parameter for this

# (https://stackoverflow.com/questions/42757892/how-to-use-warm-start)

for n_estimators in [3, 5, 10, 50, 100, 150, 250]:

models_rf[f"RF{n_estimators}"] = RandomForestRegressor(

n_estimators=n_estimators, random_state=42, n_jobs=-1

) # run in parallel

Обучим все модели. Для этого напишем вспомогательную функцию, которая будет обучать переданные ей модели и считать для них качество на тесте.

from sklearn.metrics import mean_squared_error

def train_and_test_regressor(models, x_train, y_train, x_test, y_test, verb=True):

boot_scores = {}

for name, model in models.items():

model.fit(x_train, y_train) # train the model

y_pred = model.predict(x_test) # get predictions

boot_scores[name] = bootstrap_metric( # calculate bootstrap score

y_test,

y_pred,

metric_fn=lambda x, y: mean_squared_error(y_true=x, y_pred=y),

)

if verb:

print(f"Fitted {name} with bootstrap score {boot_scores[name].mean():.3f}")

results = pd.DataFrame(boot_scores)

return results

results_rf = train_and_test_regressor(models_rf, x_train, y_train, x_test, y_test)

Fitted DT with bootstrap score 0.395 Fitted RF3 with bootstrap score 0.338 Fitted RF5 with bootstrap score 0.302 Fitted RF10 with bootstrap score 0.277 Fitted RF50 with bootstrap score 0.257 Fitted RF100 with bootstrap score 0.254 Fitted RF150 with bootstrap score 0.252 Fitted RF250 with bootstrap score 0.252

plt.figure(figsize=(16, 6))

sns.boxplot(data=results_rf)

plt.ylabel("MSE", size=20)

plt.xlabel("n_estimators", size=20)

plt.title("Number of estimators vs MSE", size=20)

plt.tick_params(axis="both", which="major", labelsize=14)

plt.show()

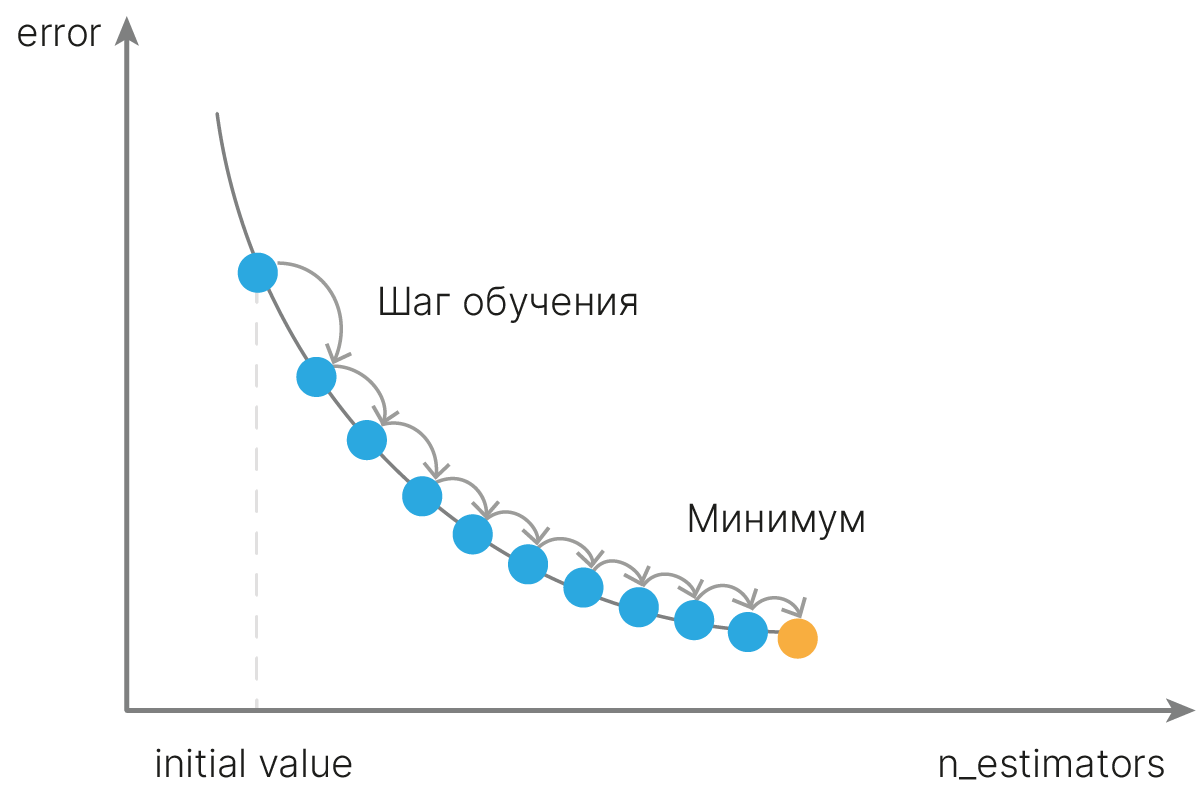

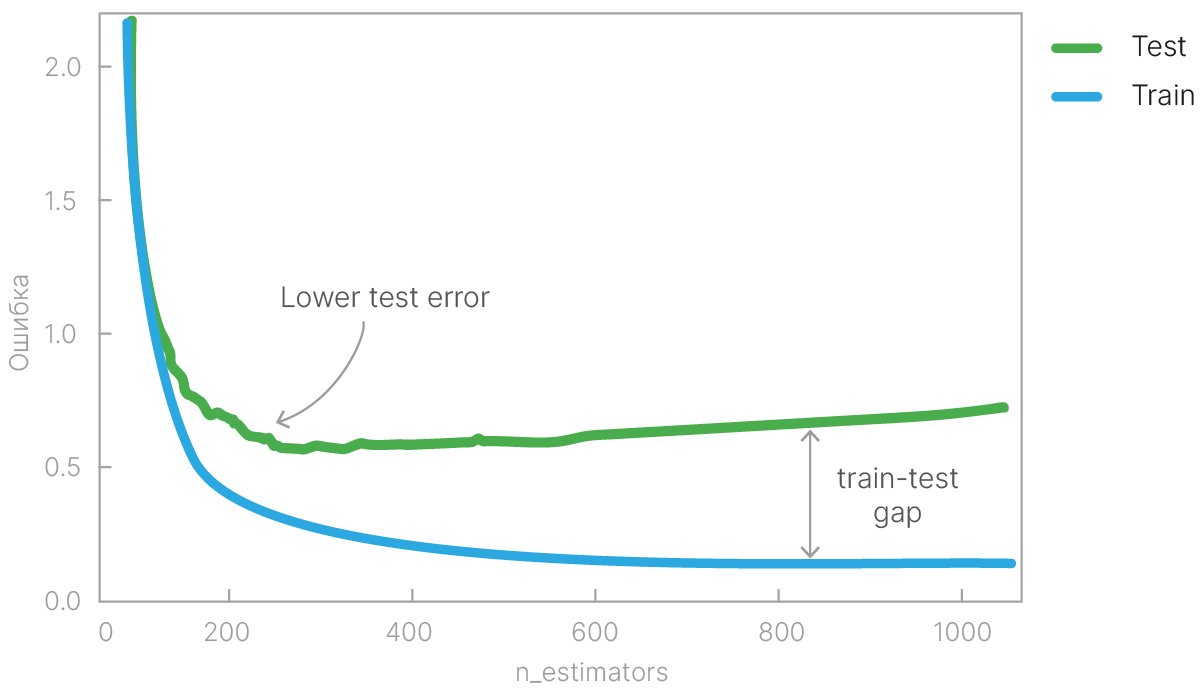

Увеличение числа базовых моделей сначала сильно улучшает качество модели. Однако после определенного количества базовых моделей улучшение качества становится незначительным.

Чем больше глубина дерева, тем большая нескорелированность базовых моделей будет получаться. В общем случае в случайном лесе важно использовать именно глубокие деревья, причем в большинстве случаев их глубину не надо ограничивать (или ограничивать большими значениями порядка 10–12).

Обучим случайный лес с заданной глубиной дерева и сравним с одиночным деревом такой же глубины.

dt_depth = {}

rf_depth = {}

for depth in range(1, 20, 2):

dt_depth[depth] = DecisionTreeRegressor(max_depth=depth, random_state=42)

rf_depth[depth] = RandomForestRegressor(

n_estimators=100, max_depth=depth, random_state=42, n_jobs=-1

) # run in parallel

dt_res = train_and_test_regressor(

dt_depth, x_train, y_train, x_test, y_test, verb=False

)

rf_res = train_and_test_regressor(

rf_depth, x_train, y_train, x_test, y_test, verb=False

)

dt_res = dt_res.melt(value_vars=dt_res.columns, value_name="mse", var_name="tree_depth")

dt_res["model"] = "DT"

rf_res = rf_res.melt(value_vars=rf_res.columns, value_name="mse", var_name="tree_depth")

rf_res["model"] = "RF"

depth_res = pd.concat((dt_res, rf_res))

plt.figure(figsize=(12, 8))

sns.boxplot(data=depth_res, x="tree_depth", y="mse", hue="model")

plt.xlabel("Tree depth", size=20)

plt.ylabel("MSE", size=20)

plt.title("Tree depth vs MSE", size=20)

plt.legend()

plt.tick_params(axis="both", which="major", labelsize=14)

plt.show()

Лучшие результаты показывает случайный лес из наиболее глубоких деревьев.

Качество случайного леса с малой глубиной дерева не отличается от качества одиночного дерева той же глубины. Это связано с тем, что деревья малой глубины слабо отличаются друг от друга (высокий bias и низкий variance), потому усреднение их предсказаний почти не улучшает качество.

Отметим, что в случае малых выборок ограничения на глубину дерева могут дать выигрыш.

Иногда качество случайного леса можно улучшить, если поставить небольшое ограничение на минимальное число объектов в листе, чтобы запретить явно переобученные деревья.

dt_models_min_samples = {}

rf_models_min_samples = {}

for mn_sm in [1, 3, 5, 7, 10]:

dt_models_min_samples[mn_sm] = DecisionTreeRegressor(

max_depth=None, min_samples_leaf=mn_sm, random_state=42

)

rf_models_min_samples[mn_sm] = RandomForestRegressor(

n_estimators=100,

max_depth=None,

min_samples_leaf=mn_sm,

random_state=42,

n_jobs=-1,

) # run in parallel

dt_results_mn_samples = train_and_test_regressor(

dt_models_min_samples, x_train, y_train, x_test, y_test

)

rf_results_mn_samples = train_and_test_regressor(

rf_models_min_samples, x_train, y_train, x_test, y_test

)

dt_results_mn_samples = dt_results_mn_samples.melt(

value_vars=dt_results_mn_samples.columns, value_name="mse", var_name="min_samples"

)

dt_results_mn_samples["model"] = "DT"

rf_results_mn_samples = rf_results_mn_samples.melt(

value_vars=rf_results_mn_samples.columns, value_name="mse", var_name="min_samples"

)

rf_results_mn_samples["model"] = "RF"

leaf_res = pd.concat((dt_results_mn_samples, rf_results_mn_samples))

Fitted 1 with bootstrap score 0.528 Fitted 3 with bootstrap score 0.446 Fitted 5 with bootstrap score 0.428 Fitted 7 with bootstrap score 0.405 Fitted 10 with bootstrap score 0.388 Fitted 1 with bootstrap score 0.254 Fitted 3 with bootstrap score 0.256 Fitted 5 with bootstrap score 0.260 Fitted 7 with bootstrap score 0.266 Fitted 10 with bootstrap score 0.274

plt.figure(figsize=(12, 8))

sns.boxplot(data=leaf_res, x="min_samples", y="mse", hue="model")

plt.xlabel("Tree depth", size=20)

plt.ylabel("MSE", size=20)

plt.title("Tree depth vs MSE", size=20)

plt.legend()

plt.tick_params(axis="both", which="major", labelsize=14)

plt.show()

В данном случае, однако, ограничение на количество объектов в листе ухудшает качество ансамбля. Одна из причин заключается в том, что с увеличением числа ограничений на дерево уменьшается непохожесть деревьев друг на друга, и качество случайного леса так же начинает уменьшаться.

Существует мнение, что случайный лес не переобучается. Это не так. Можно подобрать такие два набора параметров, что первый даст лучшее качество на тренировочной выборке, а второй — на тестовой. При этом увеличение числа деревьев в ансамбле с этим справиться поможет слабо.

Возьмем, к примеру, наш синтетический пример на плоскости.

from sklearn.ensemble import RandomForestClassifier

x, y = sklearn.datasets.make_moons(n_samples=500, noise=0.30, random_state=42)

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=42)

plt.figure(figsize=(16, 6))

plt.subplot(121)

clf = DecisionTreeClassifier(max_depth=10, random_state=42)

clf.fit(x_train, y_train)

plot_decision_boundary(clf, x, y)

plt.title("Single Decision Tree", fontsize=14)

plt.subplot(122)